Зачем нам нужен QoS?

QoS (приоритезация данных) предназначена для обеспечения эффективной работы сети, когда она загружена или перегружена. Она позволяет приоритезировать траффик и минимизировать последствия высокой нагрузки.

Как настроить QoS?

К примеру, у меня есть несколько устройств, которые подключены к моей Wi-Fi сети.

Я бы хотел:

- Использовать FTP-сервер на максимальной скорости

- Использовать телефон для выхода в интернет на средней скорости

Шаг 1.

Откройте веб-браузер и наберите в адресной строке http://tplinkwifi.net или http://192.168.0.1 и зайдите в веб-интерфейс роутера, используя логин и пароль, установленные ранее. По умолчанию установлен логин и пароль “admin”.

Шаг 2.

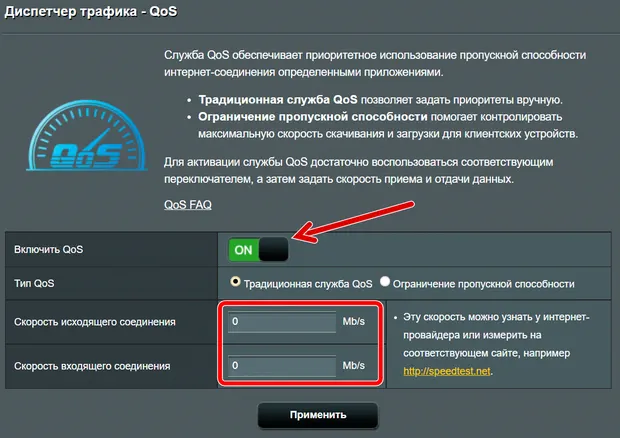

Откройте Расширенные настройки (Advanced)> Приоритезация данных (QoS)

Отметьте Включить приоритезацию данных (Enable QoS)

Заметка: QoS и NAT Boost не могут работать одновременно, для начала вам следует отключить NAT Boost. Пожалуйста, выполните шаг а и б для отключения NAT Boost.

а. Нажмите NAT Boost.

б. Снимите галочку с пункта Enable NAT Boost и нажмите Сохранить (Save), затем нажмите OK в всплывающем окне.

Шаг 3

Установите максимальную скорость отдачи и загрузки, предоставляемую вашим интернет-провайдером. 1 Мбит соответствует 1024 Кбит.

Нажмите Дополнительные настройки (Advanced) и перетащите отметку для выбора уровня приоритета полосы пропускания. Затем, нажмите Сохранить (Save).

Замечание: Для каждого приоритета нельзя установить значение более 100%. Высокий приоритет (High priority) больше, чем средний приоритет (Middle priority), и средний приоритет больше, чем низкий приоритет (Low priority).

Шаг 4

Добавьте правила QoS (правила приоритезации трафика).

1) Установите правило с высоким приоритетом для FTP-сервера.

а. Нажмите Добавить (Add) в секции Высокий приоритет (High Priority).

б. Выберите По приложению (By Application) и затем выберите ftp из списка и нажмите OK.

Совет: если вашего приложения не окажется в списке, нажмите Приложение по выбору (Custom Application) и добавьте приложение вручную.

• Имя (Name): Введите имя вашего приложения.

• Протокол (Protocol): Выберите протокол вашего приложения, если не уверены, выберите ВСЕ (ALL).

• Порт (Port): Введите порт назначения для приложения, обычно у каждого приложения есть свой фиксированный порт, пожалуйста, проверьте правильность ввода порта. В нашем примере, порт назначения для ftp 21.

2) Установите правило среднего приоритета для телефона.

a. Нажмите Добавить (Add) в секции Средний приоритет (Middle Priority).

b. Выберите По устройству (By Device) и затем нажмите Просмотр существующих устройств (View Existing Devices).

c. Выберите соответствующее устройство из списка.

d. Нажмите OK.

Затем, список правил QoS появится в таблице.

Совет: Если вы хотите удалить правило QoS, нажмите иконку для удаления правила из списка.

Шаг 5.

Готово! Теперь QoS настроен для приоритезации интернет-трафика.

Узнайте больше о каждой функции и конфигурации, перейдите в Загрузки, чтобы загрузить руководство по вашему устройству.

Был ли этот FAQ полезен?

Ваш отзыв поможет нам улучшить работу сайта.

Что вам не понравилось в этой статье?

- Недоволен продуктом

- Слишком сложно

- Неверный заголовок

- Не относится к моей проблеме

- Слишком туманное объяснение

- Другое

Как мы можем это улучшить?

Спасибо

Спасибо за обращение

Нажмите здесь, чтобы связаться с технической поддержкой TP-Link.

Вы здесь, потому что у вас возникла проблема с передачей голоса по IP (VoIP) или вызовами для видеоконференции? Или, может быть, у вас общие проблемы со скоростью вашего интернета? Вы не одиноки!

Этот пост поможет вам настроить существующий маршрутизатор, чтобы получить наилучшие впечатления от онлайн-общения в реальном времени, потоковой передачи с онлайн-кинотеатра или любых других вещей, которые вы делаете в Интернете, если на то пошло.

Всё дело в QoS.

QoS – что это такое

QoS означает качество обслуживания – функцию маршрутизации, которая позволяет пользователям определять приоритеты полосы пропускания для определенных программ, клиентов или служб.

Как это работает? QoS берёт существующее широкополосное соединение и резервирует определенный объём запрашиваемой полосы пропускания для цели в режиме реального времени относительно остальной части сети.

Например, если вы установите приоритет VoIP, ваши интернет-вызовы получат всю необходимую полосу пропускания раньше, чем любые другие приложения. Или, если вы отдаёте приоритет своему Xbox (или конкретной игре), тогда игровая консоль получит главные фишки в вашем интернет-соединении перед любыми другими устройствами.

И вы можете делать это с чем угодно, например, с потоковой трансляцией или онлайн-серфингом. Вы даже можете сделать это с загрузкой файлов, хотя этого я не рекомендую.

Скачивание файлов никогда не требует расстановки приоритетов. Напротив, это главная причина, по которой вам нужен QoS. Если оставить всё как есть, загрузка файла потребует всей полосы пропускания, независимо от скорости подключения к Интернету, пока она не будет завершена.

Таким образом, QoS иногда используется с обратной целью – дать определенным устройствам или службам самый низкий приоритет, чтобы убедиться, что они не будут мешать нормальной работе остальной сети.

При правильной настройке – это непростая задача – QoS может порадовать всех, даже если у вас скромное подключение к Интернету.

QoS против скорости Интернета

Важно отметить, что QoS – это не повышение скорости вашего Интернета! Речь идёт о том, чтобы дать вам именно то, что вам (вашему устройству) нужно, но не больше.

Следовательно, когда вы включаете QoS, вы, как правило, получаете более медленные результаты тестирования скорости – и в этом суть, потому что тестирование скорости – это не то, как мы обычно используем Интернет.

Кроме того, если вы неправильно сконфигурируете QoS и установите его скорость загрузки значительно ниже, чем фактическая скорость вашего доступа, тогда установленная скорость QoS будет потолком.

Если вы включили QoS в своём маршрутизаторе и обновили свой Интернет до более высокого уровня скорости, убедитесь, что вы изменили настройки QoS. В противном случае, вы продолжите жить в пределах прежней скорости.

Что вам нужно для использования QoS

Чтобы воспользоваться преимуществами QoS, как правило, необходимы две вещи.

- Маршрутизатор, поддерживающий эту функцию. Большинство, если не все, домашние маршрутизаторы Wi-Fi имеют QoS, но способ их реализации варьируется от одного поставщика к другому. Когда дело касается этой особенности, существует множество степеней и нюансов. По моему опыту, маршрутизаторы Asus хорошо поддерживают эту функцию и допускают простую настройку. Неплохие реализации у Linksys, Netgear и TP-Link.

- Во-вторых, вам необходимо знать фактическую скорость и качество вашего интернет-соединения. Это довольно легко узнать – я написал длинную статью о тестировании скорости, если вам нужно знать точные числа и их значение. Но, в целом, вы можете сделать быстрый тест скорости прямо сейчас, чтобы узнать свои приблизительные цифры.

Сделали? Надеюсь, у вас хорошие цифры.

Лучше знать свою точную скорость вашего доступа при настройке QoS. Но, вы можете указать немного более низкую скорость для вашего QoS. Так, если у вас скорость загрузки 500 Мбит/с, вы можете указать 450 Мбит/с.

Никогда не стоит использовать большее число (например, 550 Мбит/с). В этом случае QoS может вообще не дать значимого результата. Это может даже ухудшить ситуацию.

Правило таково: настройте QoS на использование максимально близкой к точной ширине полосы пропускания, но никогда не превышайте её.

Давайте установим правильные ожидания относительно того, что вы можете получить от своего Интернета с поддержкой QoS.

Правильные ожидания от использования QoS

Чтобы QoS было эффективным, ваш Интернет должен быть, по крайней мере, достаточно быстрым, а ещё лучше – более быстрым, чем требуется приоритетной стороне. Так, скажем, если вашему приложению требуется скорость загрузки 25 Мбит/с, а ограничение на соединение – 20 Мбит/с, в этом случае никакое QoS не поможет.

Я не зря выбрал 25 Мбит/с. Это скорость загрузки, необходимая для потоковой передачи контента 4K на одно устройство. Поэтому, если вы страдаете от буферизации и времени ожидания при потоковой передаче через скромное интернет-соединение, не обвиняйте сразу в этом свой Wi-Fi – это разные вещи.

Кроме того, QoS не может улучшить качество вашего интернет-соединения. Например, если ваша связь имеет высокую задержку (пинг), что ужасно для связи в реальном времени, QoS не улучшит это. Всё, что он может сделать, – это предоставить конкретному приложению, услуге или клиенту в вашей сети наилучшие возможности из того, что у вас есть.

Наконец, QoS обычно не требуется, если у вас высокоскоростное широкополосное соединение, которое имеет достаточную пропускную способность для всех ваших приложений одновременно. Но, даже в этом случае, если вы знаете, что кто-то в вашем доме регулярно загружает файлы, например, с помощью BitTorrent-клиента, то всё же неплохо включить эту функцию. Это типичный случай, когда применяется QoS с низким приоритетом, как упомянуто выше.

Требования к связи для VoIP и видеоконференцсвязи

Как правило, соединение со скоростью загрузки 50 Мбит/с / передачи 15 Мбит/с или быстрее достаточно практически для любого онлайн-приложения. Одного экземпляра приложения.

Если у вас несколько приложений, имейте в виду, что каждое из них требует одинаковой полосы пропускания. Например, большинству приложений для видеоконференций требуется не менее 2 Мбит/с на экран.

На самом деле, вероятно, оно будет использовать больше, если вы делаете это в Full HD или 4K. Поэтому для уверенности выделите каждому экрану 25 Мбит/с.

Каналы загрузки/передачи различаются. Но если вы хотите, чтобы люди на другом конце провода видели вас в HD, вам также понадобится 25 Мбит/с для передачи. К сожалению, большинство кабельных сетей не могут обеспечить этого, поскольку они ограничиваются скоростью около 15 Мбит/с. Скорее всего, вы сможете транслировать себя только в низком разрешении.

Требования к задержке при голосовой/видеосвязи через Интернет относительно невысоки. В частности, для правильной работы VoIP ваше соединение должно иметь менее 150 мс (миллисекунд) и 30 мс в значениях Ping и Jitter, соответственно. (В идеале эти числа должны составлять 15 мс и 10 мс, соответственно.)

Важно отметить, что вы должны оставаться относительно в одном месте (или в одной комнате) во время голосового или видеозвонка – ещё лучше, запустите соединение Wi-Fi в этом же месте. Если у вас есть привычка перемещаться по своему (большому) дому, ни один маршрутизатор или система не смогут заставить это работать. Так что QoS тоже не поможет.

Между прочим, качество связи в реальном времени зависит от обоих сторон. Дело в том, что не стоит сразу обвинять ваш Интернет в неудовлетворительном опыте – это может быть вина второй стороны.

Как настроить QoS вашего роутера

Способ работы с QoS зависит от маршрутизатора. Как правило, маршрутизаторы от одного производителя используют один и тот же интерфейс или мобильное приложение, поэтому пользователи могут настраивать свои параметры одинаковым образом.

Веб-интерфейс всегда является лучшим способом управления маршрутизатором, поскольку он даёт детализированный доступ ко всем функциям и настройкам. И QoS – одна из таких дополнительных функций. Но некоторые поставщики, например, Linksys, позволяют настраивать эту функцию через мобильное приложение.

Я всегда предпочитаю веб-интерфейс, и вот общие шаги по настройке QoS:

-

Войдите в интерфейс вашего роутера

Для этого перейдите в своём браузере (Chrome, Firefox или Edge) на IP-адрес маршрутизатора по умолчанию (или удобный URL).

Если вы не знаете свой, проверьте стандартные IP-адреса в таблице ниже. И войдите в систему с учетной записью администратора вашего роутера.

Производитель URL IP Username Пароль Asus router.asus.com 192.168.1.1

192.168.50.1admin admin D-Link dlinkrouter.local 192.168.0.1

192.168.1.1n/a admin Netgear routerlogin.com 192.168.1.1 admin password Linksys myrouter.local 192.168.0.1

192.168.1.1n/a admin TP-Link tplinkwifi.net 192.168.0.1 admin admin Большинство кабельных модемов N/A 192.168.100.1 n/a admin

password

default -

Настройте функцию QoS маршрутизатора (для VoIP)

Эта функция почти всегда находится в расширенной области интерфейса. Обычно в названии есть «QoS» или «Приоритизация».

Вам необходимо указать скорости загрузки и выгрузки вашего соединения. В этом случае введите точные цифры или немного меньшие.

Опять же, определенно не вводите цифры, превышающие вашу фактическую скорость загрузки и выгрузки. Некоторые маршрутизаторы могут вычислить эти числа самостоятельно.

Теперь убедитесь, что вы расставили приоритеты для QoS в соответствии с вашими потребностями. Выберите VoIP и видеозвонки как свои главные приоритеты.

Если нет возможности установить приоритет службы или приложения, вы можете выбрать приоритетность конкретного клиента, на котором вы будете использовать службу. Поэтому, если вы используете iPad для конференц-связи, сделайте iPad наиболее приоритетным.

Обратите внимание: если вы решите установить приоритет определенного устройства, рекомендуется зарезервировать IP-адрес этого устройства в маршрутизаторе, чтобы он не изменился.

-

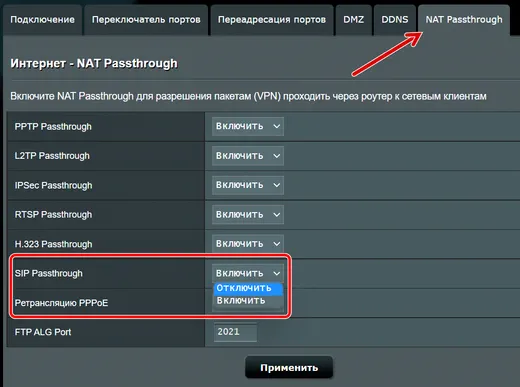

Дополнительно: отключить SIP ALG (или SIP Passthrough)

Этот параметр применяется, когда вам нужно, чтобы ваш маршрутизатор хорошо работал для передачи голоса по IP, и даже в этом случае только в определенных ситуациях. Так что это то, что нужно попробовать, когда у вас есть проблемы с вызовами Wi-Fi, например, задержки.

SIP ALG расшифровывается как Application Layer Gateway, параметр доступен в большинстве домашних маршрутизаторов и включен по умолчанию. Первоначально этот параметр предназначен для улучшения прохождения пакетов VoIP через межсетевой экран маршрутизатора. На самом деле, это редко срабатывает так, как ожидалось, и часто вызывает проблемы.

Вам может потребоваться выключить (или отключить) SIP ALG (также известный как SIP Passthrough или SIP), чтобы улучшить работу с VoIP. Расположение настройки SIP может быть разным, но обычно вы можете найти его в области WAN (Интернет) или межсетевого экрана интерфейса маршрутизатора.

-

Примените изменения

После того, как вы изменили настройку, обязательно примените её. В некоторых случаях маршрутизатор может перезапуститься. Даже если у вас этого не произошло, рекомендуется вручную выключить и включить его, а затем снова проверить, чтобы убедиться, что новые настройки установлены правильно.

Теперь сила QoS на вашей стороне.

Оптимизация QoS для голосовой и видеосвязи (на примере Asus)

Если у вас есть маршрутизатор Asus, выполните следующие действия по настройке QoS для голосовой и видеоконференцсвязи. Хотя они не такие, как в маршрутизаторах другого производителя, они дадут вам несколько идей.

-

Войдите в веб-интерфейс вашего роутера

На подключенном компьютере укажите в браузере router.asus.com, и вы откроете интерфейс. Введите свое имя пользователя и пароль и нажмите Войти.

-

Обновите роутер до последней прошивки

- Нажмите на пункт меню «Администрирование».

- Перейдите на вкладку Обновление микропрограммы.

- Нажмите кнопку Проверить для получения новой версии прошивки. Кроме того, вы также можете загрузить прошивку прямо с сайта производителя. В этом случае используйте кнопку Загрузить, чтобы вручную загрузить прошивку в маршрутизатор.

- Выполните оставшуюся часть процесса, чтобы обновить прошивку маршрутизатора до последней версии.

Примечание. Не выключайте маршрутизатор во время процесса обновления, который займёт не более 5 минут. После этого рекомендуется вручную перезапустить маршрутизатор.

-

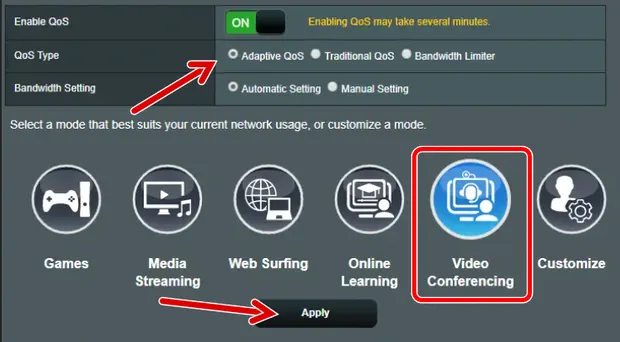

Включите функции Adaptive QoS

- Щелкните пункт меню Adaptive QoS, а затем вкладку QoS.

- Активируйте параметр Включить QoS.

- Нажмите кнопку «Видеоконференцсвязь».

Примечание. В некоторых моделях маршрутизаторов связь в режиме реального времени входит в категорию «Работа из дома».

- Необязательно: нажмите «Настроить» и перетащите блоки других категорий в соответствии с вашими потребностями – вы можете навести указатель мыши на каждый блок, чтобы увидеть, какой тип приложений / услуг включает в себя эта категория. Затем нажмите Сохранить.

- Щёлкните Применить.

Маршрутизатору потребуется несколько секунд, чтобы применить изменения.

-

Отключите сквозную передачу SIP (при необходимости)

- Щелкните меню Интернет (в разделе «Дополнительные настройки»), а затем перейдите на вкладку NAT Passthrough.

- Измените значение SIP Passthrough на Отключить

- Нажмите Применить и дождитесь, пока маршрутизатор применит изменения.

- Перезапустите маршрутизатор вручную и убедитесь, что всё в порядке.

И это всё! Теперь ваш роутер Asus должен работать лучше для вашего приложения для онлайн-коммуникаций.

Интернет-трафик чем-то похож на денежный поток для домашнего хозяйства (или бизнеса) – всё дело в том, чтобы управлять своими доходами и расходами и оставаться в рамках бюджета. И здесь в игру вступает QoS.

Опять же, эта функция предназначена для предоставления устройству необходимой полосы пропускания (и не более), когда она ему нужна. Это не делает ваш Интернет быстрее!

Вместе с тем, при правильной настройке QoS вы удивитесь, насколько мало пропускной способности Интернета вам действительно нужно. И, наоборот, в плохо настроенной сети даже гигабитный широкополосный доступ не всегда достаточно быстр для каждого устройства в сети.

Приоритизация трафика — идея не новая. Уровень важности пакетов в сети Ethernet уже могли задавать в 1981 году. Но однозначного мнения об эффективности приложений, оптимизирующих трафик, нет до сих пор. Одни уверены, что могут поднять скорость соединения на 10–20%. Другие утверждают, что толку от таких программ ноль, и они только впустую нагружают процессор. Пробуем разобраться, где правда.

Что такое приоритизация трафика

Если активное соединение одно, то и приоритизировать нечего — весь канал целиком отдается под это соединение и скорость его зависит только от пропускной способности канала. Но если соединений несколько, то они начинают мешать друг другу. Идея приоритизации состоит в том, чтобы пакеты, помеченные как «важные», пропускать в первую очередь, а менее важные — придерживать, пока линия не освободится. Например, если у вас идет скачивание файла, и одновременно вы играете в онлайн-игру, разумно будет выдать высший приоритет игровому соединению. Может, скачивание файлов при этом пойдет медленнее, зато у вас не будет лагов во время игры.

В стандарте Ethernet прописана поддержка механизма приоритизации, называемого QoS («Quality of Service» — «Качество обслуживания»).

QoS и его поддержка на «последней миле»

QoS — сложный механизм, содержащий целую пачку технологий. Поддержка QoS подразумевает:

- правильную маркировку пакетов данных;

- формирование очередей отправки данных через один интерфейс;

- сброс «лишнего» трафика.

Настройка QoS на сетевых устройствах — отдельная непростая тема. Обычному пользователю это, чаще всего, не нужно.

Однако следует понимать, что поддержка QoS должна быть на каждом узле между отправителем и получателем данных в сети. С узлами вне вашего дома вы ничего не можете поделать, но поддержка QoS вашими устройствами от вас зависит. Если, к примеру, ваш роутер во всей цепочке узлов единственный не поддерживает QoS, весь эффект этой технологии пойдет насмарку.

Если вам важна гарантированная скорость некоторых видов соединений, роутер должен быть с поддержкой QoS. Более того, QoS часто выключена по умолчанию и ее следует включить. Как это сделать — читайте в руководстве на ваш роутер.

А еще желательно потратить некоторое время, разобраться в вопросе и правильно настроить параметры QoS в операционной системе компьютеров, подключенных к сети.

Если же на роутере нет поддержки QoS (или нет желания возиться с настройками), можно воспользоваться программами приоритизации трафика. Например, Netlimiter, Killer Intelligence center или cFosSpeed.

Работа программы приоритизации трафика cFosSpeed

Что делает cFosSpeed

Программа перехватывает сетевой трафик всех приложений и выставляет им приоритет в соответствии с заданными правилами. В cFosSpeed можно назначать приоритет, основываясь на виде приложения или используемом протоколе. Когда новое приложение выходит в сеть, cFosSpeed ищет это приложение и используемый им протокол в своих списках. Если правило для приложения (или протокола) найдено, его сетевым пакетам назначается соответствующий приоритет. В список приложений можно добавить свое — надо лишь нажать на кнопку «Добавить программу» и cFosSpeed предложит выбрать среди запущенных программ ту, сетевому трафику которой следует назначить особый приоритет.

Что же cFosSpeed делает для программ с высоким приоритетом? Пусть, например, у трафика MMORPG теперь наилучший приоритет — как это ускорит передачу данных с сервера, находящегося черт-те где? Правильно — никак.

cFosSpeed (как и любой другой механизм приоритизации трафика) не может ускорить передачу данных. Он может только перераспределить трафик разных приложений в пределах имеющейся пропускной способности.

cFosSpeed использует несколько способов приоритизации:

- Он маркирует пакеты в соответствии со своими правилами. Приложения могут самостоятельно ставить приоритет своим пакетам, и это никак не регулируется. Какая-нибудь малополезная утилита запросто может каждые пять минут «лезть» на свой сервер за обновлениями, выставляя своим пакетам наивысший приоритет и тормозя остальной трафик. cFosSpeed эту самодеятельность отменяет.

- Он устанавливает очередность отправки пакетов различных приложений.

- Он «притормаживает» входящий TCP-трафик приложений с низким приоритетом. За счет этого канал освобождается для входящего трафика более приоритетных приложений.

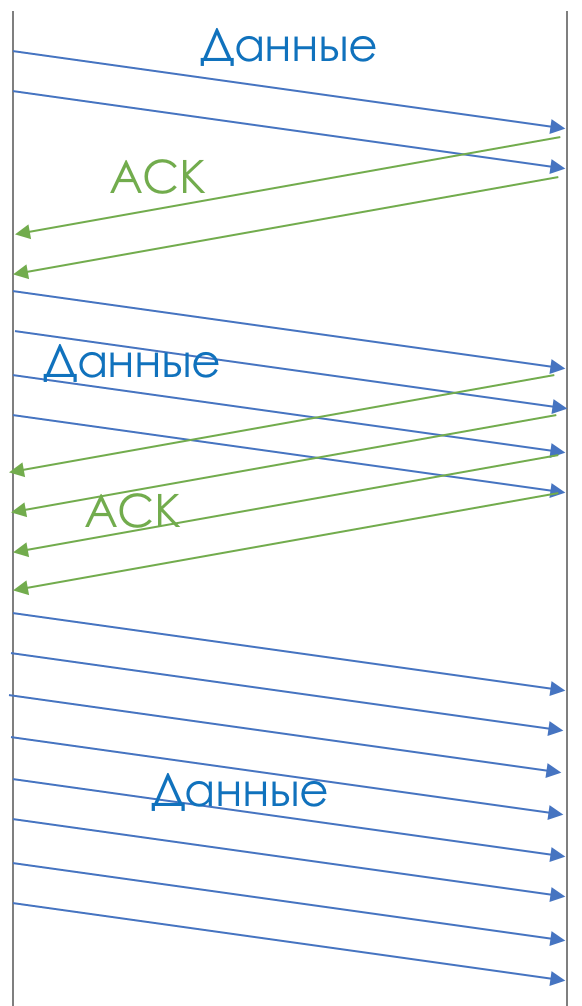

Каждый ТСР пакет с данными должен получить пакет-подтверждение (АСК-пакет) от получателя, только после этого будет отправлен следующий пакет. По умолчанию АСК-пакеты имеют наивысший приоритет. Но если задержать АСК-пакет, предназначенный отдельному приложению, его входящий трафик тормозится, освобождая канал для других приложений. - Он взаимодействует с другими копиями cFosSpeed на остальных компьютерах локальной сети. Это позволяет распространить правила на всю подсеть. Если, к примеру, на одном компьютере запущена программа с высоким приоритетом, то исходящий трафик с остальных компьютеров будет приторможен, чтобы с первого компьютера данные уходили без задержек. Это частично заменяет поддержку QoS на роутере.

Кроме того, cFosSpeed настраивает параметры сети для достижения наилучшего результата. В зависимости от требований приоритетного приложения это может быть либо «Максимальный пинг», либо «Максимальное использование канала».

Приоритизацию «Максимальный пинг» следует использовать там, где нужен максимально быстрый отклик сервера. Чаще всего такая необходимость возникает в онлайн-играх. При выборе этой цели cFosSpeed минимизирует окно приема ТСР-пакетов. Пакеты становятся маленькими, передаются быстро. Но возрастает количество служебной информации (заголовки пакетов, АСК-пакеты), поэтому пропускная способность канала падает.

«Максимальное использование канала», наоборот, увеличивает окно приема. Пакеты возрастают в объеме, количество служебной информации снижается, скорость вырастает. Но при потерях пакетов могут возникать продолжительные задержки. Эту политику следует использовать на линиях с малым количеством помех при необходимости получения максимальной скорости — например, при видеоконференциях или просмотре роликов в высоком качестве.

Чтобы cFosSpeed смог оценить качество и скорость вашего канала, при первом запуске следует произвести его калибровку: пункт меню «Приоритизация трафика — Калибровка линии».

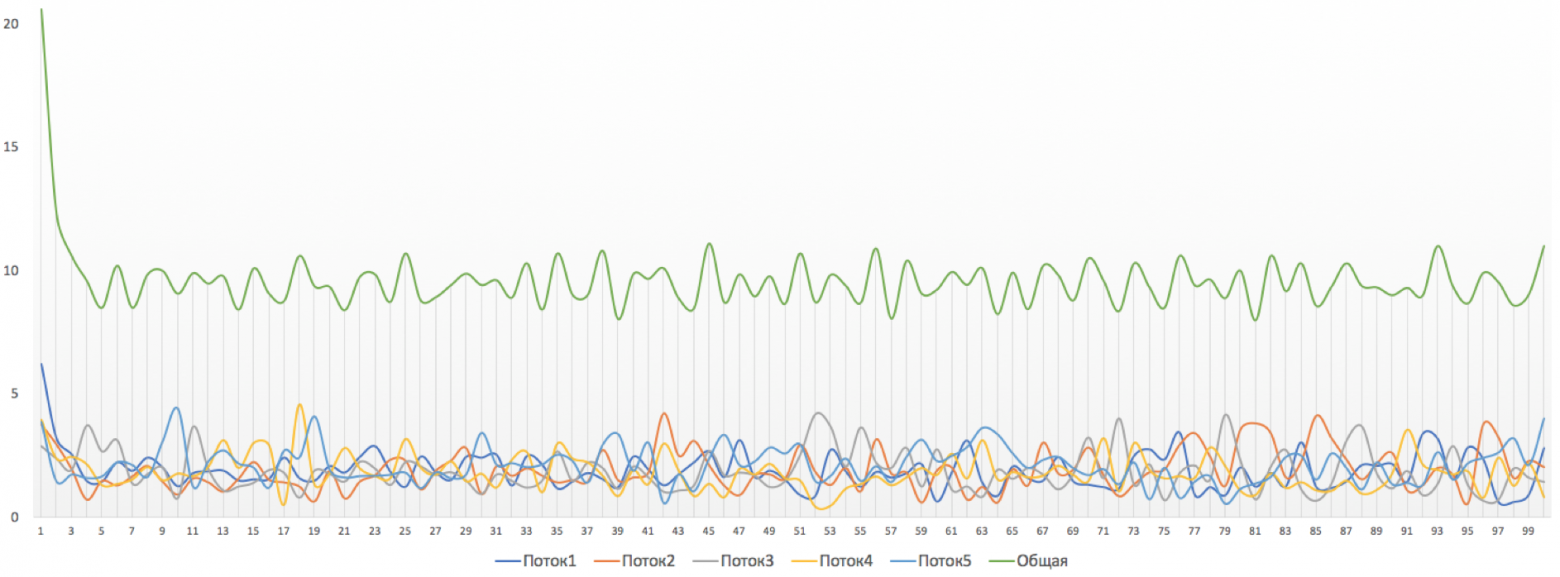

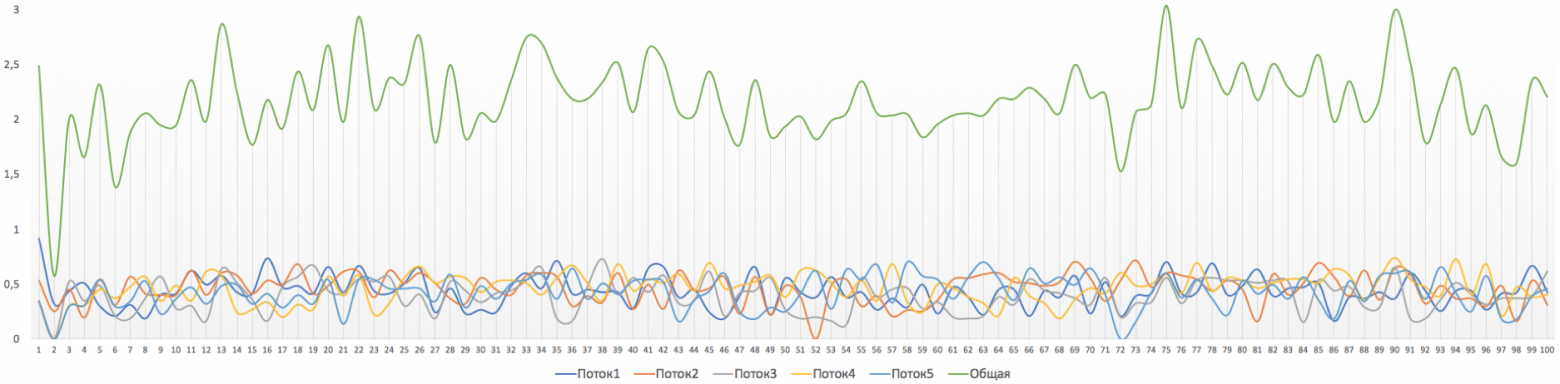

Тестирование cFosSpeed

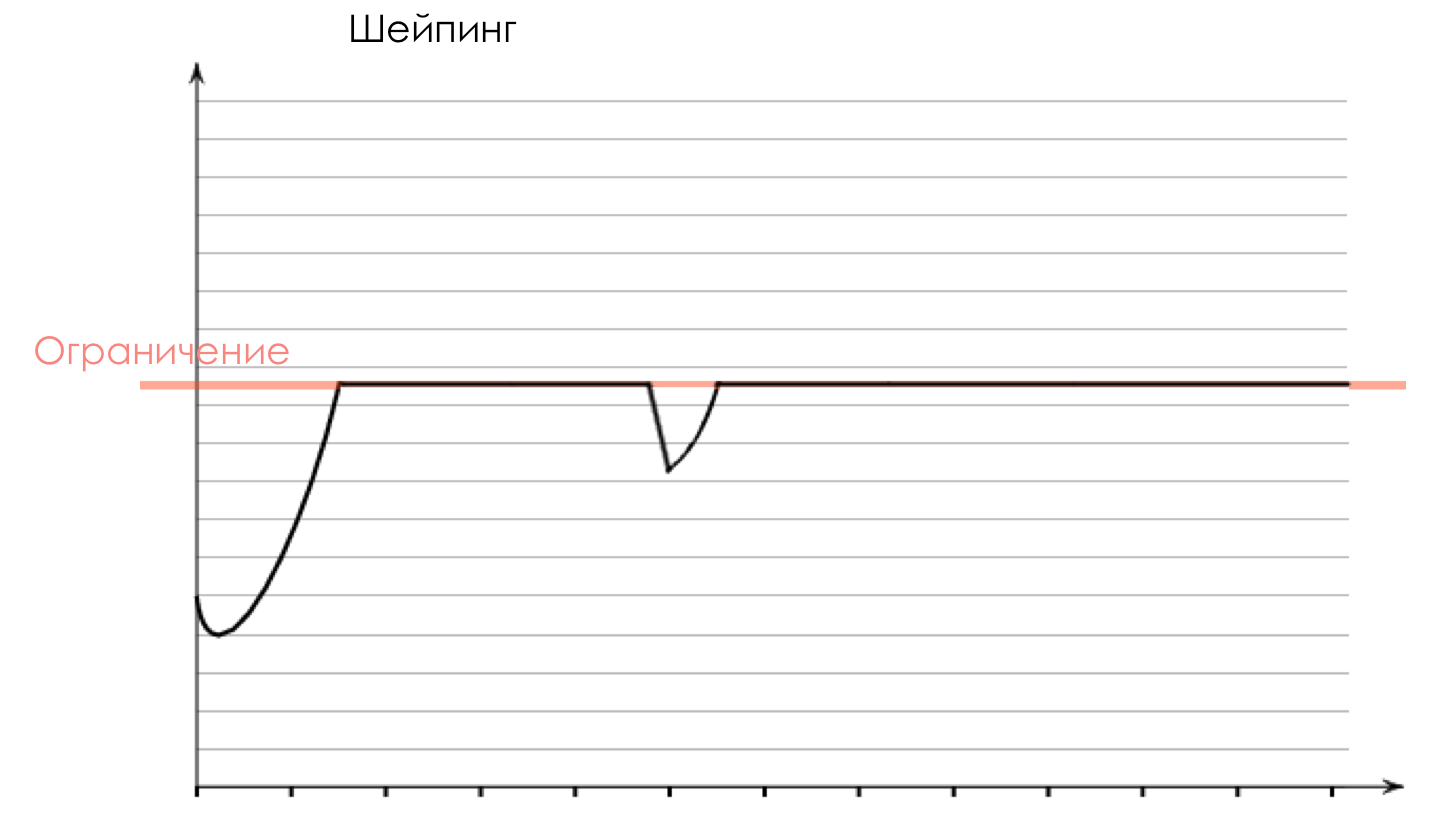

Эффект программ приоритизации трафика проявляется только при наличии нескольких соединений, полностью загружающих канал. Загружать компьютер будем одновременным просмотром 4х видео в высоком разрешении с Youtube, загрузкой большого файла в uTorrent и игрой World of Tanks. Одновременно запущен пинг игрового сервера WorldOfTanks.

Канал нагружен почти полностью, в основном, торрентом. 11 Мб/с.

Видео играет рывками. Средний пинг игрового сервера вроде бы неплохой — 29 мс. Но частые лаги и потери пакетов сильно портят картину.

А теперь включаем cFosSpeed. Он сразу определяет uTorrent и назначает ему минимальный приоритет.

Эффект заметен сразу — скорость загрузки файла падает вдвое.

На пинге игрового сервера это складывается вполне предсказуемым образом. Средний пинг снижается с 29 до 22 мс, а самое главное — периодические «тормоза» становятся намного меньше (в пределах 30 мс) и полностью исчезают потери пакетов.

Правда, видео продолжает периодически подтормаживать. А нельзя ли сделать так, чтобы и пинг был хороший, и видео играло?

В окне текущих подключений cFosSpeed позволяет задавать приоритет каждому активному приложению. Сменим приоритет Chrome (в нем открыты окна с Youtube) с default на high, а приоритет пинга сервера — с high на higher.

И — все работает: видео играет без рывков, пинг приемлемый. Чтобы убедиться, что это не случайность, повторяем эксперимент с включением/выключением приоритизации трафика еще пару раз.

Без приоритизации трафика:

C приоритизацией:

Эффект налицо, как говорится. При загрузке канала cFosSpeed действительно работает, и работает хорошо. А что будет, если убрать все лишнее (включая сам cFosSpeed) и оставить только пинг сервера?

То же, что и с включенной приоритизацией. Что вполне логично — при снижении количества потребителей трафика, его показатели доходят до максимальных величин. Проще говоря, вместо установки программы приоритизации трафика можно просто закрыть все лишние соединения — эффект будет тот же.

Плюсы и минусы программ приоритизации трафика

Минусы

- Программы создают дополнительную нагрузку на процессор, во многом дублируя встроенные в ОС механизмы. К примеру, в Windows приоритизацию трафика можно сделать с помощью установки групповых политик QoS.

- При использовании канала одним приложением программы приоритизации трафика скорее вредны, так как ускорить передачу данных не в состоянии, но при этом создают дополнительную нагрузку.

- Программы также бесполезны, если канал не загружен полностью.

- Многие программы будут неэффективны на системах, защищенных антивирусами. Например, Doctor Web для выявления сетевых атак пропускает весь трафик через свой драйвер. Соответственно, cFosSpeed вместо реальных получателей сетевых пакетов видит один только этот драйвер (dwnetfilter.exe).

Плюсы

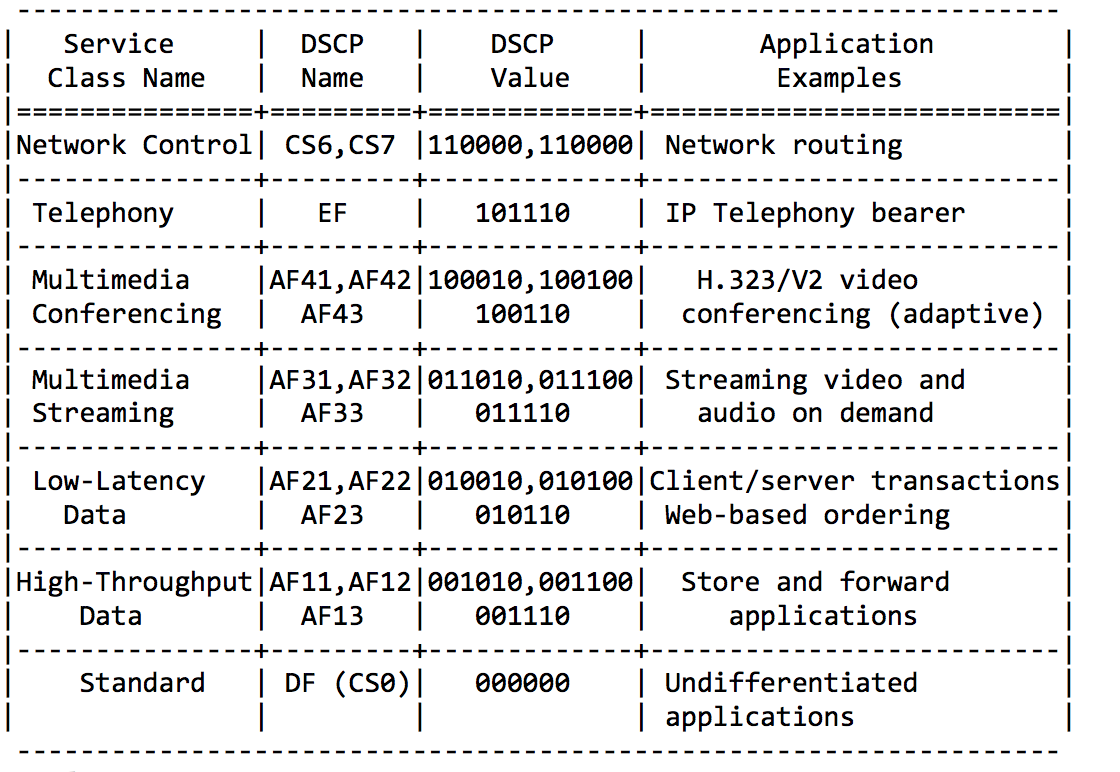

- Настройка программ приоритизации трафика намного проще, чем настройка политик QoS в том же Windows, например. Программы приоритизации используют интуитивно-понятный интерфейс и снабжены исчерпывающей справкой. А настройка QoS требует знания стандартов. Поди догадайся, что наивысший приоритет задается установкой DSCP в 46.

- При одновременной работе нескольких приложений с полной загрузкой канала программы приоритизации действительно обеспечивают наивысшую скорость соединения приоритетным приложениям.

- Программы приоритизации способны увеличить скорость даже отдельного соединения — но не за счет приоритизации, а за счет правильной настройки параметров сетевого соединения под канал. Это можно сделать и средствами системы, но надо знать, где и что настраивать. Через программу проще. cFosSpeed, к примеру, может делать это автоматически — с помощью пункта меню «Калибровка линии».

Вывод

Программы приоритизации трафика неспособны совершить чудо и превратить канал шириной в 10 Мб/с в 20 Мб/с. На хорошо настроенной системе при использовании одного соединения эффекта от таких программ не будет.

Но при использовании нескольких соединений, полностью загружающих канал, программы приоритизации трафика способны обеспечить максимальную скорость выбранным приложениям.

Для управления информационными пакетами, передаваемыми по сети, разработана технология Quality of Service. Расскажем о ней подробнее.

Что такое QoS

Quality of Service (с англ. «качество обслуживания») — это набор технологий, которые запускают высокоприоритетные приложения и трафик при лимитированной пропускной способности. Это означает, что более важный трафик будет обработан быстрее, а задержки по сети будут минимальны.

Измерения, касающиеся QoS, включают:

- Пропускную способность;

- Задержку;

- Дрожание (отклонение в задержке);

- Частоту ошибок.

Благодаря технологии QoS можно научить маршрутизатор разделять пропускную способность и тогда ни потоковое видео, ни звонок в Skype не будут заикаться.

Как работает

Механизмы QoS для упорядочивания пакетов и выделения полосы пропускания:

- управление очередями;

- управление полосой пропускания.

Необходимо разделить трафик с помощью инструментов классификации. Так организации смогут контролировать доступность ресурсов для приоритетных приложений. Трафик может быть классифицирован по порту, IP-адресу или с использованием более сложного подхода, такого как приложение или пользователь.

Затем для инструментов управления очередями и управления полосой пропускания назначают правила для обработки потоков трафика, характерных для классификации, которую они получили при входе в сеть.

Механизм организации очереди предназначен для хранения пакетов в потоках трафика до тех пор, пока сеть не будет готова их обработать. Это гарантирует, что наиболее важные приложения не будут лишены пропускной способности в сети из-за приложений с меньшим приоритетом.

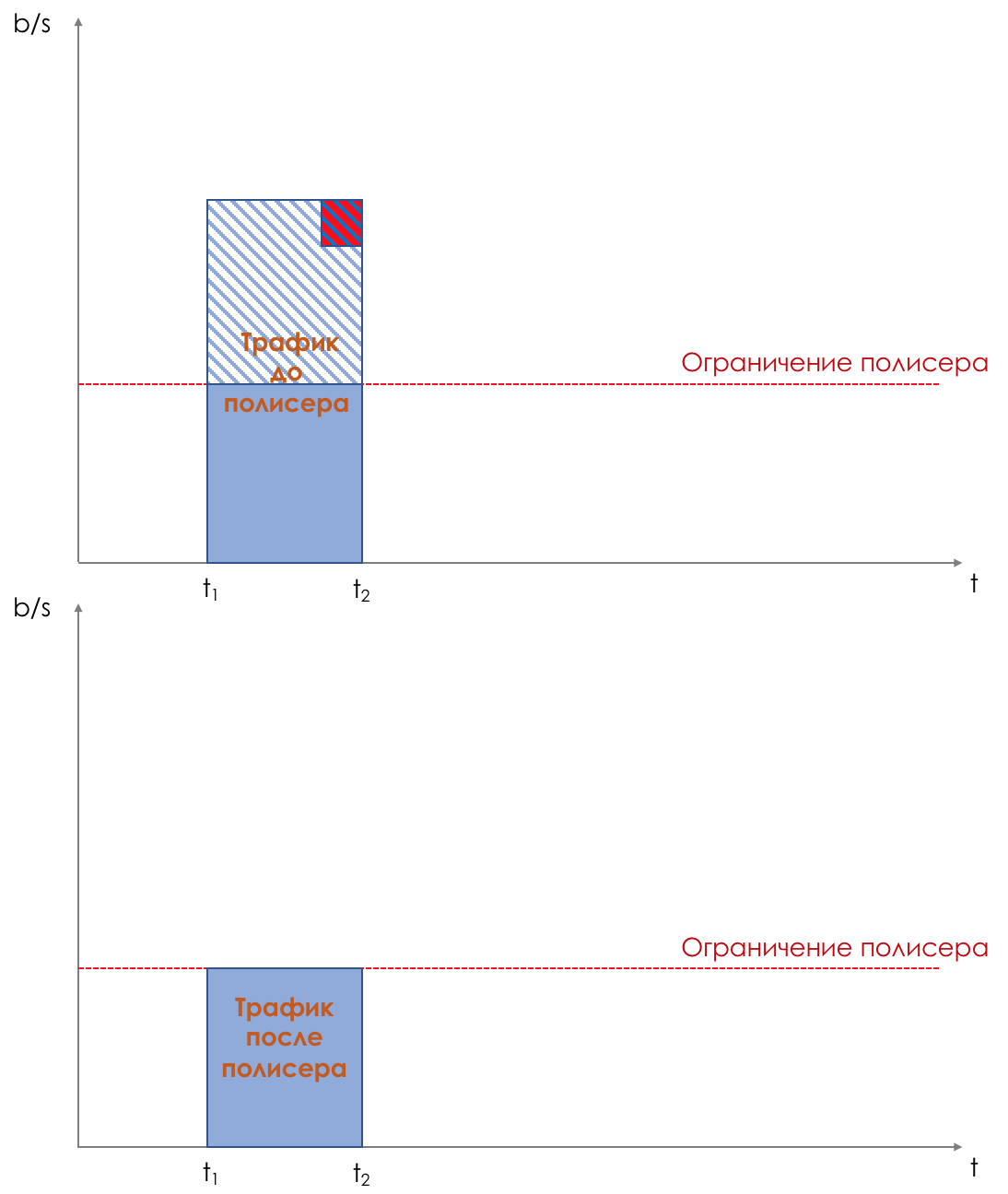

Механизм управления пропускной способностью измеряет и контролирует потоки трафика, чтобы избежать перегруженности сети. Этот механизм включает в себя:

- формирование трафика;

- ограничение скорости;

- увеличение полезной полосы пропускания;

- алгоритм планирования;

- другие методы для обеспечения пропускной способности.

В зависимости от поставщика QoS перечисленными средствами можно управлять и объединять в блоки.

Когда используется

Каждый день корпоративные сети перегружаются натиском трафика. Часть этого трафика имеет решающее значение для успеха бизнес-операций. Особенно это может быть важно для IP-телефонии. Поэтому, когда возникает переполнение очереди на сетевых устройствах, QoS необходим, чтобы увеличить скорость обработки данных и убрать переполнение буфера памяти на сетевых устройствах.

Большинство организаций используют протокол передачи файлов (FTP) и приложения для видеоконференций, такие как Zoom или GoToMeeting. Хотя оба показателя важны для производительности сотрудников, пакеты FTP не так чувствительны к задержкам, как пакеты передачи голоса по Интернет-протоколу (VoIP). В случае задержки FTP-пакеты все равно будут доставлены без изменений. Но задержанный VoIP-пакет приведет к разобщенным видеозвонкам и сорванным деловым встречам.

Сервисные модели

Существуют три модели для реализации QoS:

- Best-Effort (Негарантированная доставка);

- IntServ (Интегрированное обслуживание);

- DiffServ (Дифференцированные услуги).

Best-Effort — это модель сервиса по умолчанию, которая применяется к различным сетевым приложениям, таким как протокол передачи файлов (FTP) и электронная почта. Приложение может отправлять любое количество пакетов в любое время без уведомления сети. Затем сеть пытается передать пакеты. Модель Best-Effort подходит для услуг, которые предъявляют минимальные требования к задержке и скорости потери пакетов.

В модели IntServ приложение использует протокол сигнализации для уведомления сети о параметрах трафика и применения уровня QoS перед отправкой пакетов. Сеть резервирует ресурсы для приложения на основе параметров трафика. После того, как приложение получает подтверждение о зарезервированных ресурсах, оно начинает отправлять пакеты в пределах указанного диапазона.

DiffServ — часто используемая модель QoS, классифицирует пакеты в сети и выполняет установленные действия для каждого класса. Когда происходит перегрузка сети, пакеты классов обрабатываются на основе приоритетов, что приводит к неодинаковой частоте потери пакетов, неоднородным задержкам и дрожанию. Пакеты одного и того же класса объединяются и отправляются одним блоком.

В отличие от IntServ, модель DiffServ не требует протокола сигнализации. В этой модели приложение не запрашивает сетевые ресурсы перед отправкой пакетов. Вместо этого приложение устанавливает параметры QoS в пакетах, через которые сеть может узнать требования QoS приложения. Сеть предоставляет дифференцированные услуги на основе параметров QoS каждого потока данных.

Классификация и маркировка

Классификация и маркировка трафика – основа дифференцированных услуг.

Критерии для классификации данных:

- IP-адрес источника или назначения;

- входящий интерфейс;

- значение класса CoS в заголовке;

- значение типа услуги ToS в заголовке IP (приоритет IP или DSCP);

- значение MPLS EXP в заголовке MPLS.

На этапе классификации маршрутизатор распознает трафик, который будет сопоставлен с каждым из классов.

После классификации маршрутизатор выполняет маркировку пакетов: связывает пакет с оригинальным параметром. Этот параметр используется в последующих маршрутизаторах для идентификации трафика. Маркировка может быть сделана:

- на уровне 2 в заголовке Ethernet;

- на уровне 2.5 в заголовке MPLS;

- на уровне 3 в заголовке IP;

- в верхних слоях.

Благодаря этим изменениям трафик быстро распознается в любой точке сети.

Параметры, которые могут быть установлены или изменены:

- значение CoS исходящего пакета;

- значение DSCP в байте типа ToS;

- значение поля MPLS EXP в верхней метке на интерфейсе ввода или вывода;

- экспериментальное поле EXP многопротокольной коммутации по MPLS на введенных записях меток;

- значение приоритета в заголовке пакета;

- идентификатор группы QoS (ID);

- биты ToS в заголовке IP-пакета.

Например, чтобы разместить голосовой и информационный трафик в отдельных очередях, используют классификацию. Метод маркировки помогает QoS изменять биты в заголовке пакета и указывать приоритет, понятный для других инструментов. Инструменты маркировки для голосовых пакетов используют для гарантии, что программа распознает их в сетевом потоке.

Настройка сервиса на роутере

Перед настройкой сервиса на роутере заходят на портал изготовителя, чтобы узнать, какие функции QoS поддерживаются и как получить к ним доступ.

Каждая платформа будет запрашивать скорость загрузки и выгрузки. Не стоит полагаться на заявленную провайдером скорость. Узнать доступную полосу пропускания для загрузки и выгрузки можно на speedtest.net. Полученные результаты преобразуют из Мбита в Кбит.

Алгоритм включения QoS на роутере:

- Открыть панель администрирования.

- В адресную строку браузера ввести IP-адрес маршрутизатора.

- Войти под персональным именем и паролем (указано в руководстве к маршрутизатору).

- После входа выбрать вкладку «NAT», затем «QoS».

- Нажать «Включить», оставив порт установленным на WAN, а Packet Scheduler и Queueing Discipline в состоянии по умолчанию.

- Заполнить значения восходящую и нисходящую линии связи (вводные данные составляют 80-95% значения, полученного в ходе теста скорости).

Платформа продуктивно работает, если может искусственно создать узкое место для перенаправления трафика. Если пользователь выставляет значения, равные или превышающие скорость соединения, тогда программе не остается пространства для маневра.

QoS в IP-телефонии

Настройка QoS в IP-телефонии важна для бизнеса, ведь качество связи влияет на количество звонков и, соответственно, конверсию.

Чтобы не допустить помехи связи и задержки звука, можно настроить приоритезацию для данных IP-телефонии. Перед настройкой обратите внимание на характеристики роутера и максимальный размер очереди обработки пакетов. Если канал узкий, то буфер устройства будет переполняться, а новые пакеты удаляться и приоритизация трафика в таком случае бесполезна. Необходимо проложить дополнительные маршруты.

Настроить приоритезацию в IP-телефонии можно двумя способами:

- В веб-интерфейсе роутера:

- По протоколу SIP/RTP (используется для передачи звука).

- По портам

- По типу трафика

- В приложении для звонков:

Необходимо открыть сетевые настройки (Ethernet, IP, ATM, MPLS и др.) и промаркировать трафик. Так роутер поймет, какие данные пропускать быстрее.

Единственный минус — не все роутеры понимают приоритет по заголовку, настройка будет зависеть от устройства и сервиса.

Заключение

Технология QoS помогает поддерживать производительность сети, гарантировать бесперебойную передачу трафика, а также регулярно оценивать состояние IT-инфраструктуры компании. QoS в IP-телефонии влияет на количество и качество звонков, а значит на конверсию.

СДСМ-15. Про QoS. Теперь с возможностью Pull Request’ов.

И вот мы дошли до темы QoS.

Знаете почему только сейчас и почему это будет закрывающая статья всего курса СДСМ? Потому что QoS необычайно сложен. Сложнее всего, что было прежде в цикле.

Это не какой-то магический архиватор, который ловко сожмёт трафик на лету и пропихнёт ваш гигабит в стомегабитный аплинк. QoS это про то как пожертвовать чем-то ненужным, впихивая невпихуемое в рамки дозволенного.

QoS настолько опутан аурой шаманизма и недоступности, что все молодые (и не только) инженеры стараются тщательно игнорировать его существование, считая, что достаточно закидать проблемы деньгами, и бесконечно расширяя линки. Правда пока они не осознают, что при таком подходе их неизбежно ждёт провал. Или бизнес начнёт задавать неудобные вопросы, или возникнет масса проблем, почти не связанных с шириной канала, зато прямо зависящих от эффективности его использования. Ага, VoIP активно машет ручкой из-за кулис, а мультикастовый трафик ехидно поглаживает вас по спинке.

Поэтому давайте просто осознаем, что QoS это обязательно, познать его придётся так или иначе, и почему-бы не начать сейчас, в спокойной обстановке.

Содержание

1. Чем определяется QoS?

- Потери

- Задержки

- Джиттер

2. Три модели обеспечения QoS

- Best Effort

- Integrated Services

- Differentiated Services

3. Механизмы DiffServ

4. Классификация и маркировка

- Behavior Aggregate

- Multi-Field

- Interface-Based

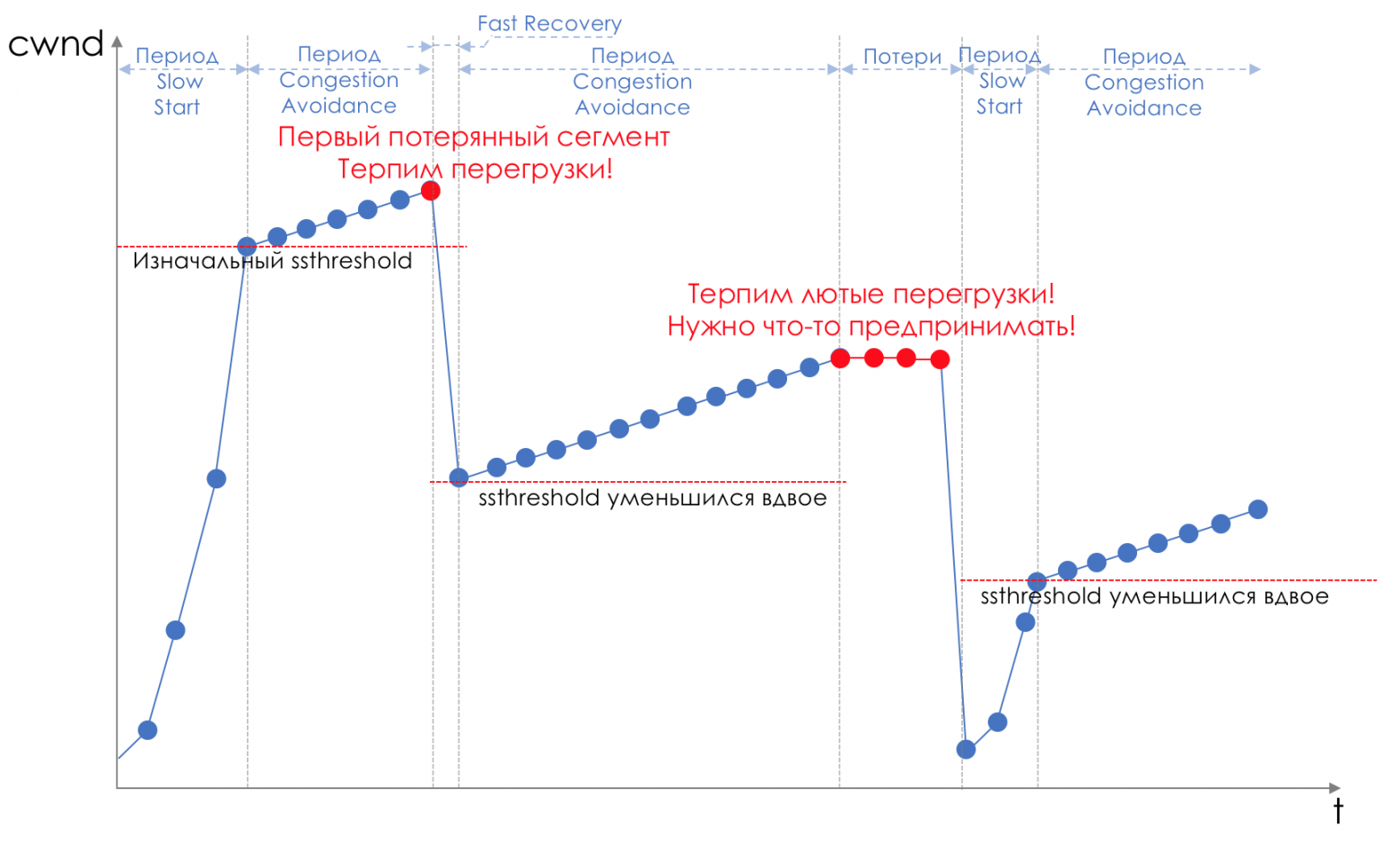

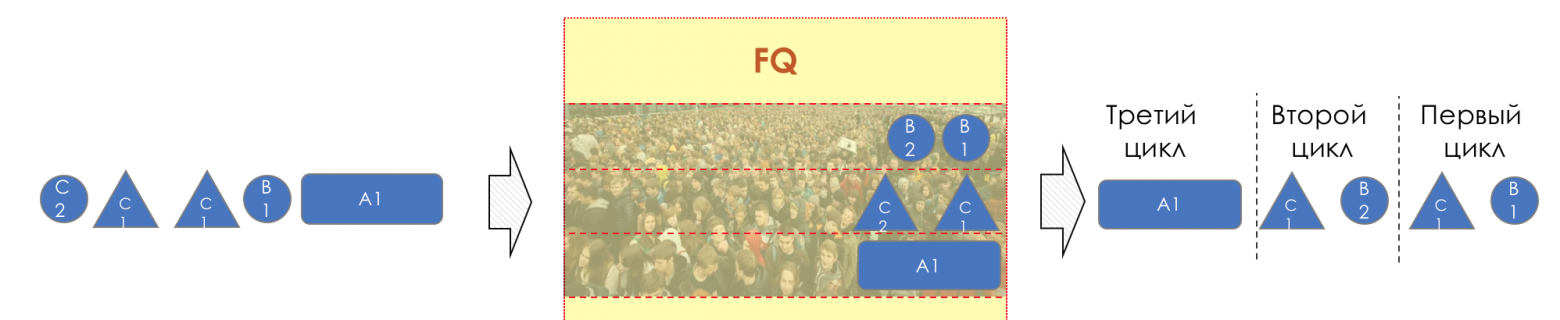

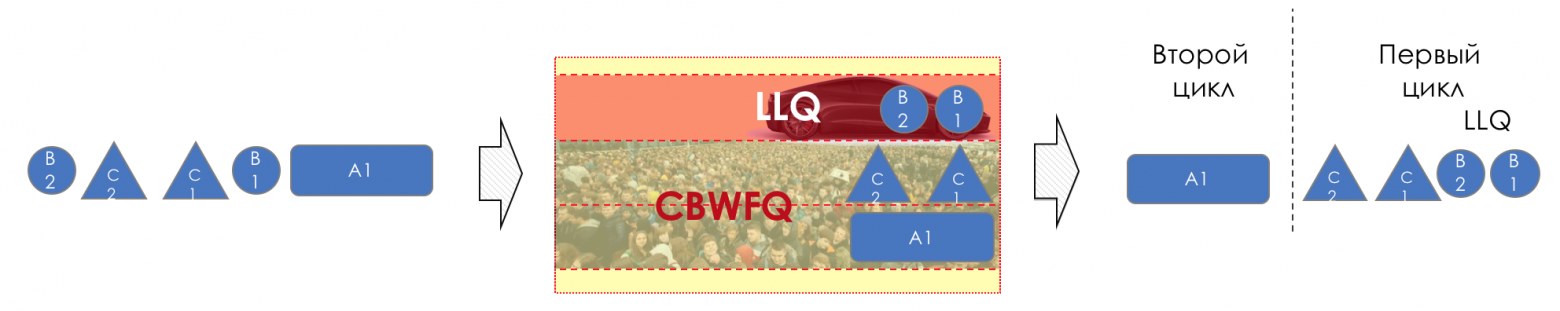

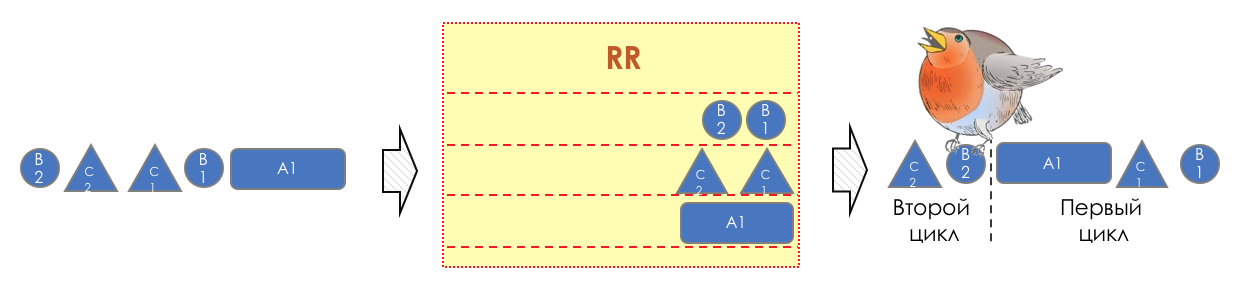

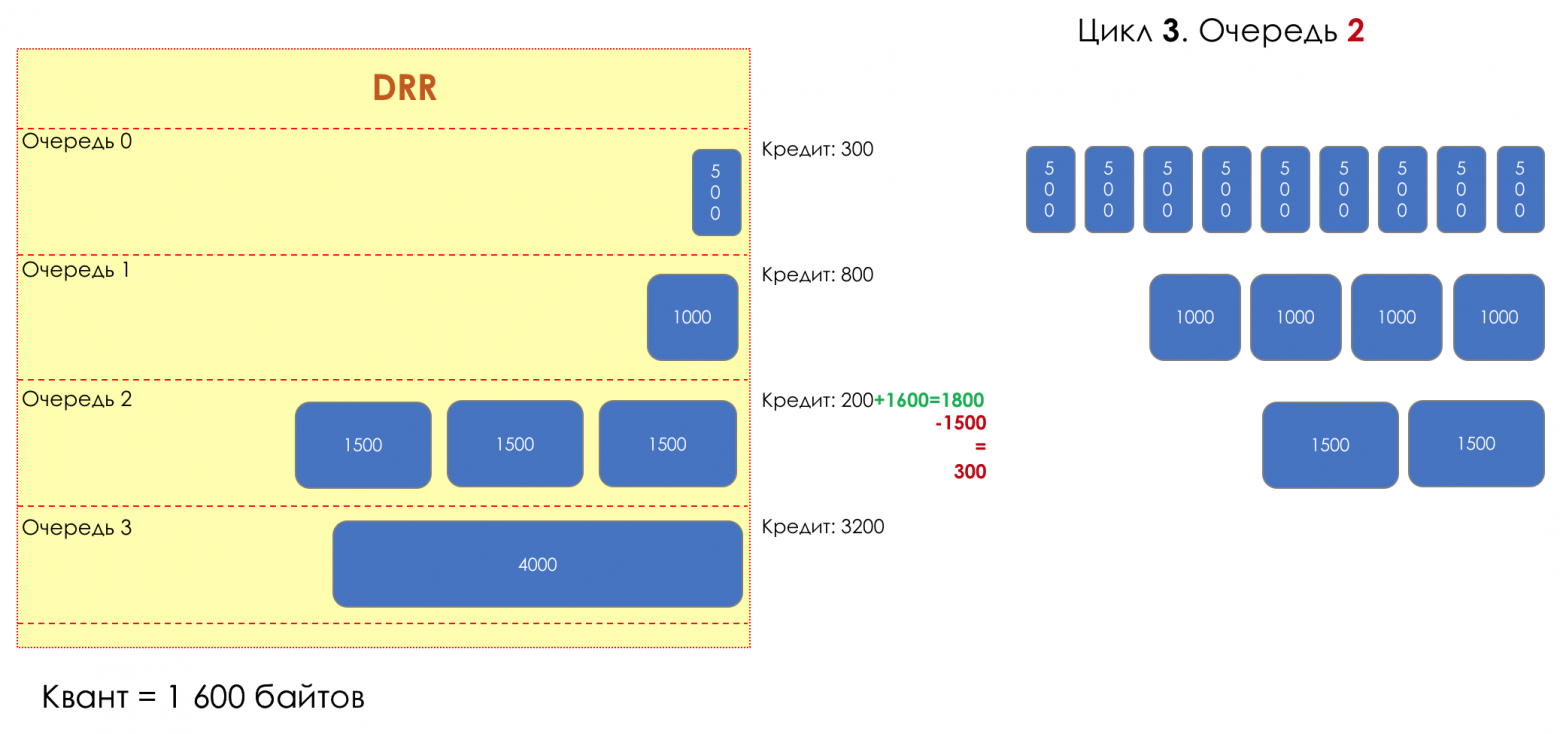

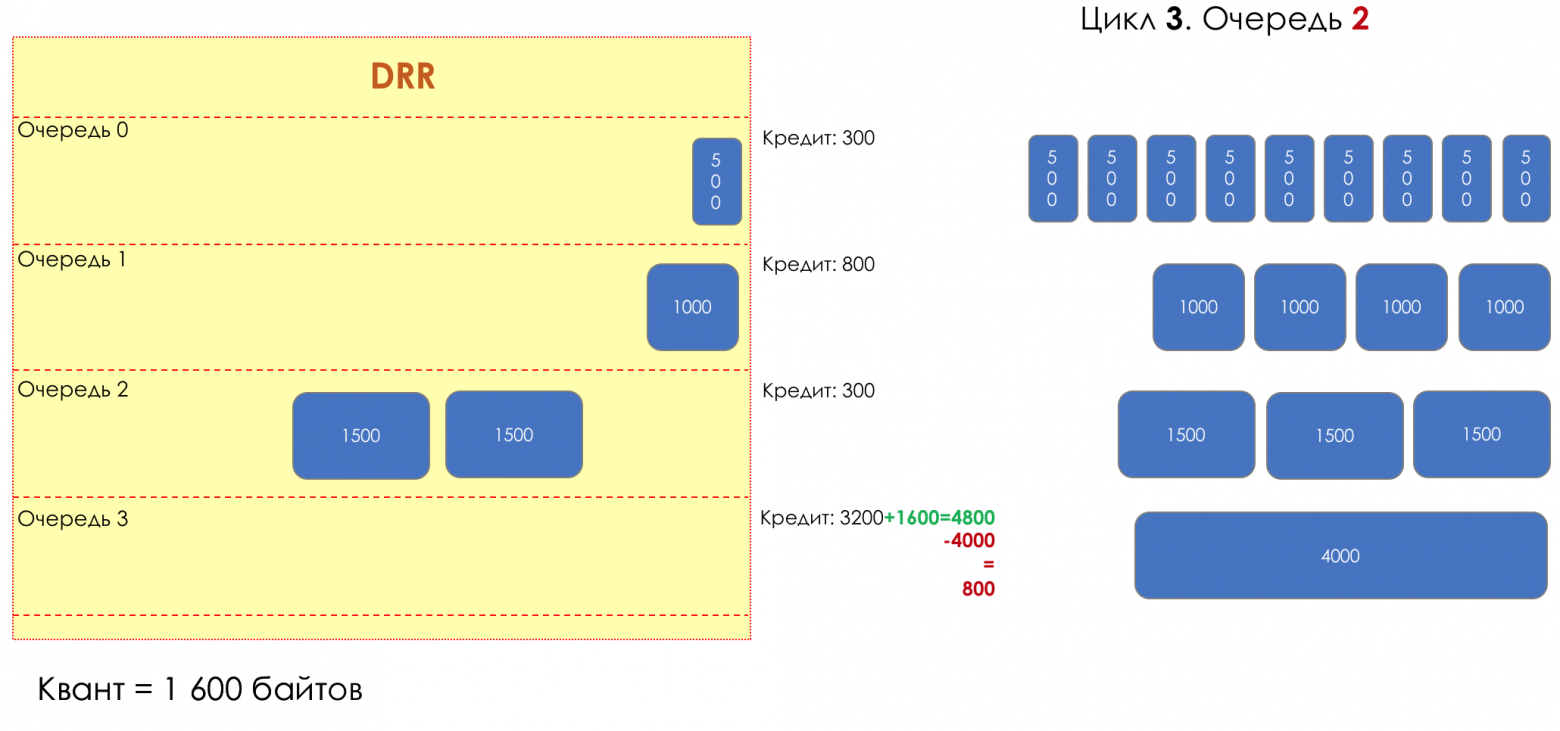

5. Очереди

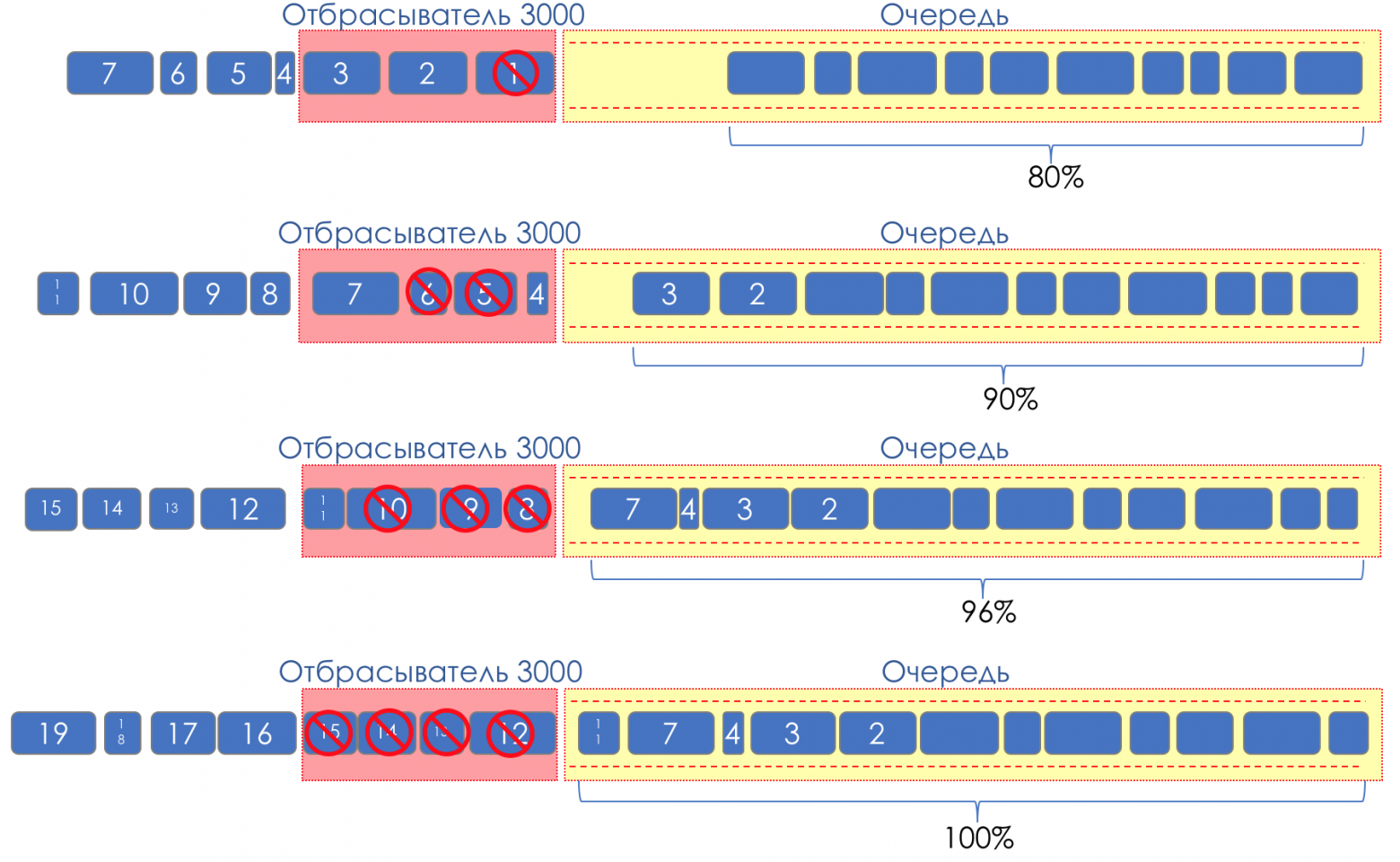

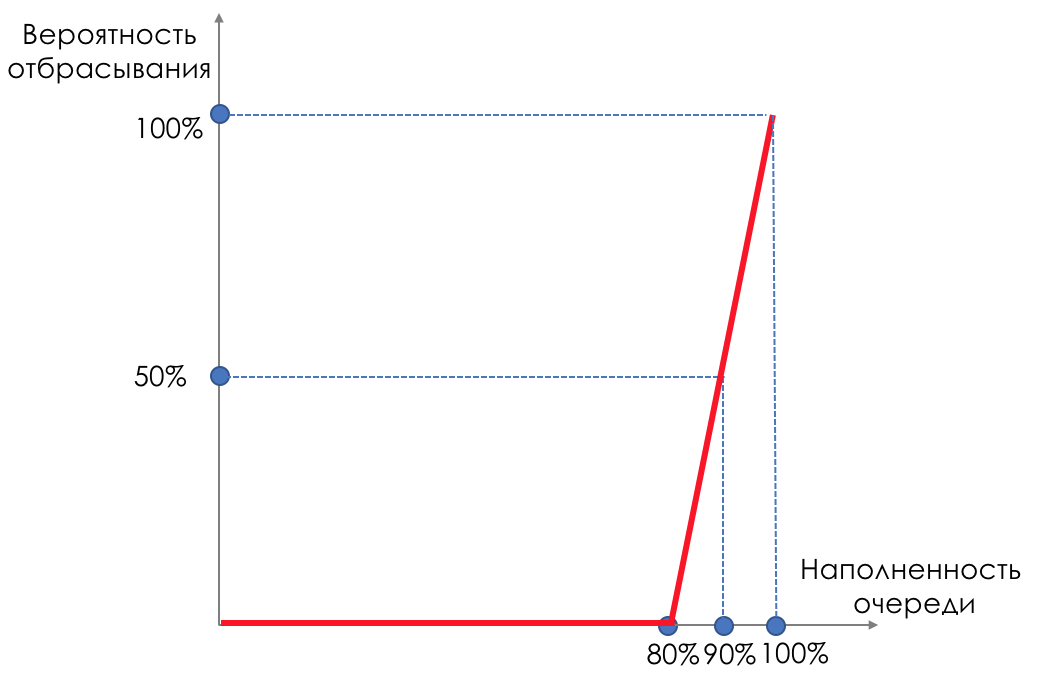

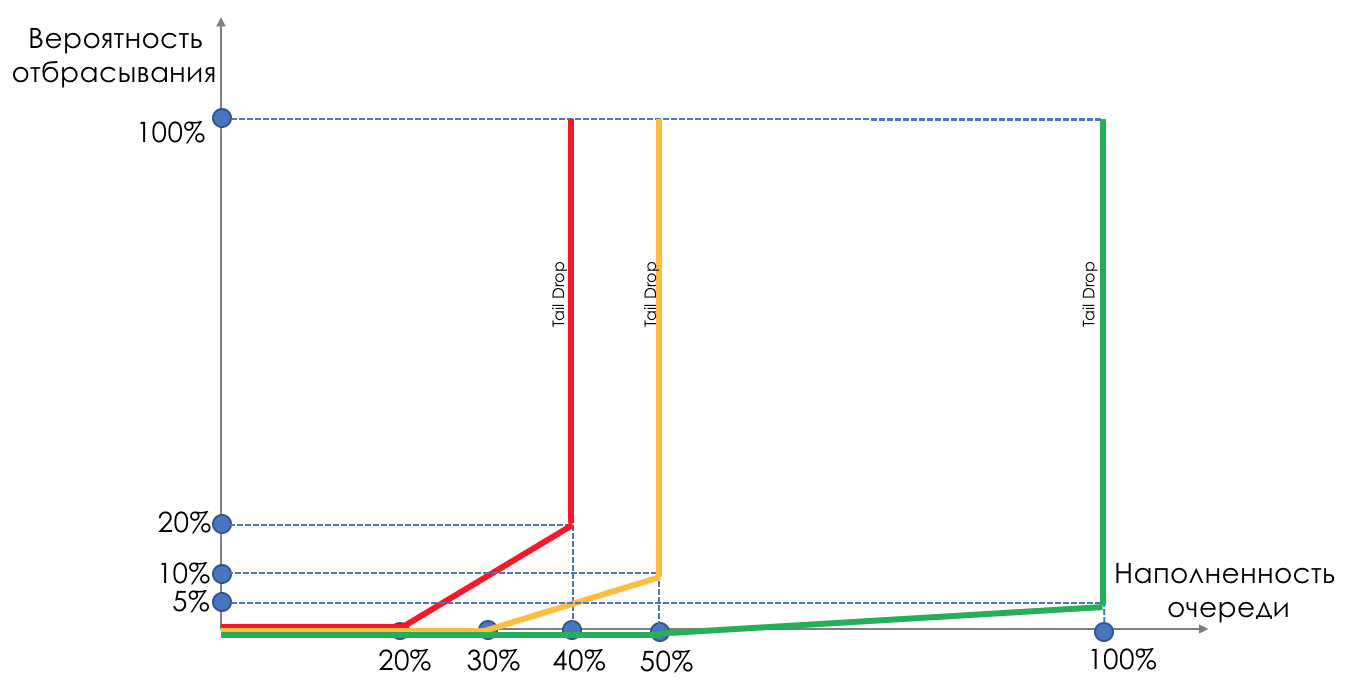

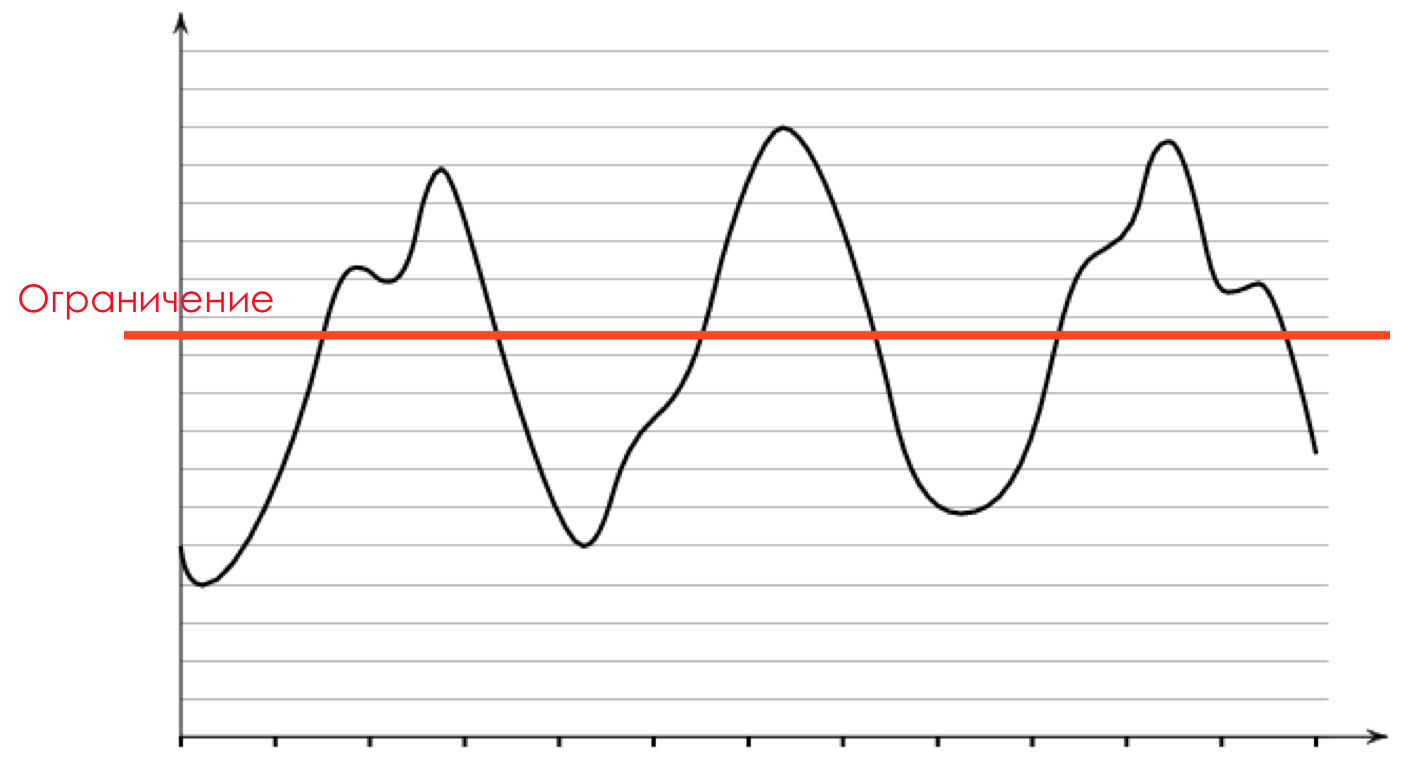

6. Предотвращение перегрузок (Congestion Avoidance)

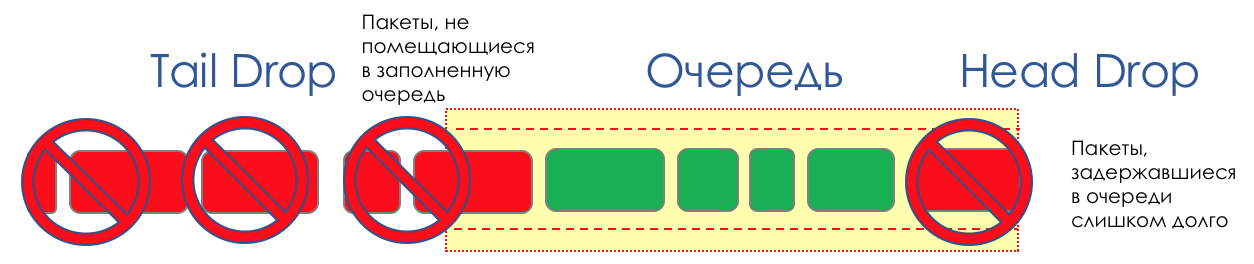

- Tail Drop и Head Drop

- RED

- WRED

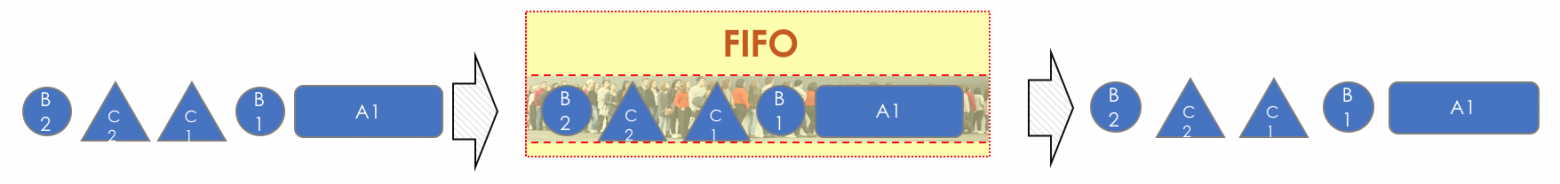

7. Управление перегрузками (Congestion Management)

- First In, First Out

- Priority Queuing

- Fair Queuing

- Round Robin

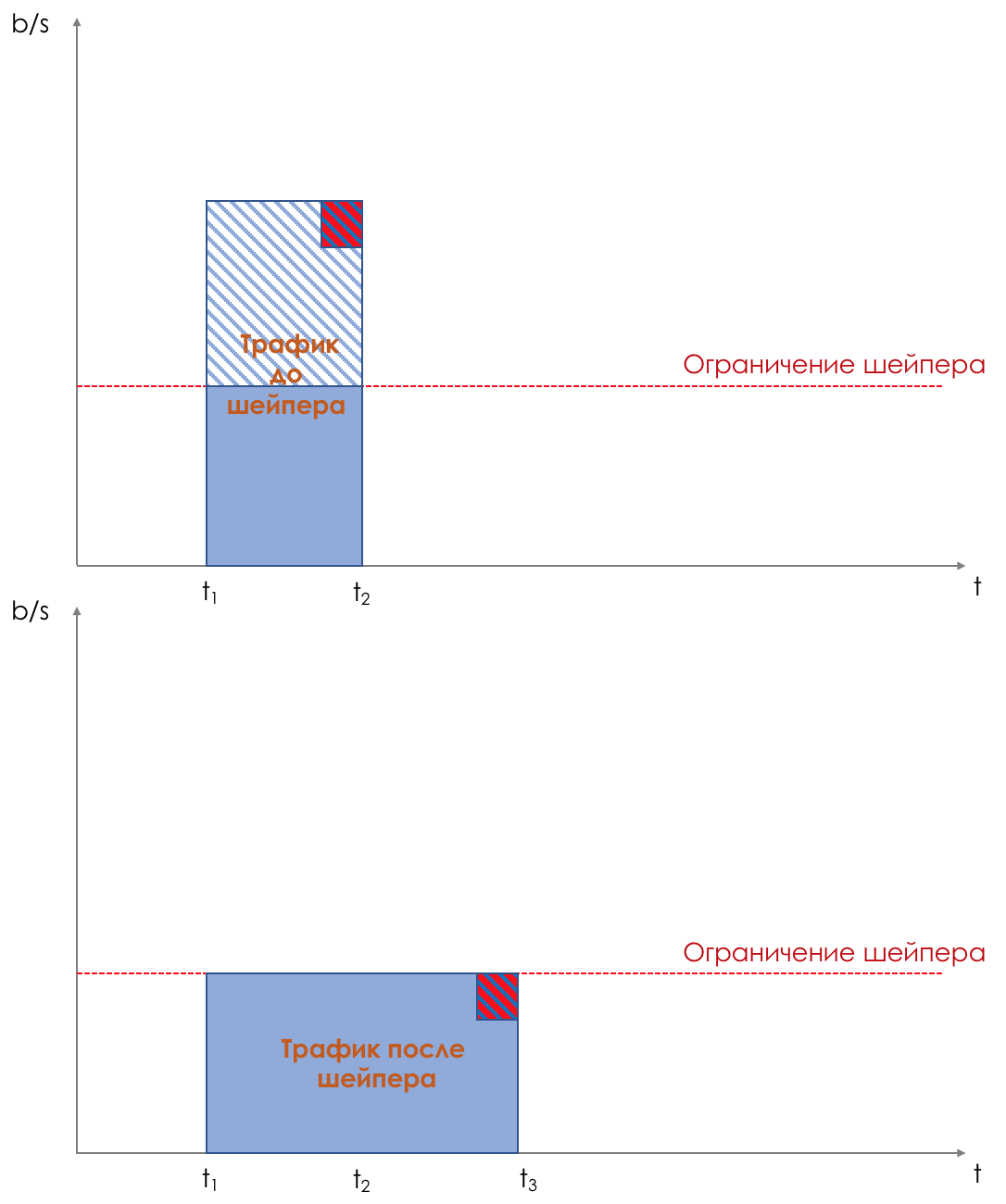

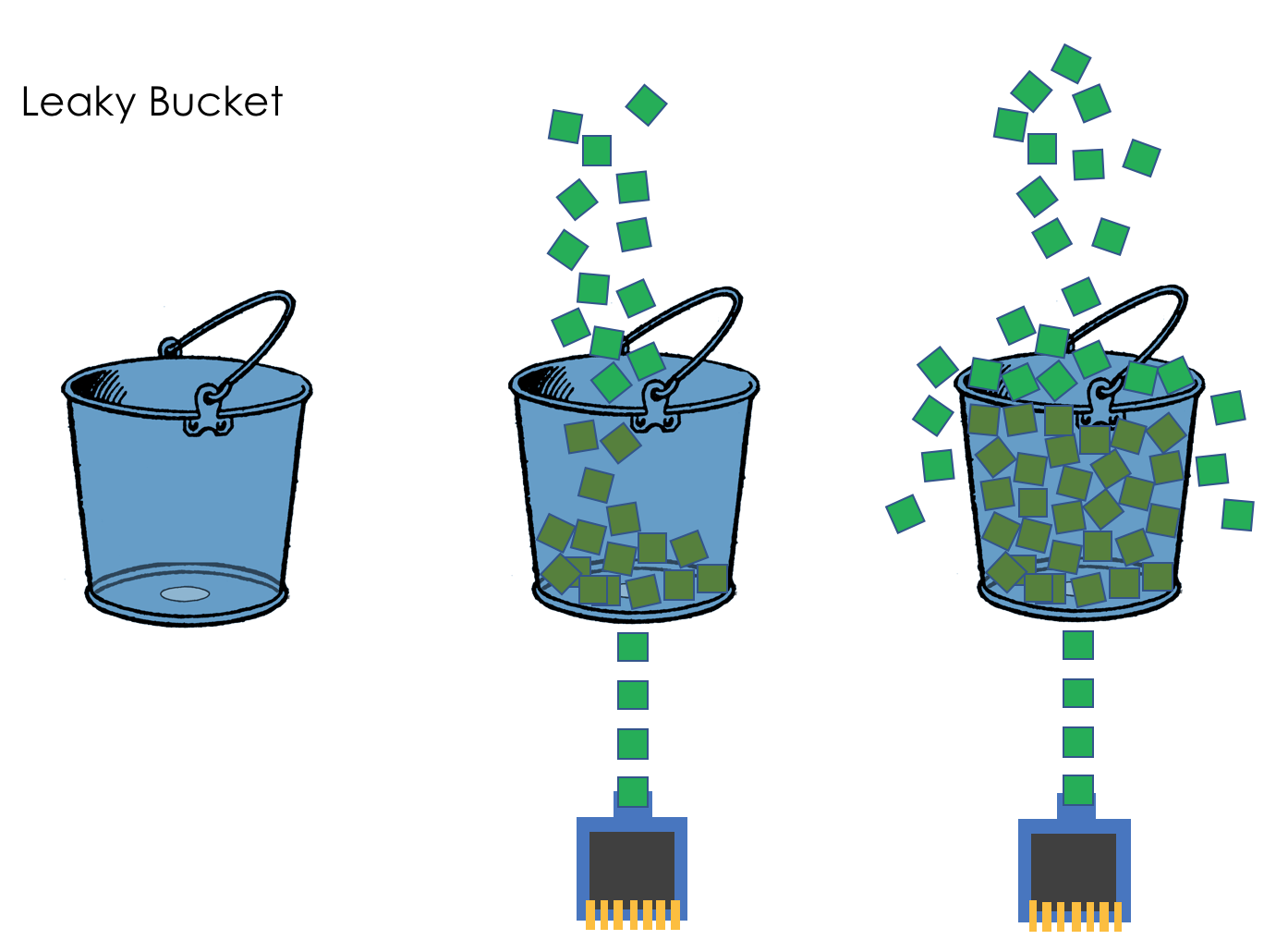

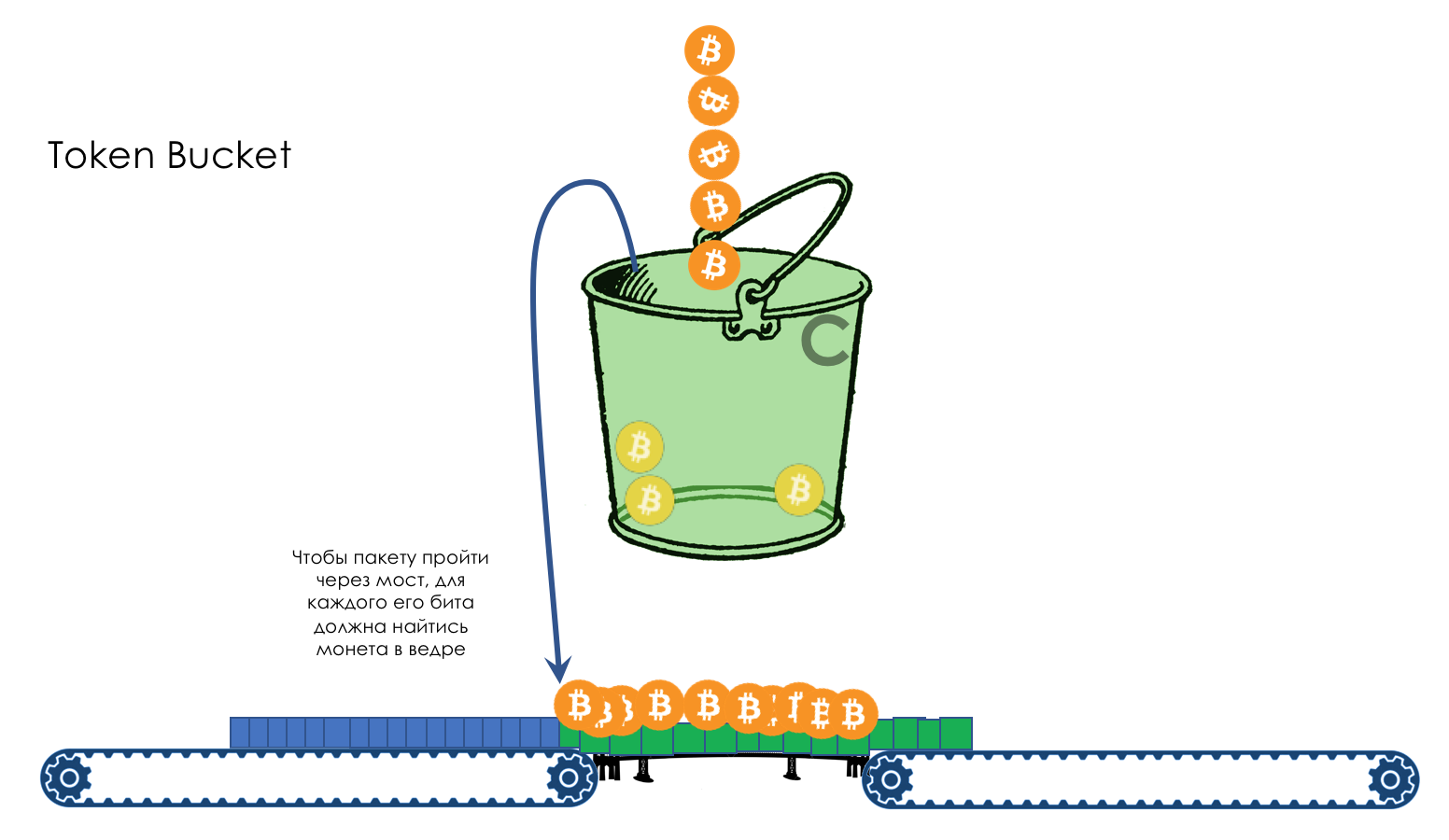

8. Ограничение скорости

- Shaping

- Policing

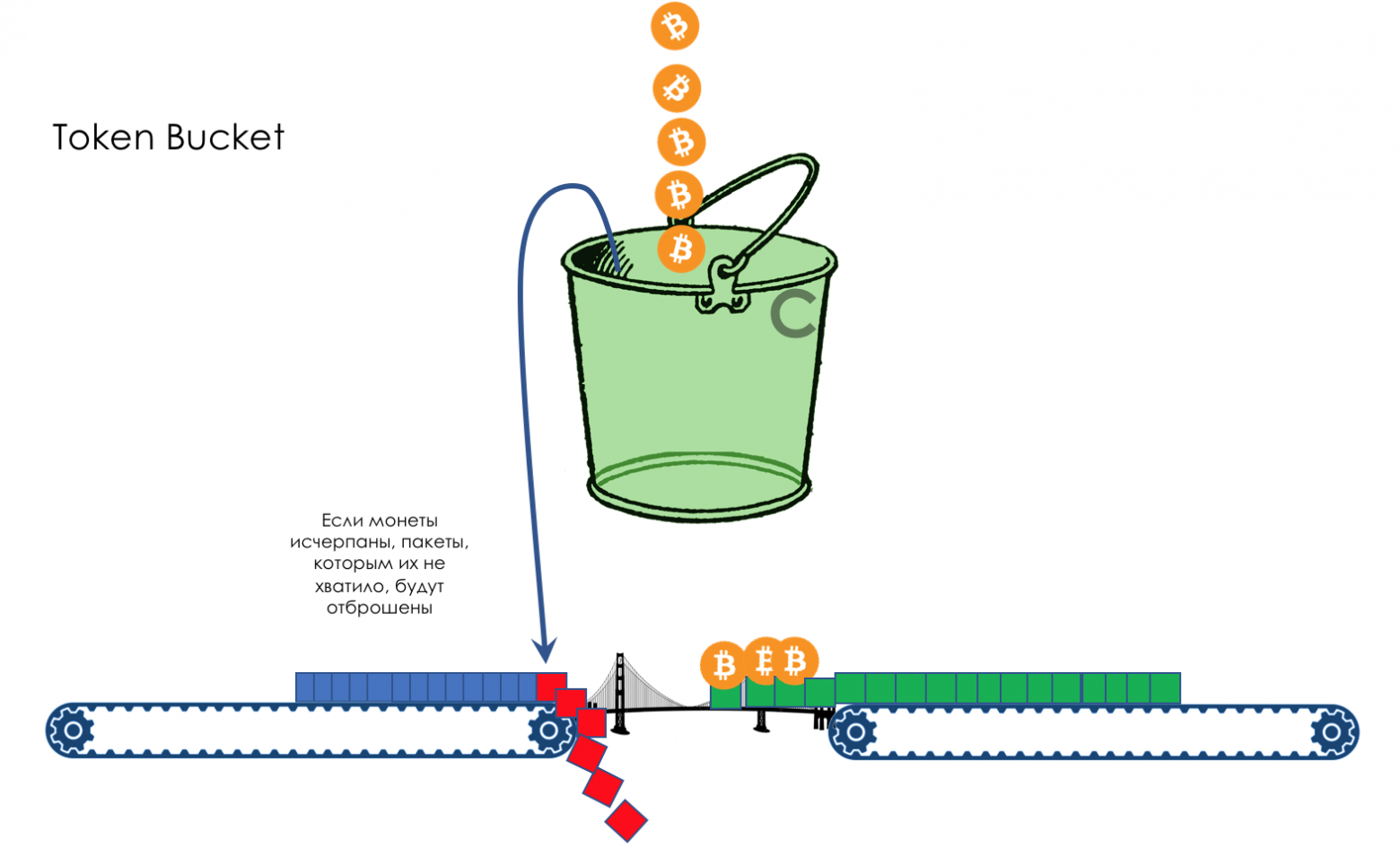

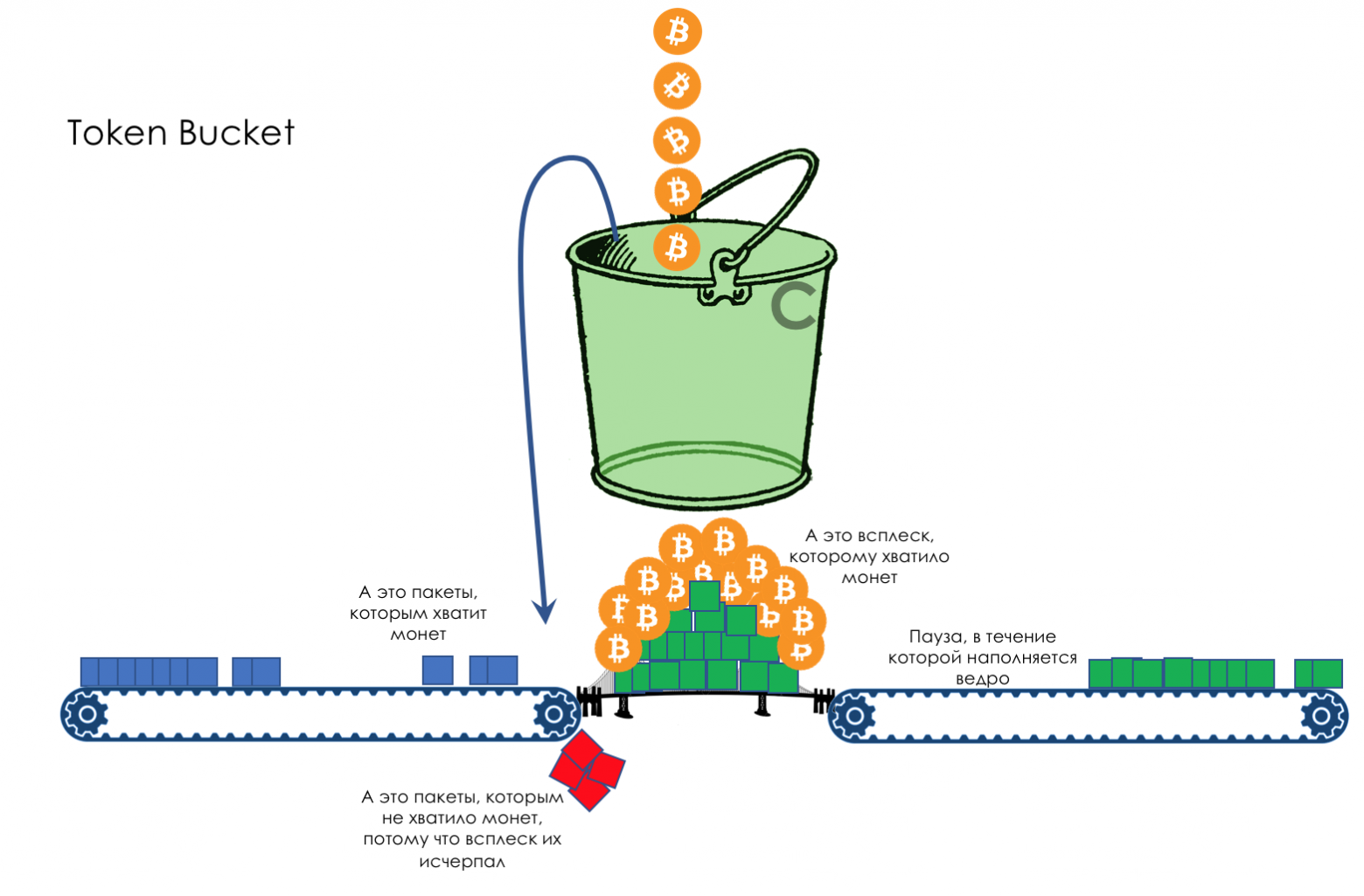

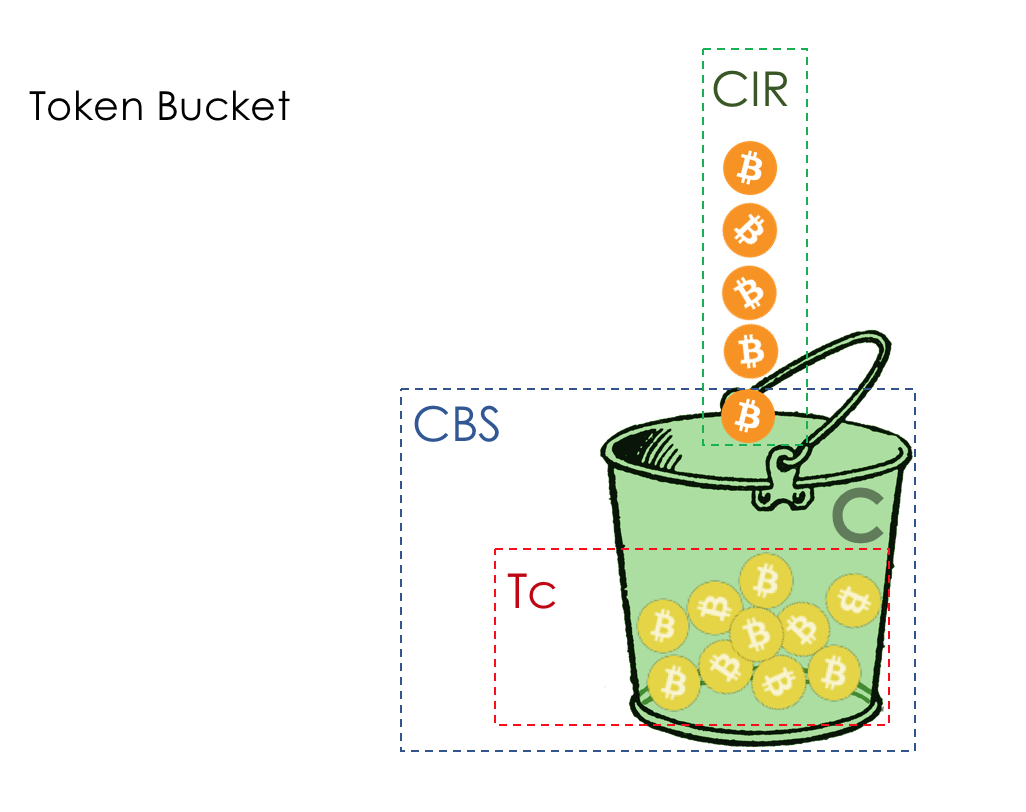

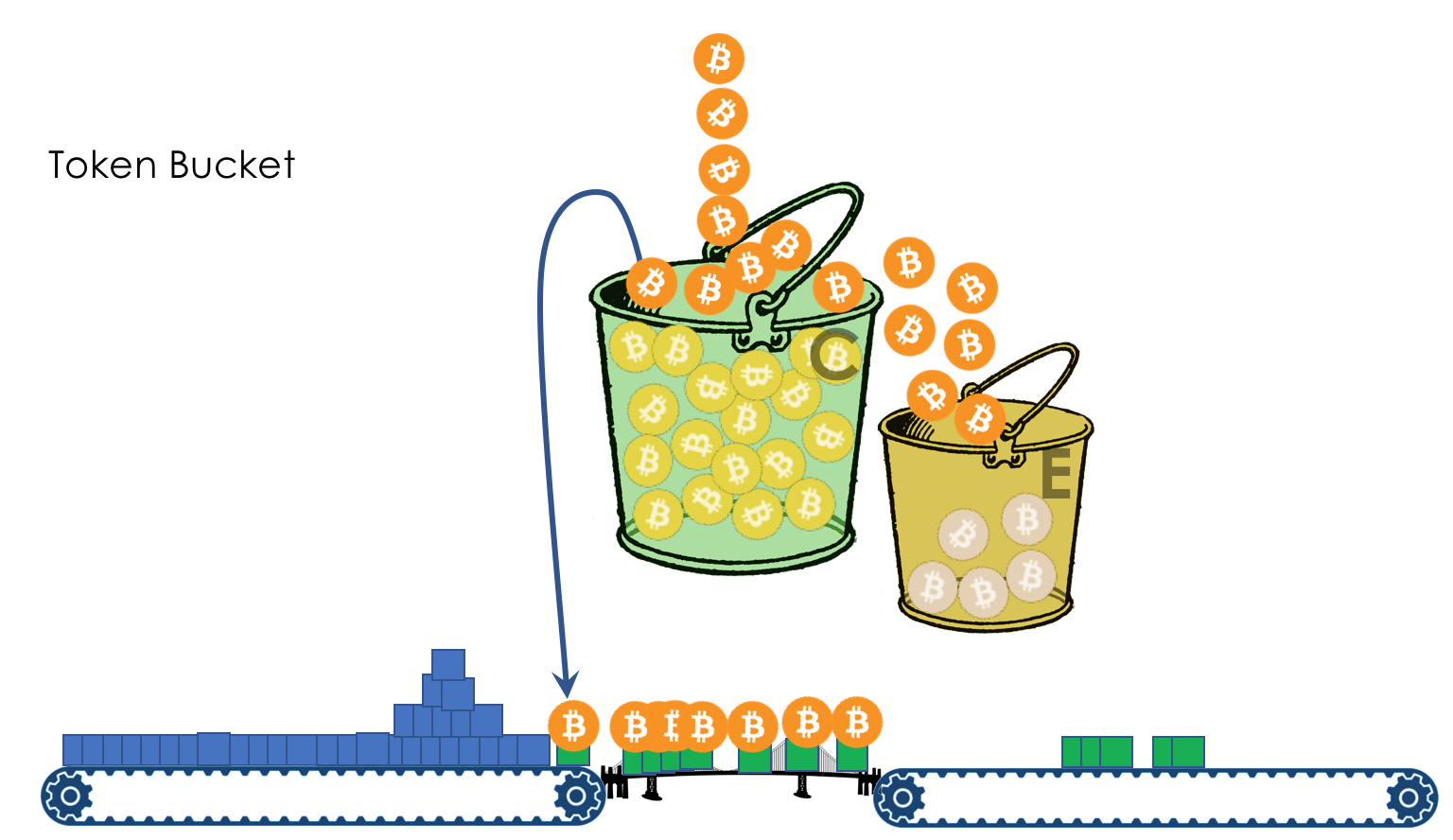

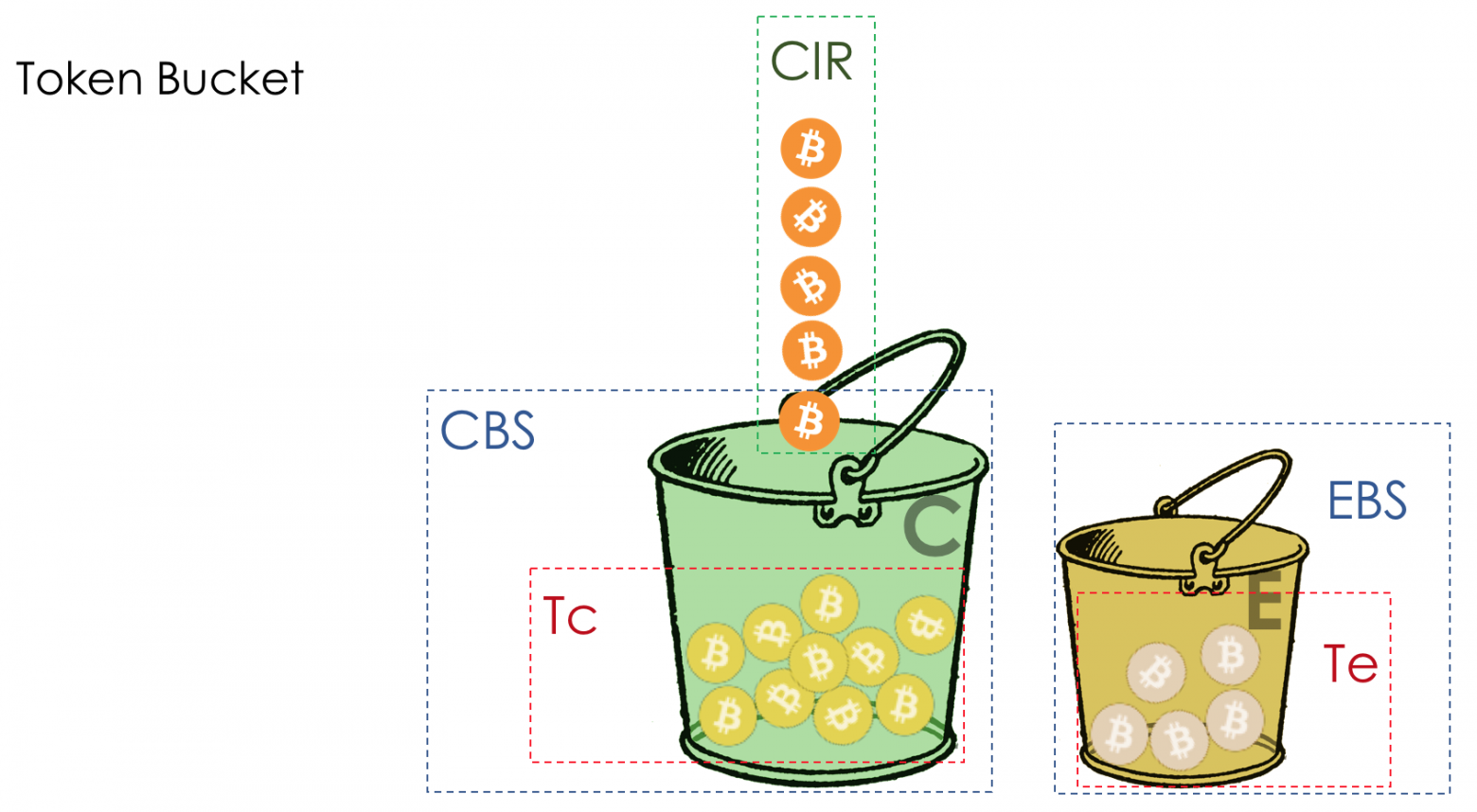

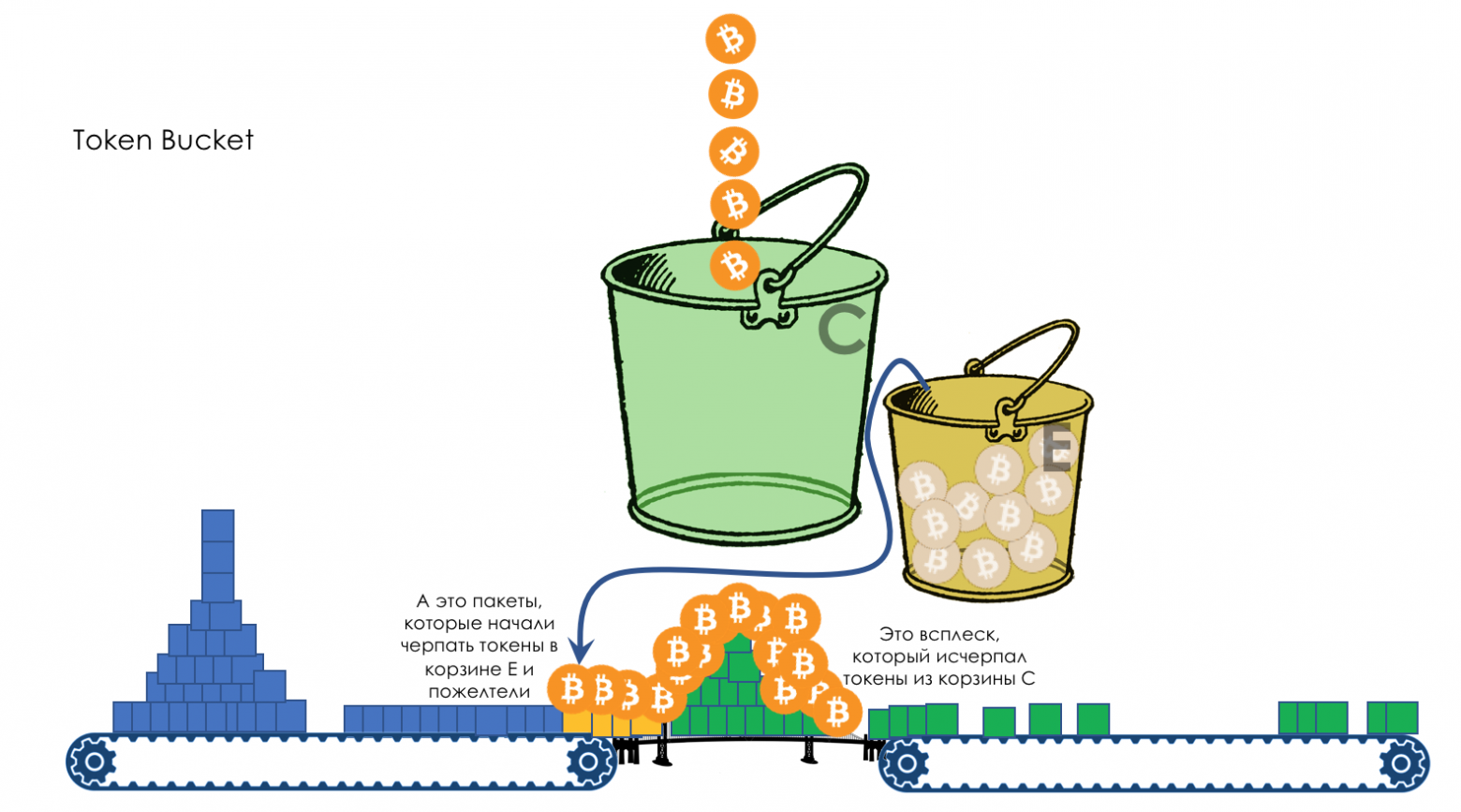

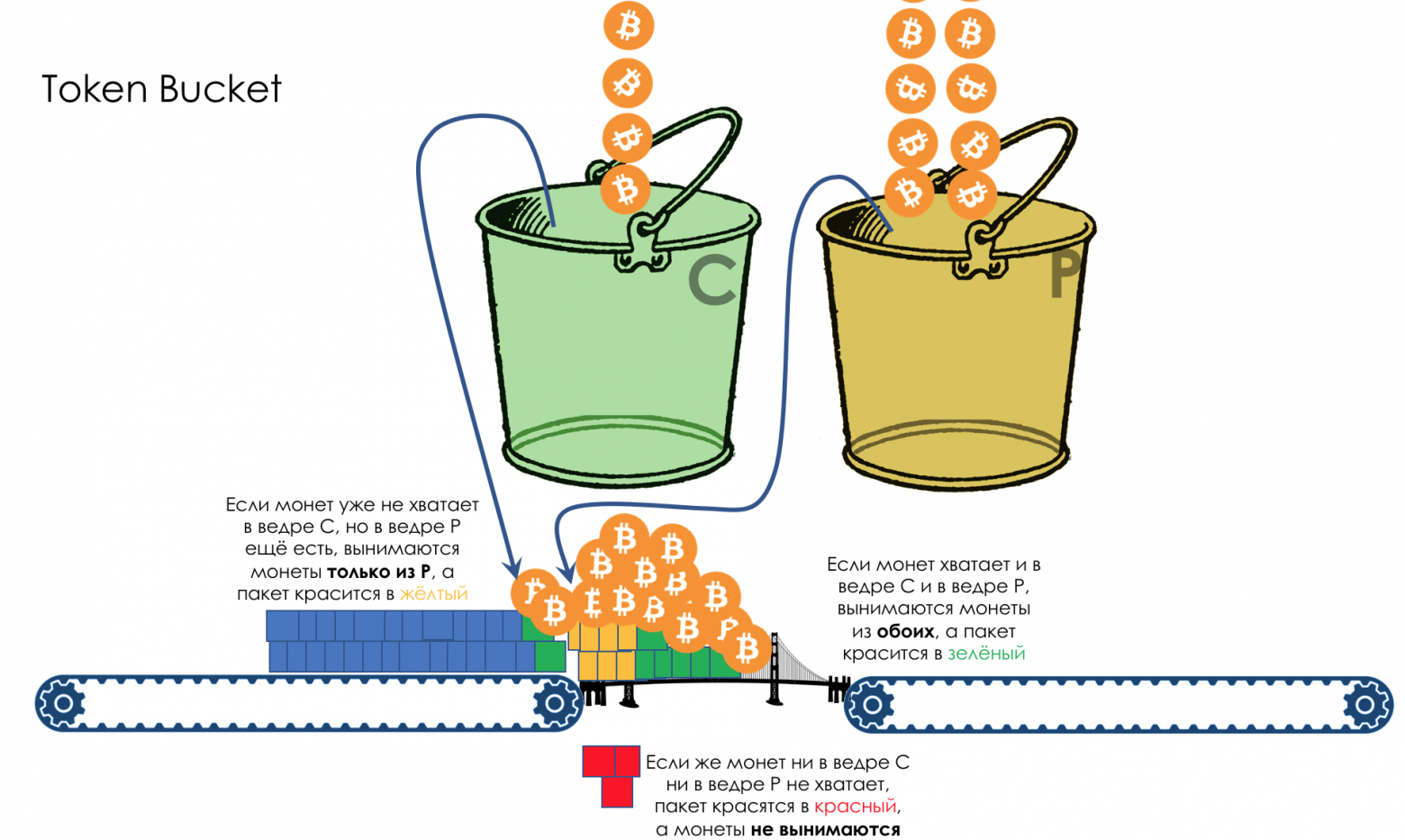

- Механизмы Leaky Bucket и Token Bucket

9. Аппаратная реализация QoS

До того как читатель нырнёт в эту нору, я заложу в него три установки:

- Не все проблемы можно решить расширением полосы.

- QoS не расширяет полосу.

- QoS про управление ограниченными ресурсами.

1. Чем определяется QoS?

Бизнес ожидает от сетевого стека того, что он будет просто хорошо выполнять свою несложную функцию — доставлять битовый поток от одного хоста до другого: без потерь и за предсказуемое время.

Из этого короткого предложения можно вывести все метрики качества сети:

- Потери

- Задержки

- Джиттер

Эти три характеристики определяют качество сети независимо от её природы: пакетная, канальная, IP, MPLS, радио, голуби.

Потери

Эта метрика говорит о том, сколько из отправленных источником пакетов дошло до адресата.

Причиной потерь может быть проблема в интерфейсе/кабеле, перегрузка сети, битовые ошибки, блокирующие правила ACL.

Что делать в случае потерь решает приложение. Оно может проигнорировать их, как в случае с телефонным разговором, где запоздавший пакет уже не нужен, или перезапросить его отправку — так делает TCP, чтобы гарантировать точную доставку исходных данных.

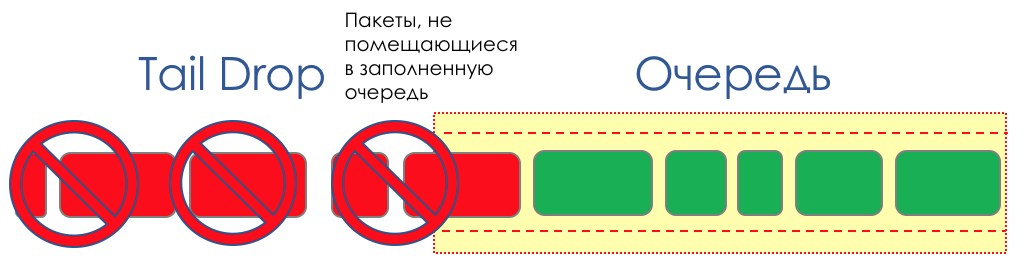

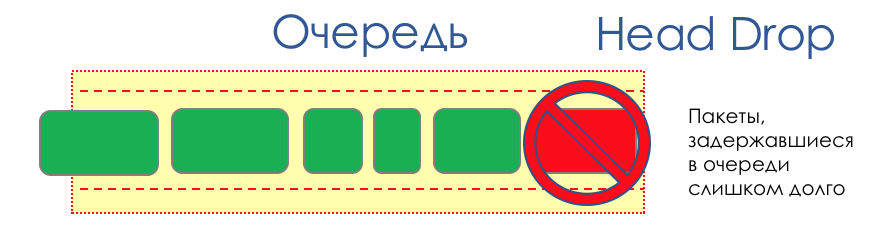

Как управлять потерями, если они неизбежны, в главе Управление перегрузками.

Как использовать потери во благо в главе Предотвращение перегрузок.

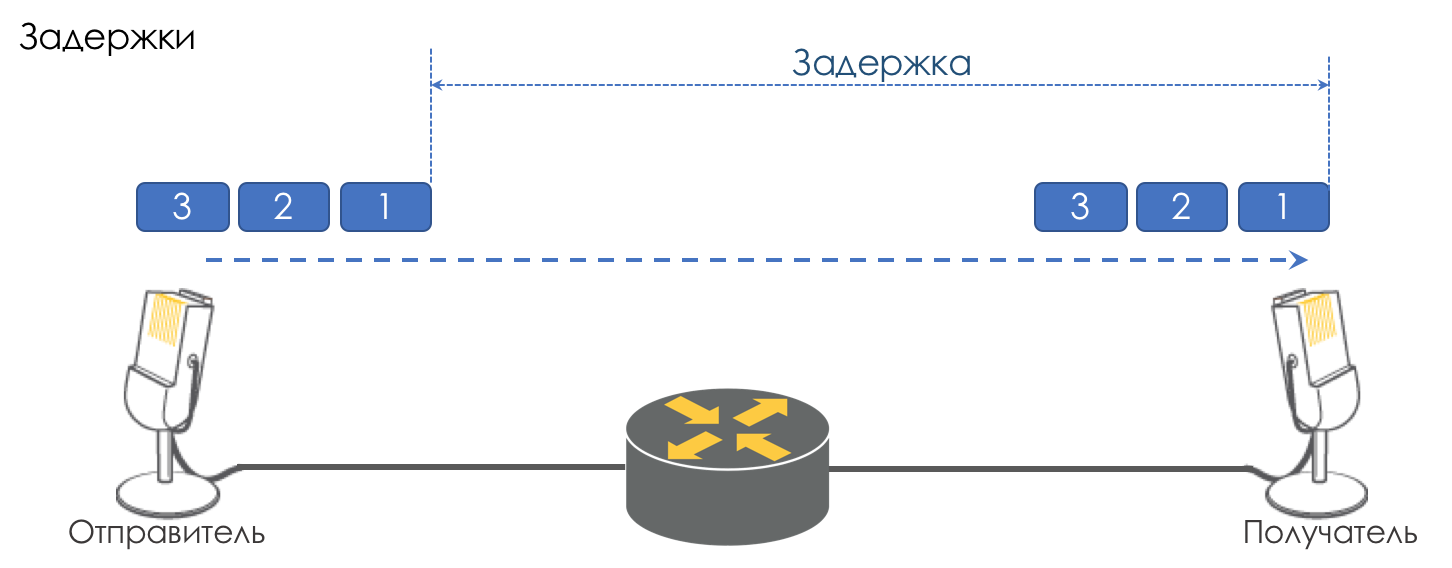

Задержки

Это время, которое необходимо данным, чтобы добраться от источника до получателя.

Совокупная задержка складывается из следующих компонентов.

- Задержка сериализации (Serialization Delay) — время, за которое узел разложит пакет в биты и поместит в линк к следующему узлу. Она определяется скоростью интерфейса. Так, например, передача пакета размером 1500 байтов через интерфейс 100Мб/с займёт 0,0001 с, а на 56 кб/с — 0,2 с.

- Задержка передачи сигнала в среде (Propagation Delay) — результат печально известного ограничения скорости распространения электромагнитных волн. Физика не позволяет добраться из Нью-Йорка до Томска по поверхности планеты быстрее чем за 30 мс (фактически порядка 70 мс).

- Задержки, вносимые QoS — это томление пакетов в очередях (Queuing Delay) и последствия шейпинга (Shaping Delay). Об этом мы сегодня будем говорить много и нудно в главе Управление скоростью.

- Задержка обработки пакетов (Processing Delay) — время на принятие решения, что делать с пакетом: lookup, ACL, NAT, DPI — и доставку его от входного интерфейса до выходного. Но в день, когда Juniper в своём M40 разделил Control и Data Plane, задержкой обработки стало можно пренебречь.

Задержки не так страшны приложениям, где не требуется спешка: обмен файлами, сёрфинг, VoD, интернет-радиостанции итд. И напротив, они критичны для интерактивных: 200мс уже неприятны на слух при телефонном разговоре.

Связанный с задержкой термин, но не являющийся синонимом — RTT (Round Trip Time) — это путь туда-обратно. При пинге и трассировке вы видите именно RTT, а не одностороннюю задержку, хотя величины и имеют корреляцию.

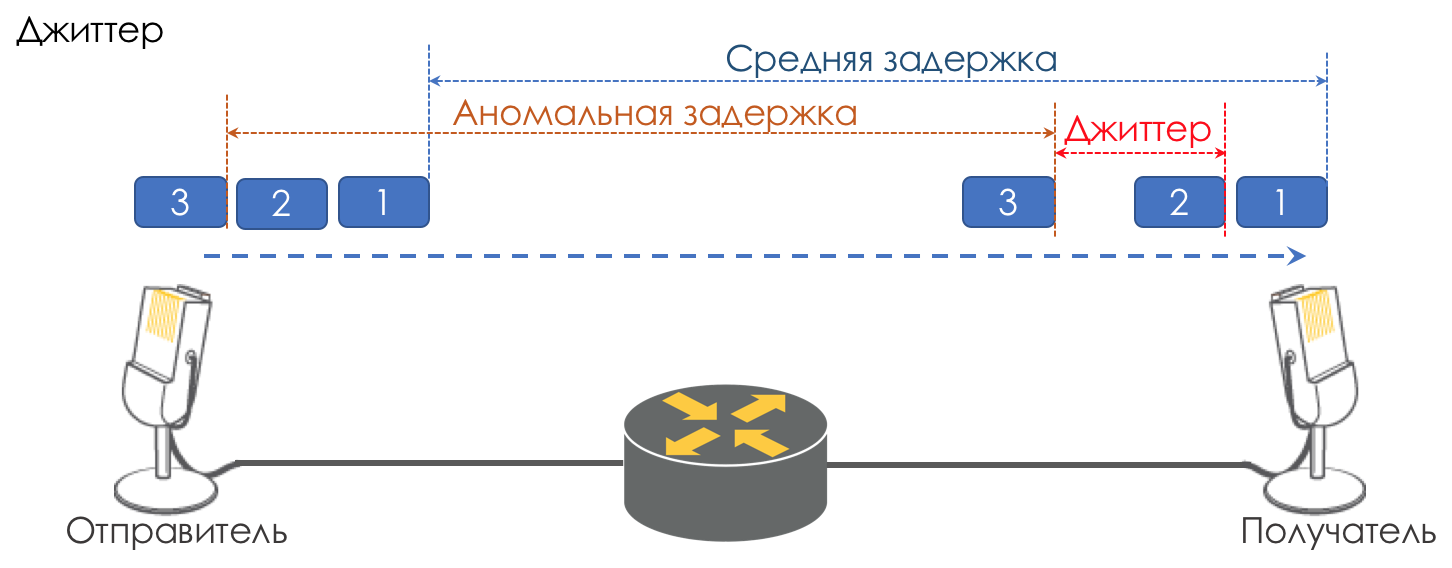

Джиттер

Разница в задержках между доставкой последовательных пакетов называется джиттером.

Как и задержка, джиттер для многих приложений не имеет значения. И даже, казалось бы, какая разница — пакет доставлен, чего же боле?

Однако для интерактивных сервисов он важен.

Возьмём в качестве примера ту же телефонию. По сути она является оцифровкой аналоговых сигналов с разбиением на отдельные чанки данных. На выходе получается достаточно равномерный поток пакетов. На принимающей стороне есть небольшой буфер фиксированного размера, в который укладываются последовательно поступающие пакеты. Для восстановление аналогового сигнала необходимо определённое их количество. В условиях плавающих задержек следующий чанк данных может не прийти вовремя, что равносильно потере, и сигнал не удаётся восстановить.

Наибольший вклад в вариативность задержки вносит как раз QoS. Об этом тоже много и нудно в тех же главах Ограничение скорости.

Это три основные характеристики качества сети, но есть две другие, которые тоже играют не последнюю роль.

Неупорядоченная доставка

Ряд приложений, таких как телефония, NAS, CES экстремально чувствительны к неупорядоченной доставке пакетов, когда они приходят к получателю не в том порядке, в котором были отправлены. Это может приводить к потере связности, ошибкам, повреждению файловой системы.

И хотя неупорядоченная доставка не является формально характеристикой QoS, но определённо относится к качеству сети.

Даже в случае TCP, толерантного к этому виду проблем, происходят дублирующиеся ACK’и и ретрансмиты.

Полоса пропускания

Её не выделяют, как метрику качества сети, поскольку фактически её недостаток выливается в три указанные выше. Однако в наших реалиях, когда некоторым приложениям она должна быть гарантирована или, наоборот, по договору должна быть ограничена, а например MPLS TE её резервирует на всём протяжении LSP, упомянуть её, хотя бы как слабую метрику, стоит.

Механизмы управления скоростью рассмотрим в главах Ограничение скорости.

Почему характеристики могут портиться?

Итак, начнём мы с очень примитивного представления, что сетевое устройство (будь то коммутатор, маршрутизатор, файрвол, да что угодно) — это просто ещё один кусочек трубы под названием канал связи, такой же, как медный провод или оптический кабель.

Тогда все пакеты пролетают насквозь в том же порядке, в котором они пришли и не испытывают никаких дополнительных задержек — негде задерживаться.

Но на самом деле каждый маршрутизатор восстанавливает из сигнала биты и пакеты, что-то с ними делает (об этом пока не думаем) и потом обратно преобразует пакеты в сигнал.

Появляется задержка сериализации. Но в целом это не страшно поскольку она постоянна. Не страшно до тех пор, пока ширина выходного интерфейса больше, чем входного.

Например, на входе в устройство гигабитный порт, а на выходе радио-релейная линия 620 Мб/с, подключенная в такой же гигабитный порт?

Никто не запретит пулять через формально гигабитный линк гигабит трафика.

Ничего тут не поделаешь — 380 Мб/с будут проливаться на пол.

Вот они — потери.

Но при этом очень бы хотелось, чтобы проливалась худшая его часть — видео с youtube, а телефонный разговор исполнительного директора с директором завода не прерывался и даже не квакал.

Хотелось бы, чтобы у голоса была выделенная линия.

Или входных интерфейсов пять, а выходной один, и одновременно пять узлов начали пытаться влить трафик одному получателю.

Добавим щепотку теории VoIP (статью, про который никто так и не написал) — он весьма чувствителен к задержкам и их вариации.

Если для TCP-потока видео с youtube (на момент написания статьи QUIC — ещё остаётся экспериментом) задержки даже в секунды ровным счётом ничего не стоят благодаря буферизации, то директор после первого же такого разговора с камчаткой призовёт к себе руководителя тех.отдела.

В более старые времена, когда автор цикла ещё делал уроки по вечерам, проблема стояла особенно остро. Модемные соединения имели скорость 56к.

И когда в такое соединение приходил полуторакилобайтный пакет, он оккупировал всю линию на 200 мс. Никто другой в этот момент пройти не мог. Голос? Не, не слышал.

Поэтому таким важным является вопрос MTU — пакет не должен слишком надолго оккупировать интерфейс. Чем менее он скоростной, тем меньший MTU необходим.

Вот они — задержки.

Сейчас канал свободен и задержка низкая, через секунду кто-то начал качать большой файл и задержки выросли. Вот он — джиттер.

Таким образом нужно, чтобы голосовые пакеты пролетали через трубу с минимальными задержками, а youtube подождёт.

Имеющиеся 620 Мб/с нужно использовать и для голоса, и для видео, и для B2B клиентов, покупающих VPN. Хотелось бы, чтобы один трафик не притеснял другой, значит нужна гарантия полосы.

Все вышеуказанные характеристики универсальны относительно природы сети. Однако существует три разных подхода к их обеспечению.

2. Три модели обеспечения QoS

- Best Effort — никакой гарантии качества. Все равны.

- IntServ — гарантия качества для каждого потока. Резервирование ресурсов от источника до получателя.

- DiffServ — нет никакого резервирования. Каждый узел сам определяет, как обеспечить нужное качество.

Best Effort (BE)

Никаких гарантий.

Самый простой подход к реализации QoS, с которого начинались IP-сети и который практикуется и по сей день — иногда потому что его достаточно, но чаще из-за того, что никто и не думал о QoS.

Кстати, когда вы отправляете трафик в Интернет, то он там будет обрабатываться как BestEffort. Поэтому через VPN, прокинутые поверх Интернета (в противовес VPN, предоставляемому провайдером), может не очень уверенно ходить важный трафик, вроде телефонного разговора.

В случае BE — все категории трафика равны, никакому не отдаётся предпочтение. Соответственно, нет гарантий ни задержки/джиттера, ни полосы.

Этот подход носит несколько контринтуитивное название — Best Effort, которое новичка вводит в заблуждение словом «лучший».

Однако фраза «I will do my best» означает, что говорящий постарается сделать всё, что может, но не гарантирует ничего.

Для реализации BE не требуется ничего — это поведение по умолчанию. Это дёшево в производстве, персоналу не нужны глубокие специфические знания, QoS в этом случае не поддаётся никакой настройке.

Однако эта простота и статичность не приводят к тому, что подход Best Effort нигде не используется. Он находит применение в сетях с высокой пропускной способностью и отсутствием перегрузок и всплесков.

Например, на трансконтинентальных линиях или в сетях некоторых ЦОДов, где нет переподписки.

Иными словами в сетях без перегрузок и где нет необходимости особенным образом относиться к какому-либо трафик (например, телефонии), BE вполне уместен.

IntServ

Заблаговременное резервирование ресурсов для потока на всём протяжении от источника до получателя.

В растущий бессистемно Интернет отцы сетей MIT, Xerox, ISI решили добавить элемент предсказуемости, сохранив его работоспособность и гибкость.

Так в 1994 году родилась идея IntServ в ответ на стремительный рост реал-тайм трафика и развитие мультикаста. Сокращалась она тогда до IS.

Название отражает стремление в одной сети одновременно предоставлять услуги для реал-тайм и не-реал-тайм типов трафика, предоставив, при этом первым приоритетное право использования ресурсов через резервирование полосы. Возможность переиспользования полосы, на которой все и зарабатывают, и благодаря чему IP выстрелил, при этом сохранялась.

Миссию по резервированию возложили на протокол RSVP, который для каждого потока резервирует полосу на каждом сетевом устройстве.

Грубо говоря, до установки A Single Rate Three Color MarkerP сессии или начала обменом данными, конечные хосты отправляют RSVP Path с указанием требуемой полосы. И если обоим вернулся RSVP Resv — они могут начать коммуницировать. При этом, если доступных ресурсов нет, то RSVP возвращает ошибку и хосты не могут общаться или пойдут по BE.

Пусть теперь храбрейшие из читателей представят, что для любого потока в интернете сегодня будет сигнализироваться канал заранее. Учтём, что это требует ненулевых затрат CPU и памяти на каждом транзитном узле, откладывает фактическое взаимодействие на некоторое время, становится понятно, почему IntServ оказался фактически мертворожденной идеей — нулевая масштабируемость.

В некотором смысле современная инкарнация IntServ — это MPLS TE с адаптированной под передачу меток версией RSVP — RSVP TE. Хотя здесь, конечно же не End-to-End и не per-flow.

IntServ описан в RFC 1633.

Документ в принципе любопытен, чтобы оценить, насколько можно быть наивным в прогнозах.

DiffServ

DiffServ сложный.

Когда в конце 90-х стало понятно, что End-to-End подход IntServ в IP провалился, в IETF созвали в 1997 рабочую группу «Differentiated Services», которая выработала следующие требования к новой модели QoS:

- Никакой сигнализации (Адьёс, RSVP!).

- Основан на агрегированной классификации трафика, вместо акцента на потоках, клиентах итд.

- Имеет ограниченный и детерминированный набор действий по обработке трафика данных классов.

В результате в 1998 родились эпохальные RFC 2474 (Definition of the Differentiated Services Field (DS Field) in the IPv4 and IPv6 Headers) и RFC 2475 (An Architecture for Differentiated Services).

И дальше всю дорогу мы будем говорить только о DiffServ.

Стоит обратить внимание, что название DiffServ — это не антитеза IntServ. Оно отражает, что мы дифференцируем сервисы, предоставляемые различным приложениям, а точнее их трафику, иными словами разделяем/дифференцируем эти типы трафика.

IntServ делает то же самое — он различает типы трафика BE и Real-Time, передающиеся на одной сети. Оба: и IntServ и DiffServ — относятся к способам дифференциации сервисов.

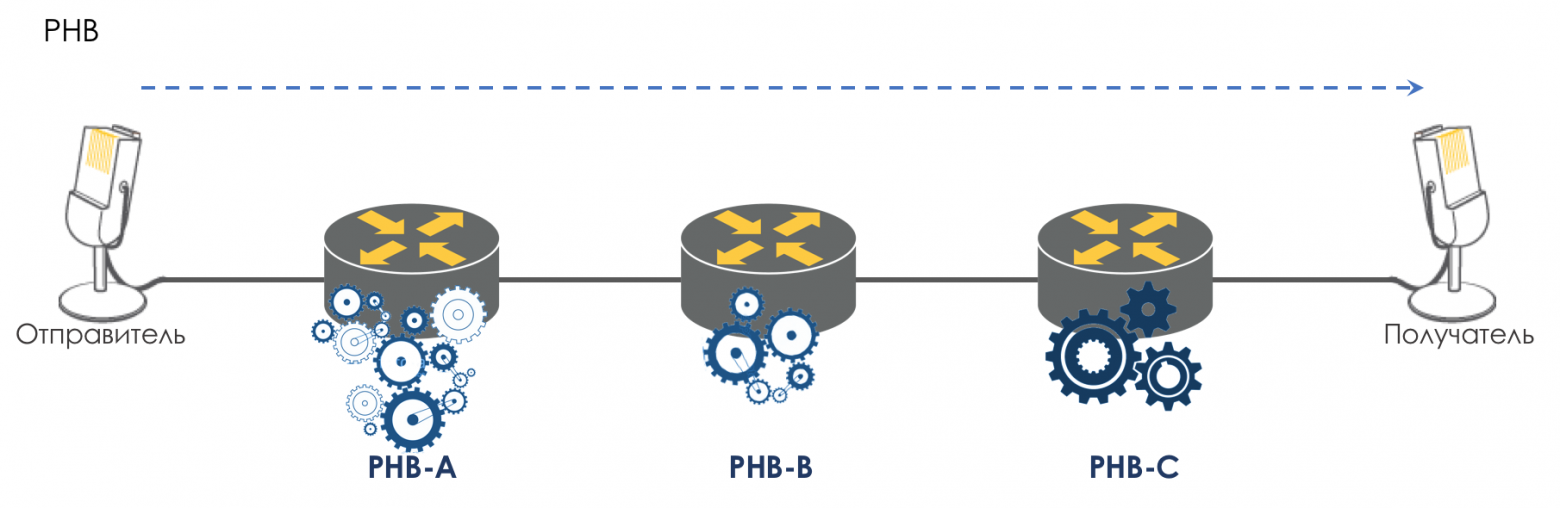

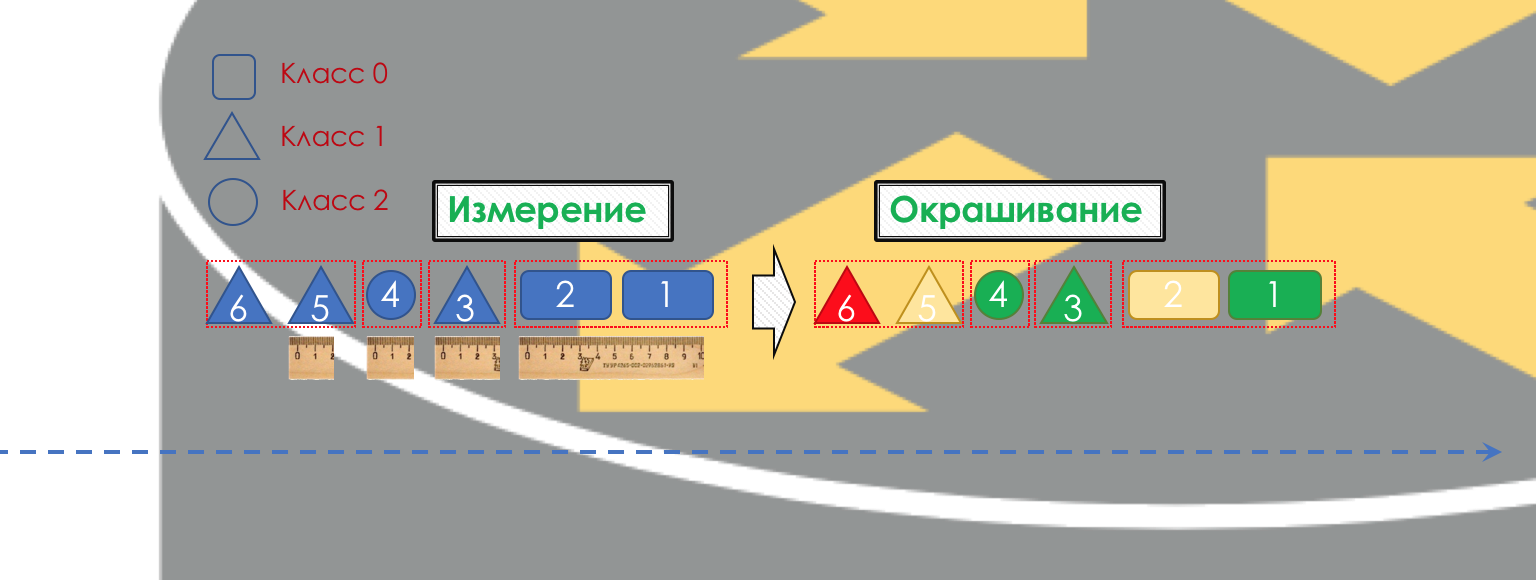

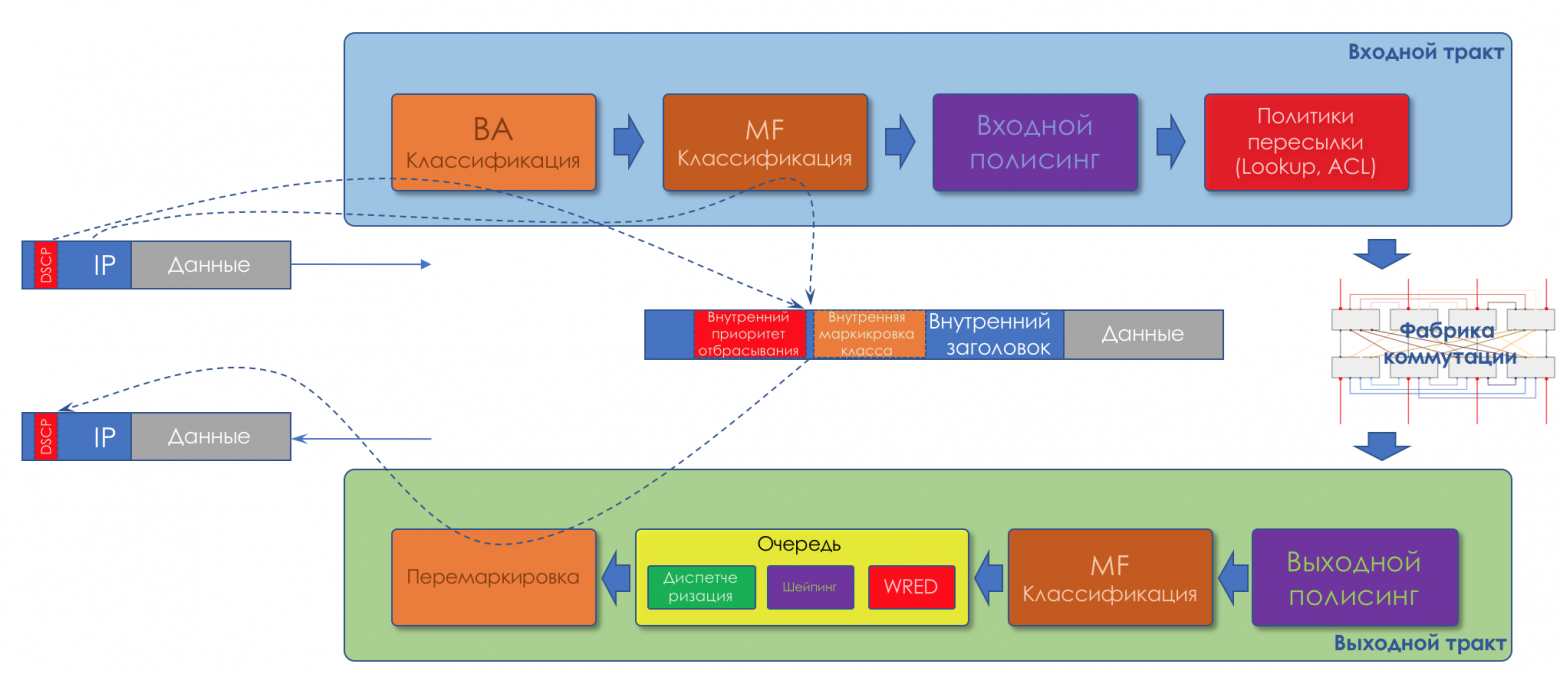

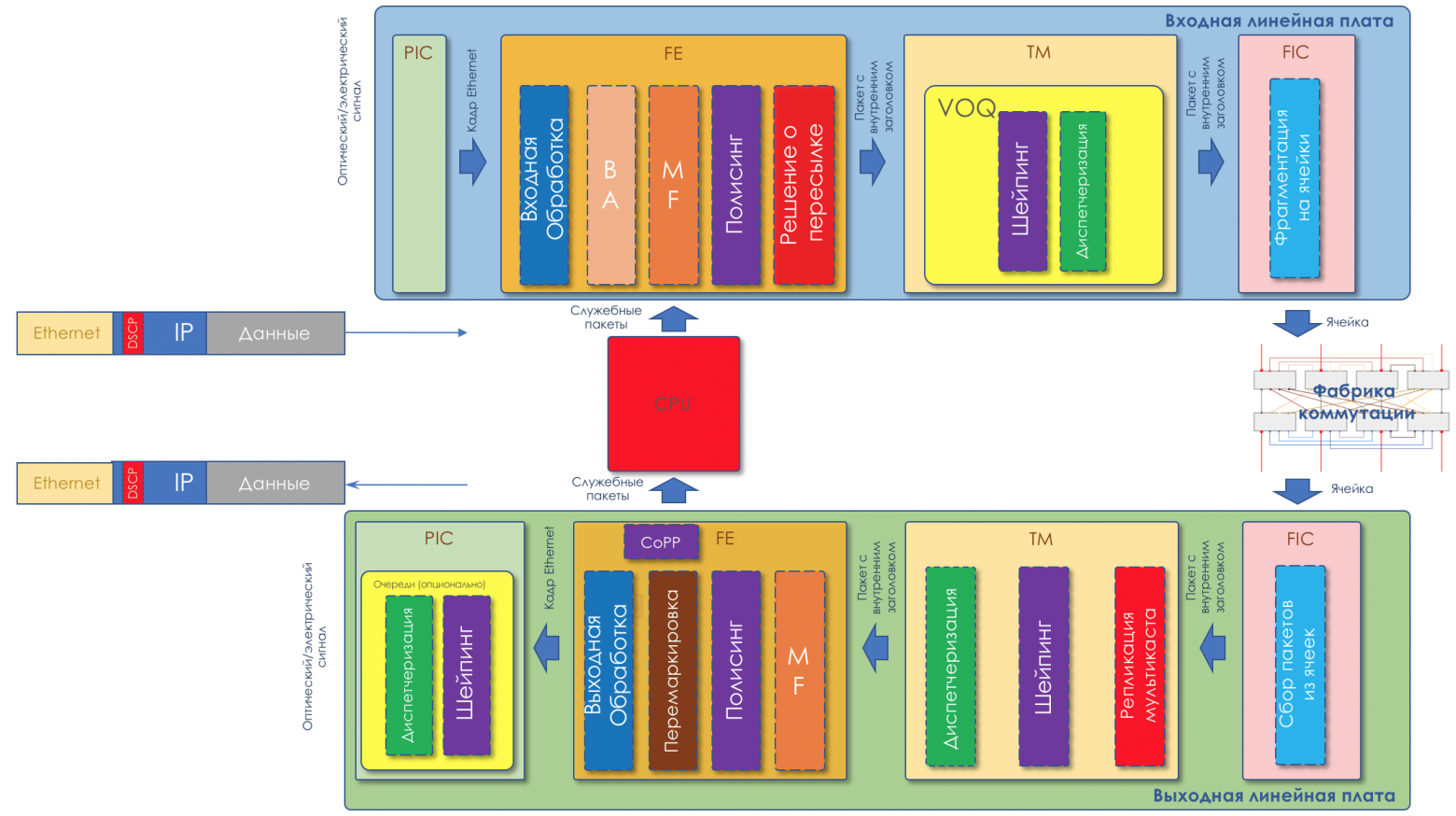

3. Механизмы DiffServ

Что же собой являет DiffServ и почему он выигрывает у IntServ?

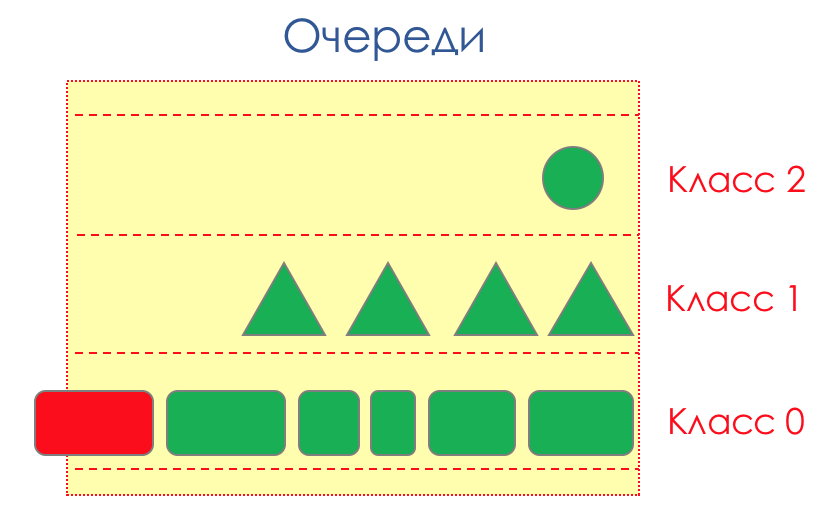

Если очень просто, то трафик делится на классы. Пакет на входе в каждый узел классифицируется и к нему применяется набор инструментов, который по-разному обрабатывает пакеты разных классов, таким образом обеспечивая им разный уровень сервиса.

Но просто не будет.

В основе DiffServ лежит идеологически выдержанная в традициях IP концепция PHB — Per-Hop Behavior. Каждый узел по пути трафика самостоятельно принимает решение о том, как вести себя относительно пришедшего пакета, на основе его заголовков.

Действия маршрутизатора с пакетом назовём моделью поведения (Behavior). Количество таких моделей детерминировано и ограничено. На разных устройствах модели поведения по отношению к одному и тому же трафику могут отличаться, поэтому они и per-hop.

Понятия Behavior и PHB я буду использовать в статье как синонимы.

Тут есть лёгкая путаница. PHB — это с одной стороны общая концепция независимого поведения каждого узла, с другой — конкретная модель на конкретном узле. С этим мы ещё разберёмся.

Модель поведения определяется набором инструментов и их параметров: Policing, Dropping, Queuing, Scheduling, Shaping.

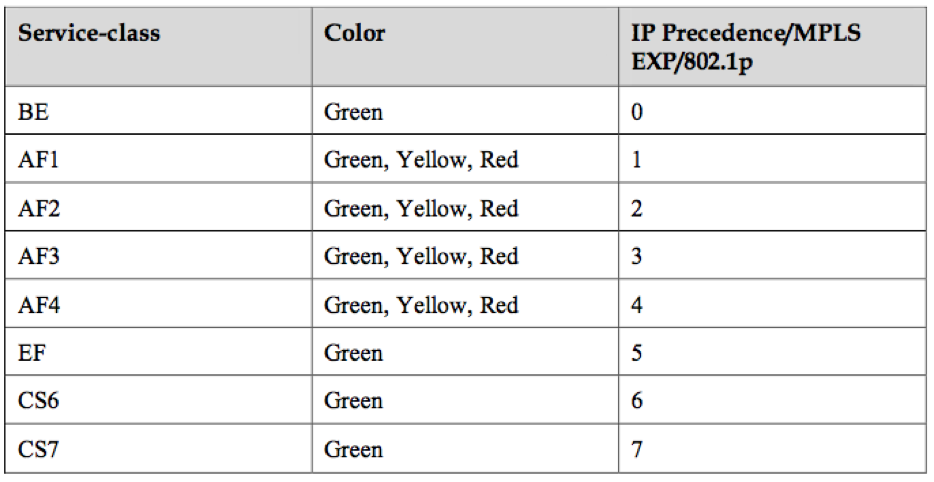

Используя имеющиеся модели поведения, сеть может предоставлять различные классы сервиса (Class of Service).

То есть разные категории трафика могут получить разный уровень сервиса в сети путём применения к ним разных PHB.

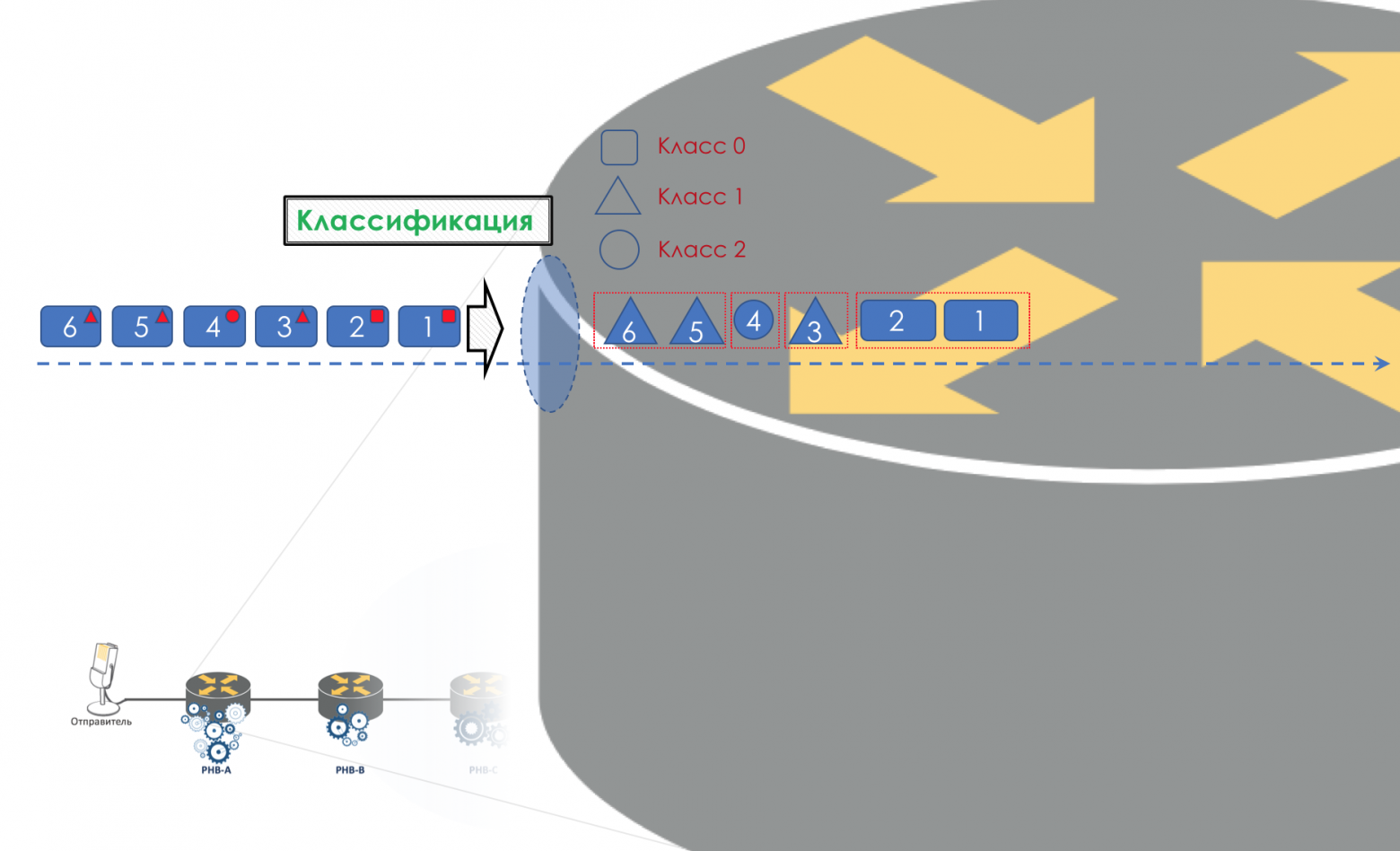

Соответственно прежде всего нужно определить к какому классу сервиса относится трафик — классификация (Classification).

Каждый узел самостоятельно классифицирует поступающие пакеты.

После классификации происходит измерение (Metering) — сколько битов/байтов трафика данного класса пришло на маршрутизатор.

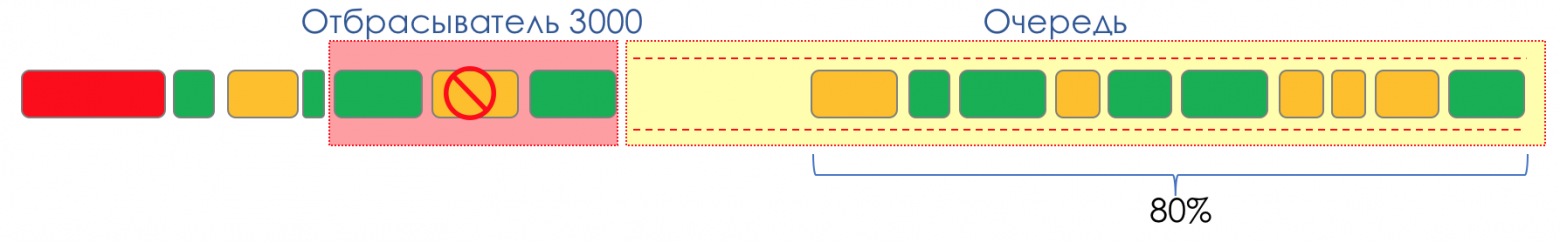

На основе результатов пакеты могут окрашиваться (Coloring): зелёный (в рамках установленного лимита), жёлтый (вне лимита), красный (совсем берега попутал).

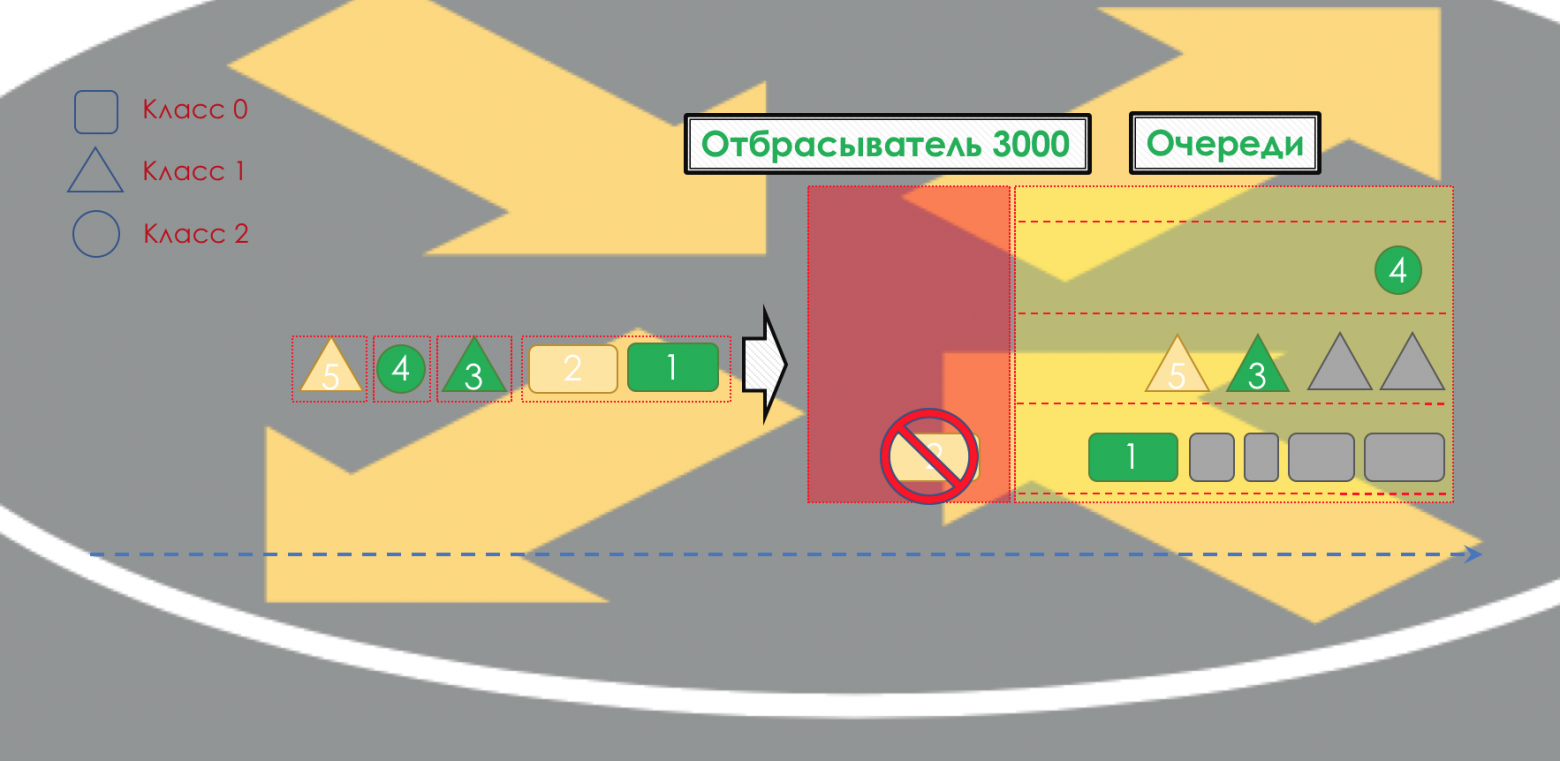

Если необходимо, далее происходит полисинг (Policing) (уж простите за такую кальку, есть вариант лучше — пишите, я поменяю). Полисер на основе цвета пакета назначает действие по отношению к пакету — передать, отбросить или перемаркировать.

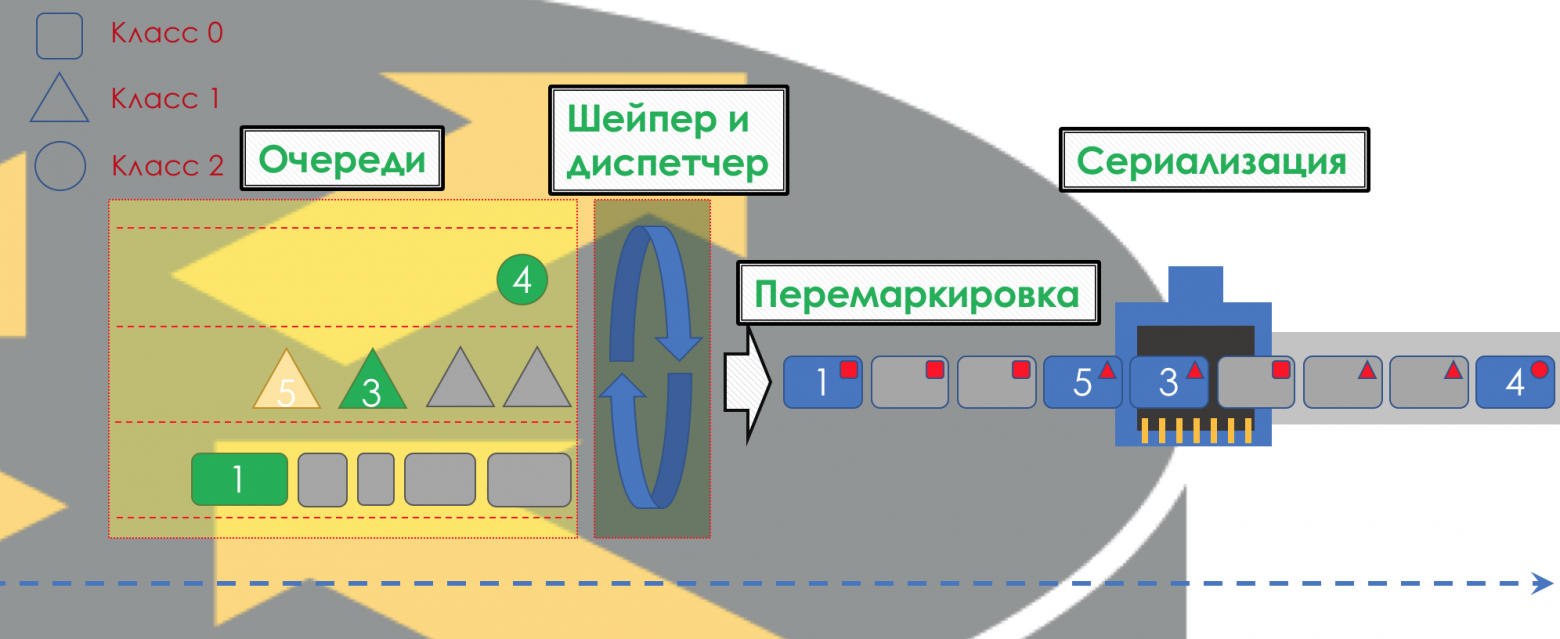

После этого пакет должен попасть в одну из очередей (Queuing). Для каждого класса сервиса выделена отдельная очередь, что и позволяет их дифференцировать, применяя разные PHB.

Но ещё до того, как пакет попадёт в очередь, он может быть отброшен (Dropper), если очередь заполнена.

Если он зелёный, то он пройдёт, если жёлтый, то его вполне вероятно, отбросят, если очередь полна, а если красный — это верный смертник. Условно, вероятность отбрасывания зависит от цвета пакета и наполненности очереди, куда он собирается попасть.

На выходе из очереди работает шейпер (Shaper), задача которого очень похожа на задачу полисера — ограничить трафик до заданного значения.

Можно настроить произвольные шейперы для отдельных очередей или даже внутри очередей.

Об отличии шейпера от полисера в главе Ограничение скорости.

Все очереди в итоге должны слиться в единый выходной интерфейс.

Вспомните ситуацию, когда на дороге 8 полос сливаются в 3. Без регулировщика это превращается в хаос. Разделение по очередям не имело бы смысла, если бы на выходе мы имели то же, что на входе.

Поэтому есть специальный диспетчер (Scheduler), который циклически вынимает пакеты из разных очередей и отправляет в интерфейс (Scheduling).

На самом деле связка набора очередей и диспетчера — самый главный механизм QoS, который позволяет применять разные правила к разным классам трафика, одним обеспечивая широкую полосу, другим низкие задержки, третьим отсутствие дропов.

Далее пакеты уже выходят на интерфейс, где происходит преобразование пакетов в поток битов — сериализация (Serialization) и далее сигнал среды.

В DiffServ поведение каждого узла независимо от остальных, нет протоколов сигнализации, которые бы сообщили, какая на сети политика QoS. При этом в пределах сети хотелось бы, чтобы трафик обрабатывался одинаково. Если всего лишь один узел будет вести себя иначе, вся политика QoS псу под хвост.

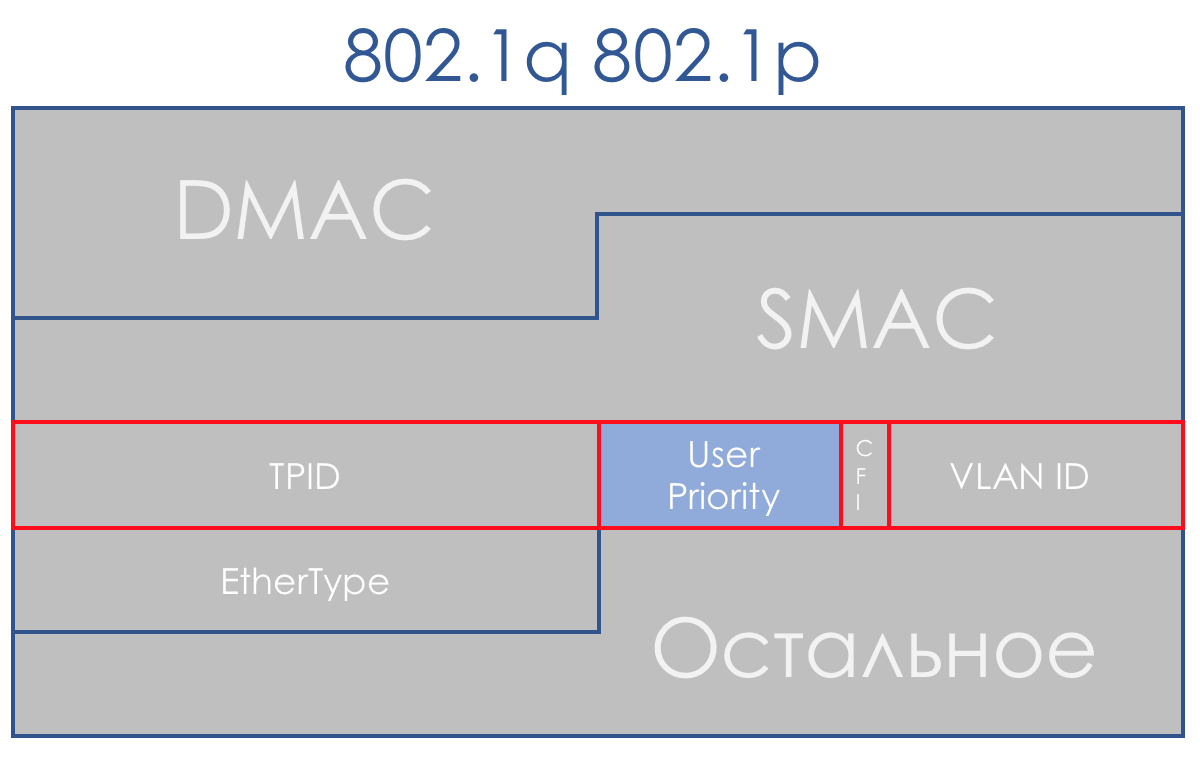

Для этого, во-первых, на всех маршрутизаторах, настраиваются одинаковые классы и PHB для них, а во-вторых, используется маркировка (Marking) пакета — его принадлежность определённому классу записывается в заголовок (IP, MPLS, 802.1q).

И красота DiffServ в том, что следующий узел может довериться этой маркировке при классификации.

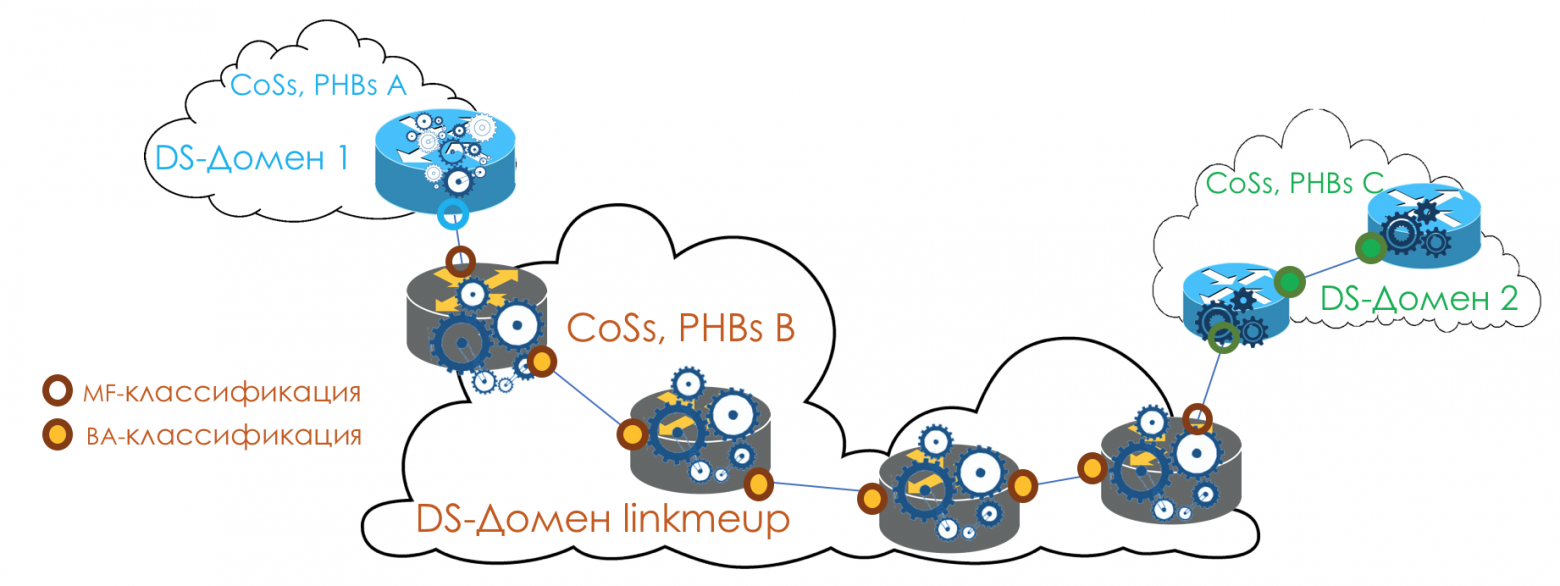

Такая зона доверия, в которой действуют одинаковые правила классификации трафика и одни модели поведения, называется домен DiffServ (DiffServ-Domain).

Таким образом на входе в домен DiffServ мы можем классифицировать пакет на основе 5-Tuple или интерфейса, промаркировать (Remark/Rewrite) его согласно правилам домена, и дальнейшие узлы будут доверять этой маркировке и не делать сложную классификацию.

То есть явной сигнализации в DiffServ нет, но узел может сообщить всем следующим, какой класс нужно обеспечить этому пакету, ожидая, что тот доверится.

На стыках между DiffServ-доменами нужно согласовывать политики QoS (или не нужно).

Целиком картина будет выглядеть примерно так:

Чтобы было понятно, приведу аналог из реальной жизни.

Перелёт на самолёте (не Победой).

Есть три класса сервиса (CoS): Эконом, Бизнес, Первый.

При покупке билета происходит классификация (Classification) — пассажир получает определённый класс сервиса на основе цены.

В аэропорту происходит маркировка (Remark) — выдаётся билет с указанием класса.

Есть две модели поведения (PHB): Best Effort и Premium.

Есть механизмы, реализующие модели поведения: Общий зал ожидания или VIP Lounge, микроавтобус или общий автобус, удобные большие сиденья или плотностоящие ряды, количество пассажиров на одну борт-проводницу, возможность заказать алкоголь.

В зависимости от класса назначаются модели поведения — эконому Best Effort, Бизнесу — Premium базовый, а Первому — Premium SUPER-POWER-NINJA-TURBO-NEO-ULTRA-HYPER-MEGA-MULTI-ALPHA-META-EXTRA-UBER-PREFIX!

При этом два Premium отличаются тем что, в одном дают бокал полусладкого, а в другом безлимит Бакарди.Далее по приезду в аэропорт все заходят через одни двери. Тех, кто попытался провезти с собой оружие или не имеет билета, не пускают (Drop). Бизнес и эконом попадают в разные залы ожидания и разный транспорт (Queuing). Сначала на борт пускают Первый класс, потом бизнес, потом эконом (Scheduling), однако потом они в пункт назначения все летят одним самолётом (интерфейс).

В этом же примере перелёт на самолёте — это задержка передачи (Propagation), посадка — задержка сериализации (Serialization), ожидание самолёта в залах — Queuing, а паспортный контроль — Processing. Заметьте, что и тут Processing Delay обычно пренебрежимо мал в масштабах общего времени.

Следующий аэропорт может обойтись с пассажирами совсем иначе — его PHB отличается. Но при этом если пассажир не меняет авиакомпанию, то, скорее всего, отношение к нему не поменяется, потому что одна компания — один DiffServ-domain.

Как вы могли уже заметить, DiffServ предельно (или беспредельно) сложен. Но всё описанное выше, мы разберём. При этом в статье я не буду вдаваться в нюансы физической реализации (они могут различаться даже на двух платах одного маршрутизатора), не буду рассказывать про HQoS и MPLS DS-TE.

Порог входа в круг инженеров, понимающих технологию, для QoS значительно выше, чем для протоколов маршрутизации, MPLS, или, прости меня Радья, STP.

И несмотря на это DiffServ заслужил признание и внедрение на сетях по всему миру, потому что, как говорится, хайли скэлэбл.

Всю дальнейшую часть статьи я буду разбирать только DiffServ.

Ниже мы разберём все инструменты и процессы, указанные на иллюстрации.

По ходу раскрытия темы некоторые вещи я буду показывать на практике.

Работать мы будем вот с такой сетью:

Trisolarans — это клиент провайдера linkmeup с двумя точками подключения.

Жёлтая область — это DiffServ-домен сети linkmeup, где действует единая политика QoS.

Linkmeup_R1 — это CPE устройство, которое находится под управлением провайдера, а потому в доверенной зоне. С ним поднят OSPF и взаимодействие происходит через чистый IP.

В пределах ядра сети MPLS+LDP+MP-BGP с L3VPN, растянутый от Linkmeup_R2 до Linkmeup_R4.

Все остальные комментарии я буду давать по мере необходимости.

Файл начальной конфигурации.

4. Классификация и маркировка

Внутри своей сети администратор определяет классы сервиса, которые он может предоставлять трафику.

Поэтому первое, что делает каждый узел при получении пакета, проводит его классификацию.

Существует три способа:

- Behavior Aggregate (BA)

Просто довериться имеющейся маркировке пакета в его заголовке. Например, полю IP DSCP.

Называется он так, потому что под одной меткой в поле DSCP агрегированы различные категории трафика, которые ожидают одинакового по отношению к себе поведения. Например, все SIP-сессии будут агрегированы в один класс.Количество возможных классов сервиса, а значит и моделей поведения, ограничено. Соответственно нельзя каждой категории (или тем более потоку) выделить отдельный класс — приходится агрегировать.

- Interface-based

Всё, что приходит на конкретный интерфейс, помещать в один класс трафика. Например, мы точно знаем, что в этот порт подключен сервер БД и больше ничего. А в другой рабочая станция сотрудника. - MultiField (MF)

Проанализировать поля заголовков пакета — IP-адреса, порты, MAC-адреса. Вообще говоря, произвольные поля.Например, весь трафик, который идёт в подсеть 10.127.721.0/24 по порту 5000, нужно маркировать как трафик, условно, требующий 5-й класс сервиса.

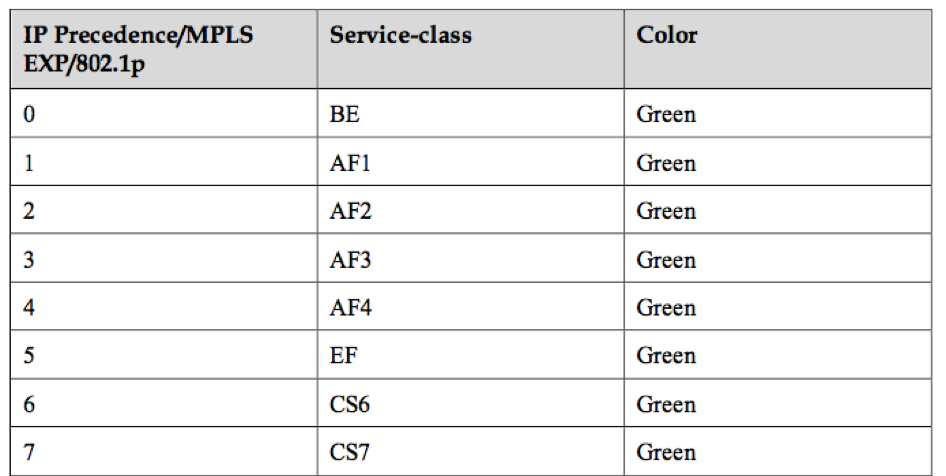

Администратор определяет набор классов сервиса, которые сеть может предоставлять, и сопоставляет им некоторое цифровое значение.

На входе в DS-домен мы никому не доверяем, поэтому проводится классификация вторым или третьим способом: на основе адресов, протоколов или интерфейсов определяется класс сервиса и соответствующее цифровое значение.

На выходе из первого узла эта цифра кодируется в поле DSCP заголовка IP (или другое поле Traffic Class: MPLS Traffic Class, IPv6 Traffic Class, Ethernet 802.1p) — происходит ремаркировка.

Внутри DS-домена принято доверять этой маркировке, поэтому транзитные узлы используют первый способ классификации (BA) — наиболее простой. Никакого сложного анализа заголовков, смотрим только записанную цифру.

На стыке двух доменов можно классифицировать на основе интерфейса или MF, как я описал выше, а можно довериться маркировке BA с оговорками.

Например, доверять всем значениям, кроме 6 и 7, а 6 и 7 перемаркировывать в 5.

Такая ситуация возможна в случае, когда провайдер подключает юрлицо, у которого есть своя политика маркировки. Провайдер не возражает сохранить её, но при этом не хочет, чтобы трафик попадал в класс, в котором у него передаются пакеты сетевых протоколов.

Behavior Aggregate

В BA используется очень простая классификация — вижу цифру — понимаю класс.

Так что же за цифра? И в какое поле она записывается?

- IPv6 Traffic Class

- MPLS Traffic Class

- Ethernet 802.1p

В основном классификация происходит по коммутирующему заголовку.

Коммутирующим я называю заголовок, на основе которого устройство определяет, куда отправить пакет, чтобы он стал ближе к получателю.

То есть если на маршрутизатор пришёл IP-пакет, анализируется заголовок IP и поле DSCP. Если пришёл MPLS, анализируется — MPLS Traffic Class.

Если на обычный L2-коммутатор пришёл пакет Ethernet+VLAN+MPLS+IP, то анализироваться будет 802.1p (хотя это можно и поменять).

IPv4 TOS

Поле QoS сопутствует нам ровно столько же, сколько и IP. Восьмибитовое поле TOS — Type Of Service — по задумке должно было нести приоритет пакета.

Ещё до появления DiffServ RFC 791 (INTERNET PROTOCOL) описывал поле так:

IP Precedence (IPP) + DTR + 00.

То есть идёт приоритет пакета, далее биты требовательности к Delay, Throughput, Reliability (0 — без требований, 1 — с требованиями).

Последние два бита должны быть нулём.

Приоритет определял следующие значения…

111 — Network Control

110 — Internetwork Control

101 — CRITIC/ECP

100 — Flash Override

011 — Flash

010 — Immediate

001 — Priority

000 — Routine

Чуть позже в RFC 1349 (Type of Service in the Internet Protocol Suite) поле TOS немного переопределили:

Левые три бита остались IP Precedence, четыре следующих превратились в TOS после добавления бита Cost.

Вот как следовало читать единицы в этих битах TOS:

- D — «minimize delay»,

- T — «maximize throughput»,

- R — «maximize reliability»,

- C — «minimize cost».

Туманные описания не способствовали популярности этого подхода.

Системный подход к QoS на всём протяжении пути отсутствовал, чётких рекомендаций, как использовать поле приоритета тоже не было, описание битов Delay, Throughput и Reliability было крайне туманным.

Поэтому в контексте DiffServ поле TOS ещё раз переопределили в RFC 2474 (Definition of the Differentiated Services Field (DS Field) in the IPv4 and IPv6 Headers):

Вместо битов IPP и DTRC ввели шестибитовое поле DSCP — Differentiated Services Code Point, два правых бита не были использованы.

С этого момента именно поле DSCP должно было стать главной маркировкой DiffServ: в него записывается определённое значение (код), которое в пределах данного DS-домена характеризует конкретный класс сервиса, необходимый пакету и его приоритет отбрасывания. Это та самая цифра.

Все 6 бит DSCP администратор может использовать, как ему заблагорассудится, разделяя максимум до 64 классов сервиса.

Однако в угоду совместимости с IP Precedence за первыми тремя битами сохранили роль Class Selector.

То есть, как и в IPP, 3 бита Class Selector позволяют определить 8 классов.

Однако это всё же не более, чем договорённость, которую в пределах своего DS-домена, администратор может легко игнорировать и использовать все 6 бит по усмотрению.

Далее также замечу, что согласно рекомендациям IETF, чем выше значение, записанное в CS, тем требовательнее этот трафик к сервису.

Но и это не стоит воспринимать как неоспоримую истину.

Если первые три бита определяют класс трафика, то следующие три используются для указания приоритета отбрасывания пакета (Drop Precedence или Packet Loss Priority — PLP).

Восемь классов — это много или мало? На первый взгляд мало — ведь так много разного трафика ходит в сети, что так и хочется каждому протоколу выделить по классу. Однако оказывается, что восьми достаточно для всех возможных сценариев.

Для каждого класса нужно определять PHB, который будет обрабатывать его как-то отлично от других классов.

Да и при увеличении делителя, делимое (ресурс) не увеличивается.

Я намеренно не говорю о том, какие значения какой именно класс трафика описывают, поскольку здесь нет стандартов и формально их можно использовать по своему усмотрению. Ниже я расскажу, какие классы и соответствующие им значения рекомендованы.

Биты ECN…

Двухбитовое поле ECN появилось только в RFC 3168 (Explicit Congestion Notification). Поле было определено с благой целью — сообщить конечным хостам в явном виде о том, что кто-то по пути испытывает перегрузку.

Например, когда в очередях маршрутизатора задерживаются пакеты надолго и заполняют их, например, на 85%, он меняет значение ECN, сообщая конечному хосту, что нужно помедленнее — что-то вроде Pause Frames в Ethernet.

В этом случае отправитель должен уменьшить скорость передачи и снизить нагрузку на страдающий узел.

При этом теоретически поддержка этого поля всеми транзитными узлами не обязательна. То есть использование ECN не ломает не поддерживающую его сеть.

Цель благая, но прежде применения в жизни ECN особо не находил. В наше время мега- и гиперскейлов на эти два бита смотрят с новым интересом.

ECN является одним из механизмов предотвращения перегрузок, о которых ниже.

Практика классификации DSCP

Не помешает немного практики.

Схема та же.

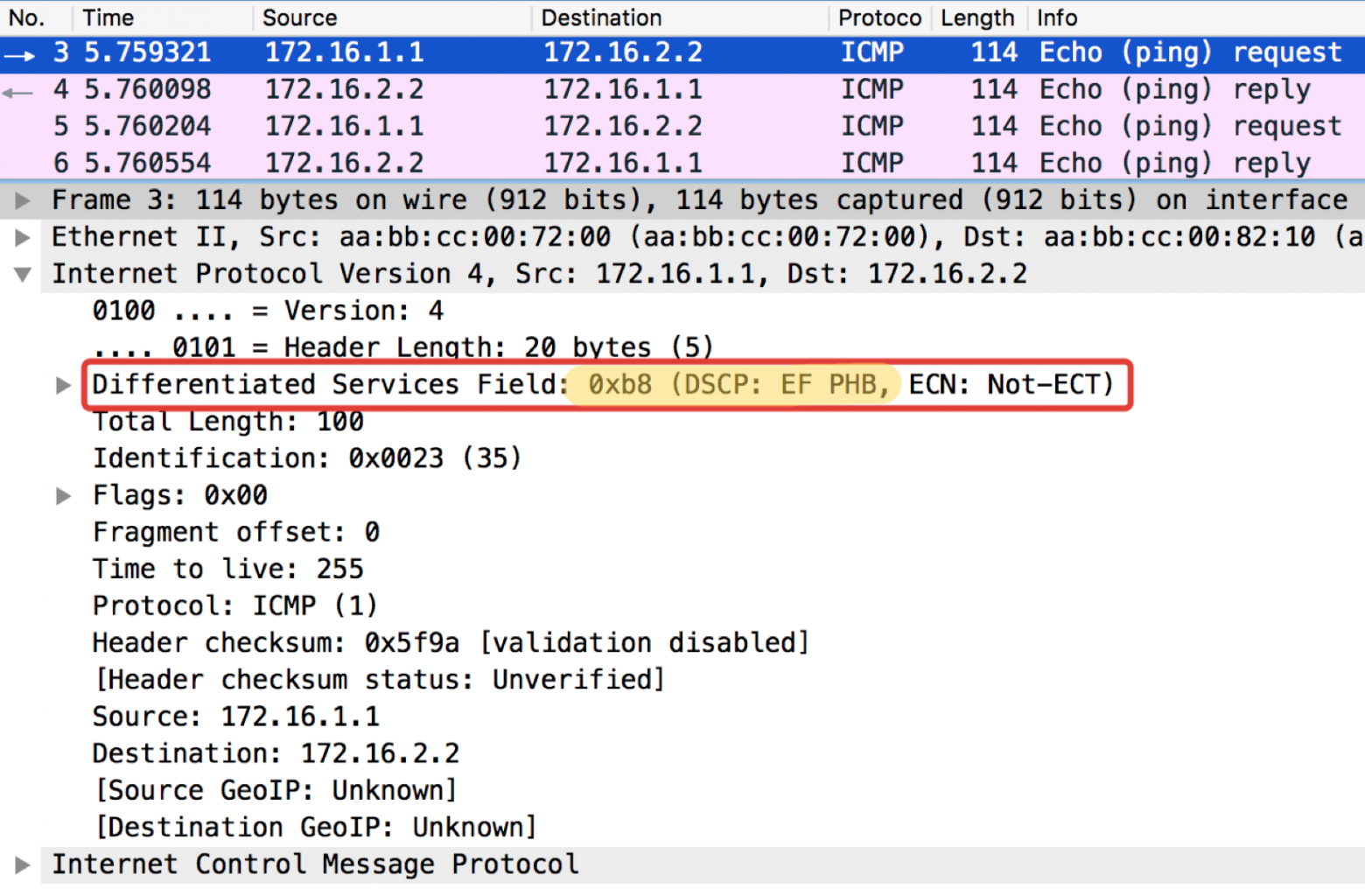

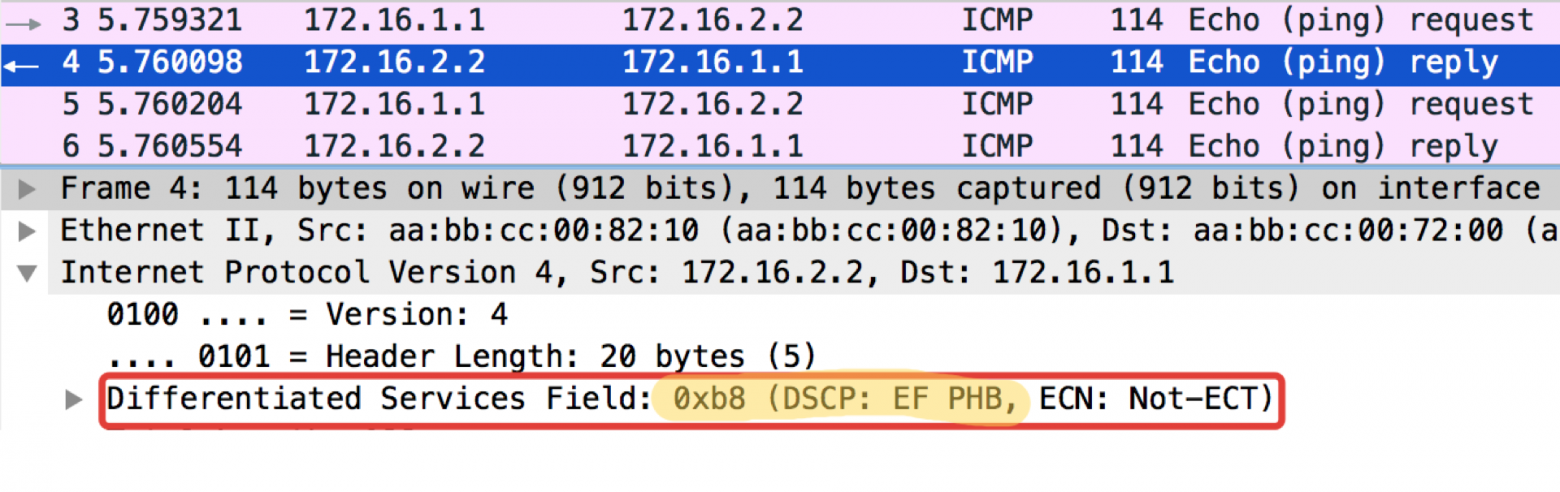

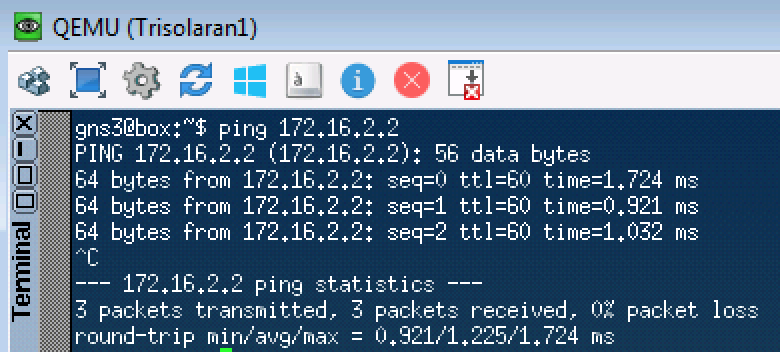

Для начала просто отправим запрос ICMP:

Linkmeup_R1#ping ip 172.16.2.2 source 172.16.1.1

Type escape sequence to abort.

Sending 5, 100-byte ICMP Echos to 172.16.2.2, timeout is 2 seconds:

Packet sent with a source address of 172.16.1.1

!!!!!

Success rate is 100 percent (5/5), round-trip min/avg/max = 1/1/1 msLinkmeup_R1. E0/0.

pcapng

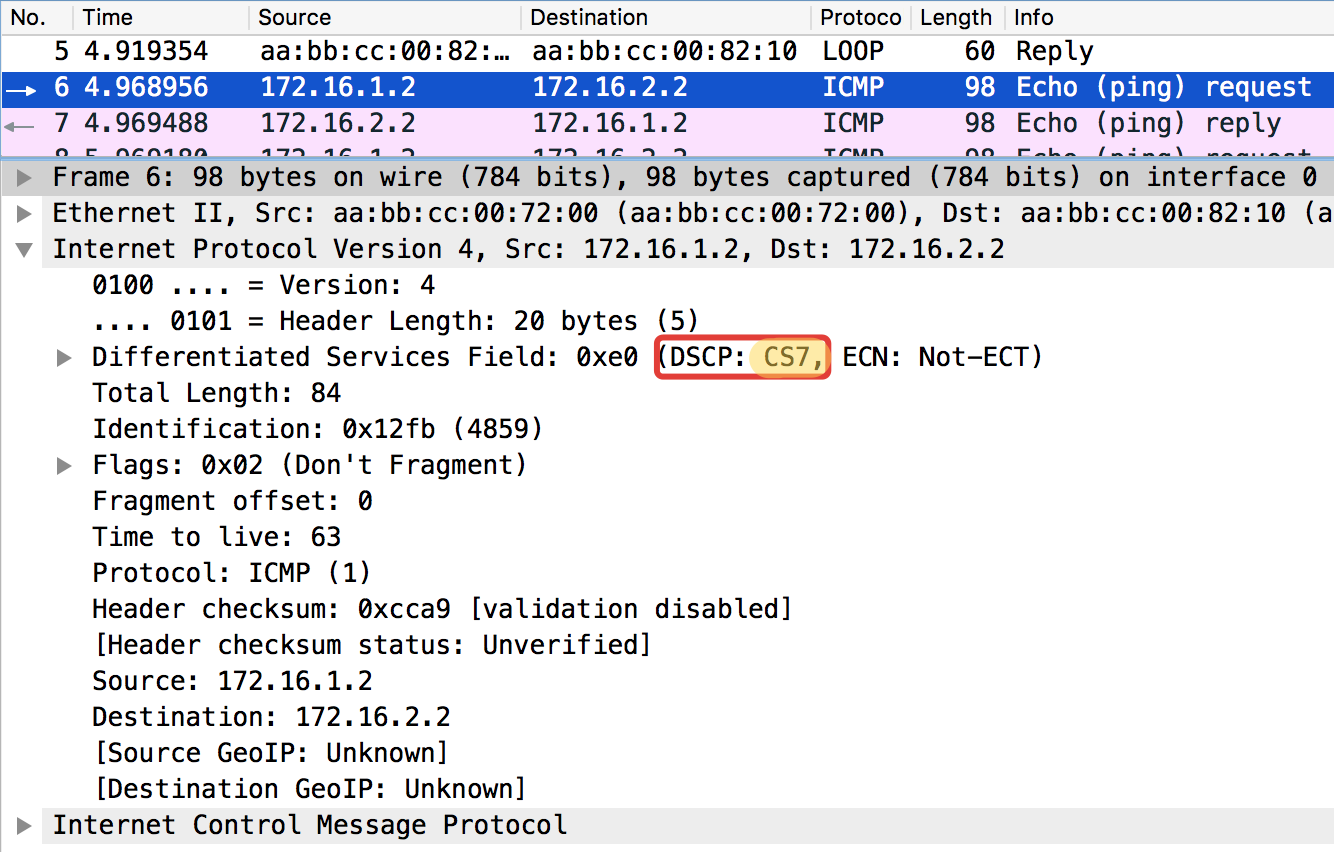

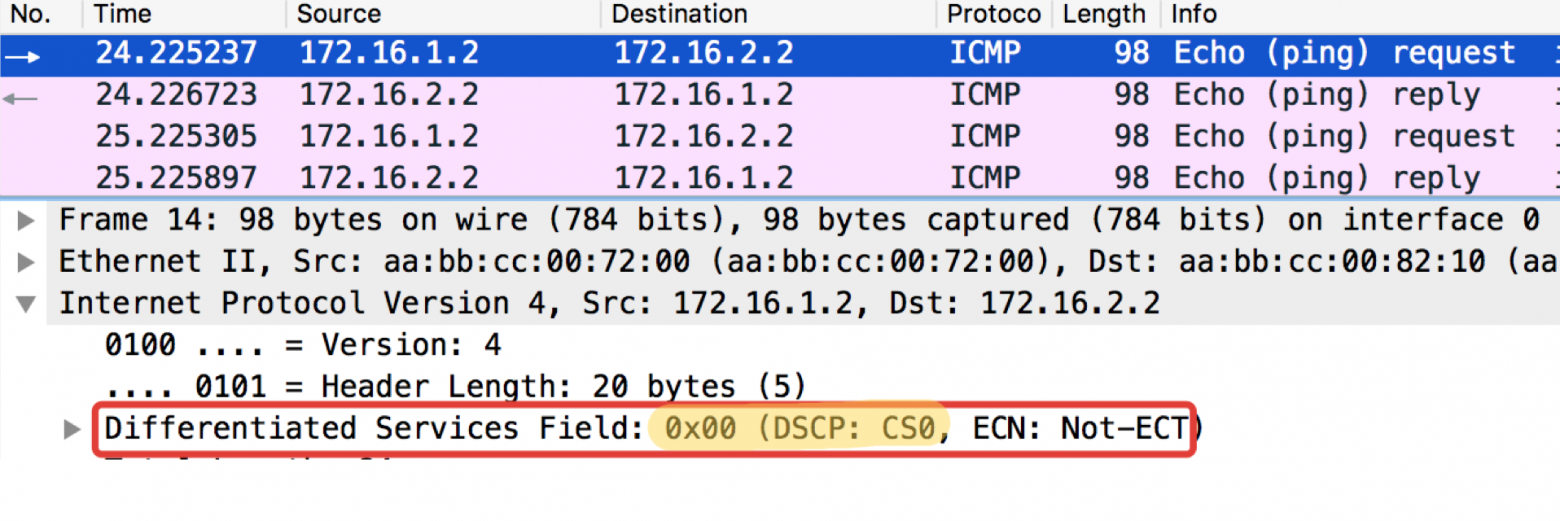

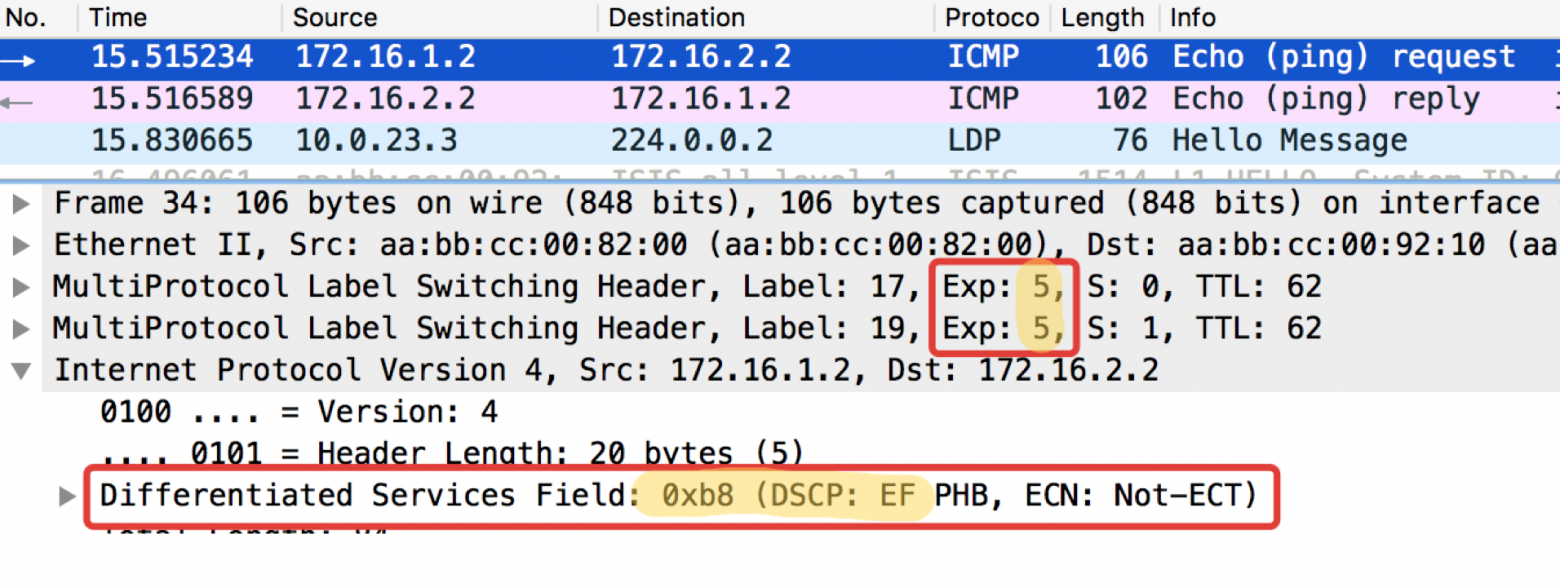

А теперь с установленным значением DSCP.

Linkmeup_R1#ping ip 172.16.2.2 source 172.16.1.1 tos 184

Type escape sequence to abort.

Sending 5, 100-byte ICMP Echos to 172.16.2.2, timeout is 2 seconds:

Packet sent with a source address of 172.16.1.1

!!!!!

Success rate is 100 percent (5/5), round-trip min/avg/max = 1/1/1 msЗначение 184 — это десятичное представление двоичного 10111000. Из них первые 6 бит — это 101110, то есть десятичные 46, а это класс EF.

Таблица стандартных значений TOS для удобных попингушек…

Подробнее

Ниже по тексту в главе Рекомендации IETF я расскажу, откуда взялись и эти цифры и названия.

Linkmeup_R2. E0/0

pcapng

Любопытное замечание: адресат попингушек в ICMP Echo reply устанавливает такое же значение класса, как было в Echo Request. Это логично — если отправитель послал пакет с определённым уровнем важности, то, очевидно, он хочет получить его гарантировано назад.

Linkmeup_R2. E0/0

Файл конфигурации DSCP классификации.

IPv6 Traffic Class

IPv6 мало чем в вопросе QoS отличается от IPv4. Восьмибитовое поле, называемое Traffic Class, также разбито на две части. Первые 6 бит — DSCP — играют ровно ту же роль.

Да, появился Flow Label. Говорят, что его можно было бы использовать для дополнительной дифференциации классов. Но применения в жизни эта идея пока нигде не нашла.

MPLS Traffic Class

Концепция DiffServ была ориентирована на IP-сети с маршрутизацией на основе IP-заголовка. Вот только незадача — через 3 года опубликовали RFC 3031 (Multiprotocol Label Switching Architecture). И MPLS начал захватывать сети провайдеров.

DiffServ нельзя было не распространить на него.

По счастливой случайности в MPLS заложили трёхбитовое поле EXP на всякий экспериментальный случай. И несмотря на то, что уже давным-давно в RFC 5462 («EXP» Field Renamed to «Traffic Class» Field) официально стало полем Traffic Class, по инерции его называют ИЭксПи.

С ним есть одна проблема — его длина три бита, что ограничивает число возможных значений до 9. Это не просто мало, это на 3 двоичных порядка меньше, чем у DSCP.

Учитывая, что часто MPLS Traffic Class наследуется из DSCP IP-пакета, имеем архивацию с потерей. Или же… Нет, вы не хотите этого знать… L-LSP. Использует комбинацию Traffic Class + значение метки.

Вообще согласитесь, ситуация странная — MPLS разрабатывался как помощь IP для быстрого принятия решения — метка MPLS мгновенно обнаруживается в CAM по Full Match, вместо традиционного Longest Prefix Match. То есть и про IP знали, и в коммутации участие принимает, а нормальное поле приоритета не предусмотрели.

На самом деле выше мы уже увидели, что для определения класса трафика используется только первые три бита DSCP, а три другие — Drop Precedence (или PLP — Packet Loss Priority).

Поэтому в плане классов сервиса всё же имеем соответствие 1:1, теряя только информацию о Drop Precedence.

В случае MPLS классификация так же как и в IP может быть на основе интерфейса, MF, значения DSCP IP или Traffic Class MPLS.

Маркировка означает запись значения в поле Traffic Class заголовка MPLS.

Пакет может содержать несколько заголовков MPLS. Для целей DiffServ используется только верхний.

Существуют три разных сценария перемаркировки при продвижении пакета из одного чистого IP-сегмента в другой через MPLS-домен: (это просто выдержка из статьи).

- Uniform Mode

- Pipe Mode

- Short-Pipe Mode

Режимы работы…

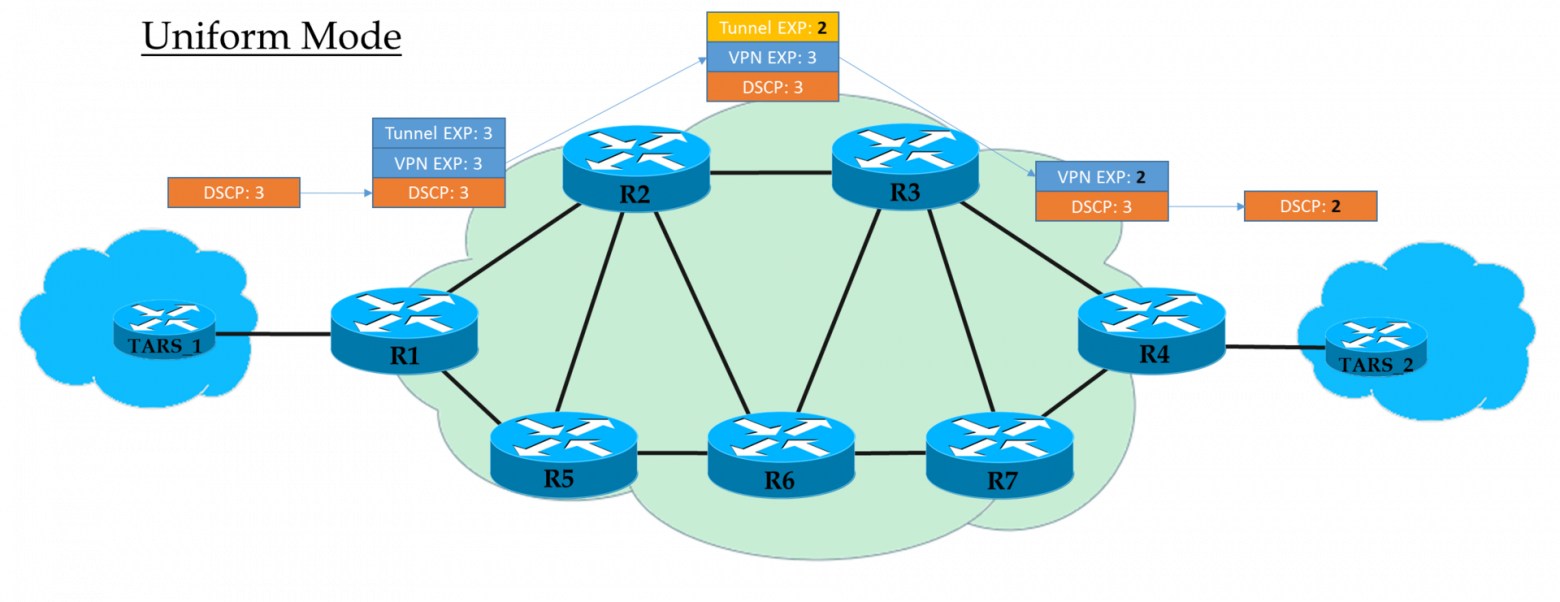

Uniform Mode

Это плоская модель End-to-End.

На Ingress PE мы доверяем IP DSCP и копируем (строго говоря, отображаем, но для простоты будем говорить «копируем») его значение в MPLS EXP (как туннельный, так и VPN заголовки). На выходе с Ingress PE пакет уже обрабатывается в соответствии со значением поля EXP верхнего заголовка MPLS.

Каждый транзитный P тоже обрабатывает пакеты на основе верхнего EXP. Но при этом он может его поменять, если того хочет оператор.

Предпоследний узел снимает транспортную метку (PHP) и копирует значение EXP в VPN-заголовок. Не важно, что там стояло — в режиме Uniform, происходит копирование.

Egress PE снимая метку VPN, тоже копирует значение EXP в IP DSCP, даже если там записано другое.

То есть если где-то в середине значение метки EXP в туннельном заголовке изменилось, то это изменение будет унаследовано IP-пакетом.

Pipe Mode

Если же на Ingress PE мы решили не доверять значению DSCP, то в заголовки MPLS вставляется то значение EXP, которое пожелает оператор.

Но допустимо и копировать те, что были в DSCP. Например, можно переопределять значения — копировать всё, вплоть до EF, а CS6 и CS7 маппировать в EF.

Каждый транзитный P смотрит только на EXP верхнего MPLS-заголовка.

Предпоследний узел снимает транспортную метку (PHP) и копирует значение EXP в заголовок VPN.

Egress PE сначала производит обработку пакета, опираясь на поле EXP в заголовке MPLS, и только потом его снимает, при этом не копирует значение в DSCP.

То есть независимо от того, что происходило с полем EXP в заголовках MPLS, IP DSCP остаётся неизменным.

Такой сценарий можно применять, когда у оператора свой домен Diff-Serv, и он не хочет, чтобы клиентский трафик как-то мог на него влиять.

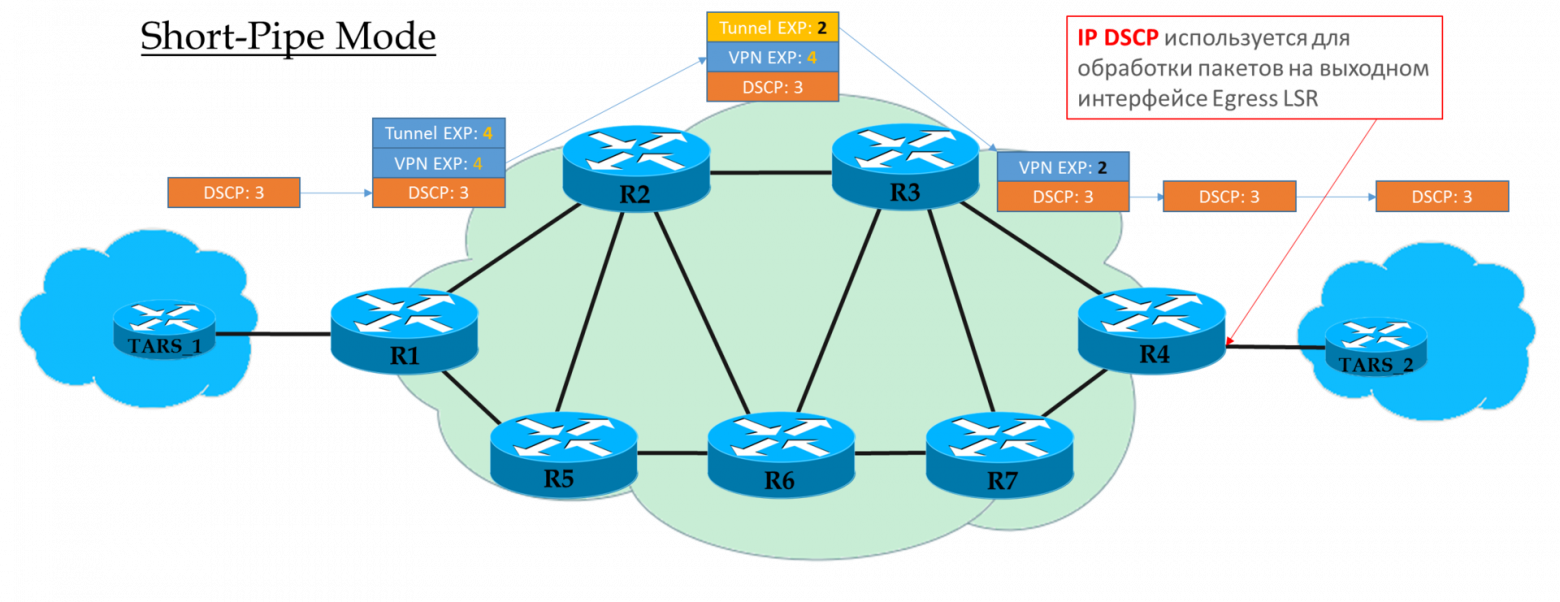

Short-Pipe Mode

Этот режим вы можете рассматривать вариацией Pipe-mode. Разница лишь в том, что на выходе из MPLS-сети пакет обрабатывается в соответствие с его полем IP DSCP, а не MPLS EXP.

Это означает, что приоритет пакета на выходе определяется клиентом, а не оператором.

Ingress PE не доверяет IP DSCP входящих пакетов

Транзитные P смотрят в поле EXP верхнего заголовка.

Предпоследний P снимает транспортную метку и копирует значение в VPN-метку.

Egress PE сначала снимает метку MPLS, потом обрабатывает пакет в очередях.

Объяснение от cisco.

Практика классификации MPLS Traffic Class

Схема та же:

Файл конфигурации тот же.

В схеме сети linkmeup есть переход из IP в MPLS на Linkmeup_R2.

Посмотрим, что происходит с маркировкой при пинге ping ip 172.16.2.2 source 172.16.1.1 tos 184.

Linkmeup_R2. E0/0.

pcapng

Итак, мы видим, что изначальная метка EF в IP DSCP трансформировалась в значение 5 поля EXP MPLS (оно же Traffic Class, помним это) как VPN-заголовка, так и транспортного.

Тут мы являемся свидетелями режима работы Uniform.

Ethernet 802.1p

Отсутствие поля приоритета в 802.3 (Ethernet) находит своё объяснение в том, что Ethernet изначально планировался исключительно как решение для LAN-сегмента. За скромные деньги можно получить избыточную пропускную способность, и узким местом всегда будет аплинк — не за чем беспокоиться о приоритизации.

Однако очень скоро стало ясно, что финансовая привлекательность Ethernet+IP выводит эту связку на уровень магистрали и WAN. Да и сожительство в одном LAN-сегменте торрентов и телефонии нужно разруливать.

По счастью к этому моменту подоспел 802.1q (VLAN), в котором выделили 3-битовое (опять) поле под приоритеты.

В плане DiffServ это поле позволяет определить те же 8 классов трафика.

При получении пакета сетевое устройство DS-домена в большинстве случаев берёт в рассмотрение тот заголовок, который оно использует для коммутации:

- Ethernet-коммутатор — 802.1p

- MPLS-узел — MPLS Traffic Class

- IP-маршрутизатор — IP DSCP

Хотя это поведение можно и изменить: Interface-Based и Multi-Field классификация. А можно иногда даже явно сказать, в поле CoS какого заголовка смотреть.

Interface-based

Это наиболее простой способ классифицировать пакеты в лоб. Всё, что насыпалось в указанный интерфейс, помечается определённым классом.

В некоторых случаях такой гранулярности хватает, поэтому Interface-based находит применение в жизни.

Практика по Interface-based классификации

Схема та же:

Настройка политик QoS в оборудовании большинства вендоров делится на этапы.

- Сначала определяется классификатор:

class-map match-all TRISOLARANS_INTERFACE_CM

match input-interface Ethernet0/2

Всё, что приходит на интерфейс Ethernet0/2. - Далее создаётся политика, где связываются классификатор и необходимое действие.

policy-map TRISOLARANS_REMARK class TRISOLARANS_INTERFACE_CM set ip dscp cs7Если пакет удовлетворяет классификатору TRISOLARANS_INTERFACE_CM, записать в поле DSCP значение CS7.

Здесь я забегаю вперёд, используя непонятные CS7, а далее EF, AF. Ниже можно прочитать про эти аббревиатуры и принятые договорённости. Пока же достаточно знать, что это разные классы с разным уровнем сервиса.

- И последним шагом применить политику на интерфейс:

interface Ethernet0/2 service-policy input TRISOLARANS_REMARKЗдесь немного избыточен классификатор, который проверят что пакет пришёл на интерфейс e0/2, куда мы потом и применяем политику. Можно было бы написать match any:

class-map match-all TRISOLARANS_INTERFACE_CM match anyОднако политика на самом деле может быть применена на vlanif или на выходной интерфейс, поэтому можно.

Пускаем обычный пинг на 172.16.2.2 (Trisolaran2) с Trisolaran1:

И в дампе между Linkmeup_R1 и Linkmeup_R2 увидим следующее:

pcapng

Файл конфигурации Interface-Based классификации.

Multi-Field

Наиболее часто встречающийся тип классификации на входе в DS-домен. Не доверяем имеющейся маркировке, а на основе заголовков пакета присваиваем класс.

Зачастую это способ вообще «включить» QoS, в случае, когда отправители не проставляют маркировку.

Достаточно гибкий инструмент, но в то же время громоздкий — нужно создавать непростые правила для каждого класса. Поэтому внутри DS-домена актуальнее BA.

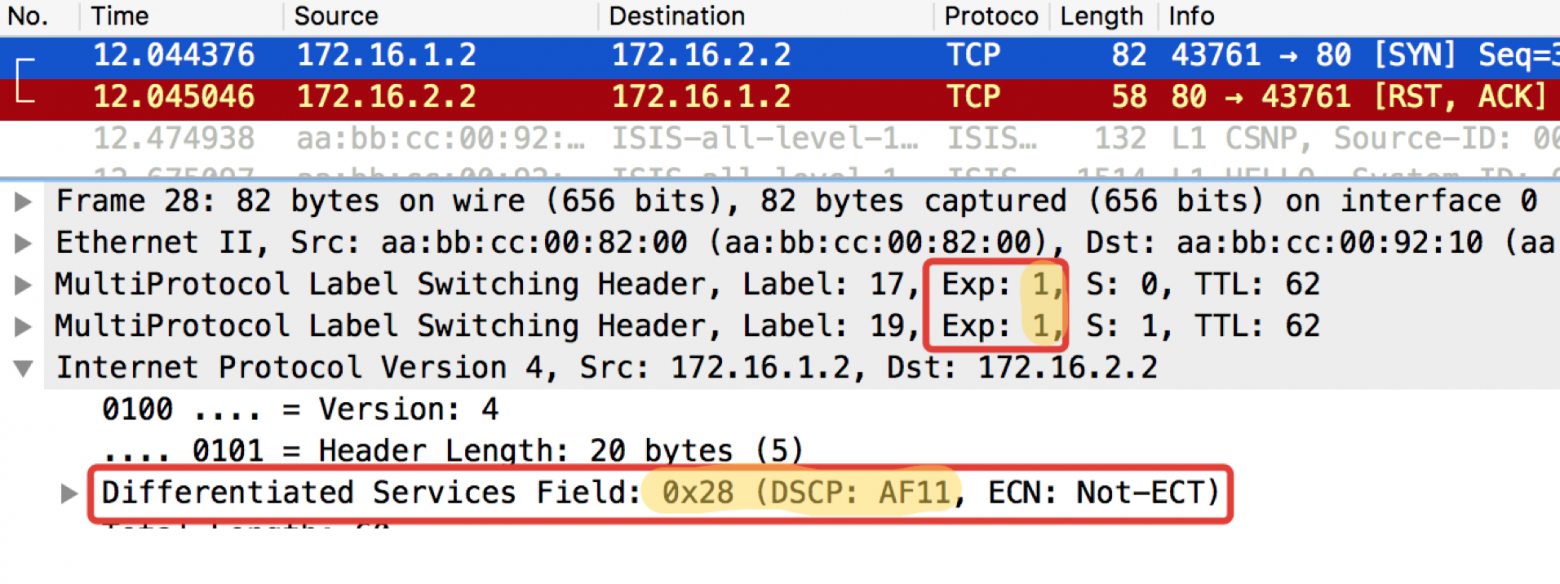

Практика по MF классификации

Схема та же:

Из практических примеров выше видно, что устройства сети по умолчанию доверяют маркировке приходящих пакетов.

Это прекрасно внутри DS-домена, но неприемлемо в точке входа.

А давайте теперь не будем слепо доверять? На Linkmeup_R2 ICMP будем метить как EF (исключительно для примера), TCP как AF12, а всё остальное CS0.

Это будет MF (Multi-Field) классификация.