В версиях Windows Server, предшествующих Windows Server 2016, создать отказоустойчивый кластер из нескольких серверов можно было только между серверами одного домена Active Directory. В новой версии теперь можно создавать двух (и более) узловой failover кластер между серверами в разных доменах, и даже между серверами рабочей группы (вообще без домена Active Directory).

Естественно, что на всех узлах кластера нужно устаровить Windows Server 2016. Поддерживаются следующие сценарии кластеризации:

| Служба | Статус | Комментарий |

| SQL server | Поддерживается | Рекомендуется использовать встроенную аутентификацию SQL Server |

| Файловый сервер | Поддерживается, но не рекомендуется | Не поддерживается Kerberos-аутентфикация для SMB |

| Hyper-V | Поддерживается, но не рекомендуется | Не поддерживается режим Live Migration, доступна только Quick migration |

| Message Queuing (MSMQ) | Не поддерживается | MSMQ хранит свои свойства в Active Directory. |

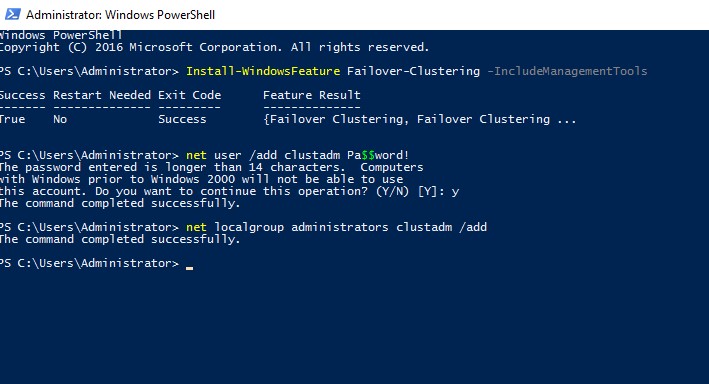

На всех будущих узлах кластера нужно

- Установить роль Failover Clustering:

Install-WindowsFeature Failover-Clustering –IncludeManagementTools - На каждой кластерной ноде нужно создать локальную учетную запись с правами администратора (или использовать встроенную учетку администратора) с одинаковыми паролями.

net user /add clustadm Pa$$word!

net localgroup administrators clustadm /add

- При появлении ошибки Requested Registry access is not allowed, необходимо изменить в реестре параметр удаленного UAC — Данный ключ разрешает удаленный доступ к административным шарам.

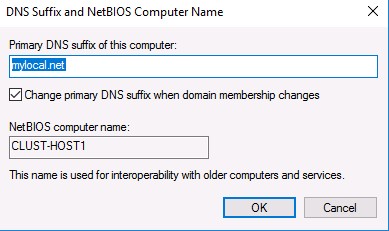

New-ItemProperty -Path HKLM:\SOFTWARE\Microsoft\Windows\CurrentVersion\Policies\System -Name LocalAccountTokenFilterPolicy -Value 1 - На всех узлах кластера нужно задать одинаковой первичный DNS суффикс (Primary DNS suffix). Это нужно для того, чтобы сервера кластера могли обращаться друг к другу по FQDN именам

- Также нужно снять галку Register DNS connection addresses

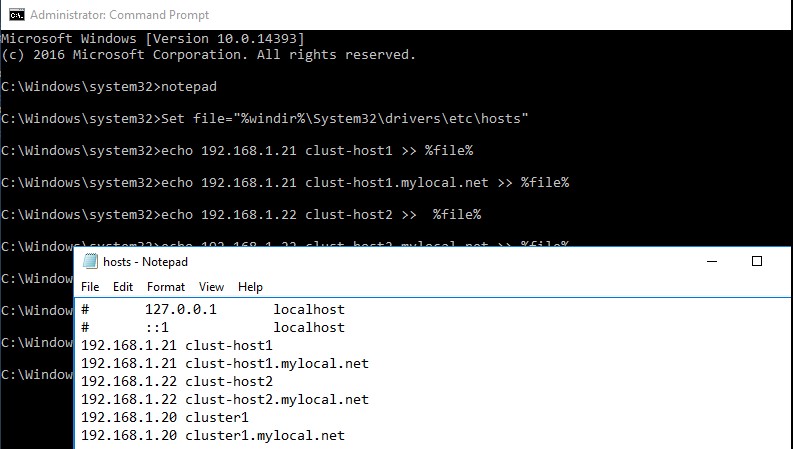

- В файл hosts на всех узлах кластера нужно внести изменения, чтобы сервера могли отрезолвить имена других членов кластера, а также имя кластера (в том числе FQDN имена). Добавить имена в файл c:\windows\system32\drivers\etc\hosts можно так:

Set file="%windir%\System32\drivers\etc\hosts"

echo 192.168.1.21 clust-host1 >> %file%

echo 192.168.1.21 clust-host1.mylocal.net >> %file%

echo 192.168.1.22 clust-host2 >> %file%

echo 192.168.1.22 clust-host2.mylocal.net >> %file%

echo 192.168.1.20 cluster1 >> %file%

echo 192.168.1.20 cluster1.mylocal.net>> %file%

Для предварительной валидации узлов кластера можно воспользоваться командой:

test-cluster -node "clust-host1.mylocal.net"," clust-host2.mylocal.net"

Для создания кластера через PowerShell, нужно выполнить такую команду:

New-Cluster -Name cluster1 -Node clust-host1.mylocal.net, clust-host2.mylocal.net -AdministrativeAccessPoint DNS -StaticAddress 192.168.1.20

Теперь можно проверить статус кластера и его компонентов командлетами get-cluster и get-clusterresource.

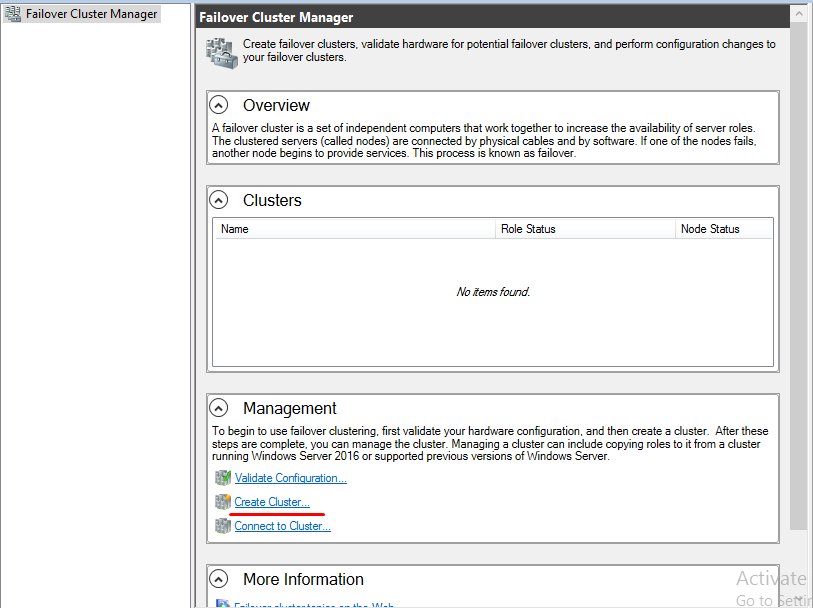

Для подключения (и удаленного управления) кластером через GUI нужно воспользоваться оснасткой Failover Cluster Manager (входит в состав) RSAT для Windows 10.

Теперь с помощью пункта меню Connect to cluster можно подключаться к созданному кластеру. В том случае, если в кластере четное количество серверов, придется настроить ресурс-свидетель. Отметим, что в качестве кворумного свидетеля нельзя использовать сетевую папку SMB. Поддерживается режим Disk Witness — общий диск (с одновременным доступом к нему с обоих узлов), либо Cloud Witness — облачный дисковый ресурс в Azure.

В этой небольшой инструкции мы покажем пошагово как создать простой отказоустойчивый кластер Hyper-V Cluster из двух серверов с Windows Server 2016. Такой кластер позволяет без особых проблем организовать отказоустойчивость для виртуальных машин Hyper-V при аппаратных проблемах с одним из серверов.

- Предварительные требования к отказоустойчивому кластеру Hyper-V

- Настройки сети Hyper V

- Установка кластера Hyper-V

- Настройка кластера Hyper-V

Содержание:

Предварительные требования к отказоустойчивому кластеру Hyper-V

- Два сервера с установленной ОС Windows Server 2016 (желательно чтобы количество памяти и CPU на обоих серверах было одинаково)

- Установленная роль Hyper-V с компонентами Failover Cluster и MPIO ( iSCSI по необходимости)

- Как минимум по 2 сетевых карты на каждом сервере (одна сетевая карта будет использоваться для управления и через нее будет идти трафик ВМ, вторая – для взаимодействия хостов между собой – трафик CSV и Heartbeat)

- Общее дисковое хранилище, подключенное к обоим серверам (в этом примере дисковый массив подключается к каждому серверу через 2 порта Fiber Channel, при этом компонент MPIO нужен для того, чтобы каждый сервер видел только одно подключение к диску, а не два)

- Как минимум один диск (LUN) с общего хранилища презентован обоим сервера, инициализирован и отформатирован.

Настройки сети Hyper V

В нашем примере мы настроим следующую IP адресацию для компонентов кластера:

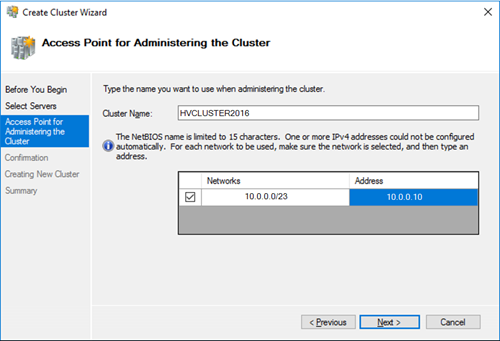

Общее имя кластера: HVCLUSTER2016 (IP адрес 10.0.0.10)

Первый сервер: имя HOST01, с двумя интерфейсами

10.0.0.11 – интерфейс управления, и трафика виртуальных машин

10.0.1.11 – интерфейс для трафика Cluster Shared Volume и Heartbeat

Второй сервер: имя HOST02, с двумя интерфейсами

10.0.0.12 — интерфейс управления, и трафика виртуальных машин

10.0.1.12 – интерфейс для трафика Cluster Shared Volume и Heartbeat

Установка кластера Hyper-V

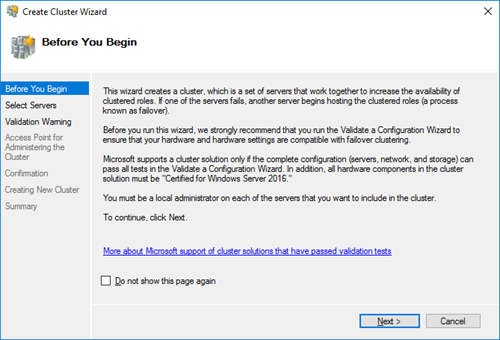

Итак, на любом из серверов запускаем оснастку Failover Cluster Manager и запускаем мастер создания кластера (Create Cluster).

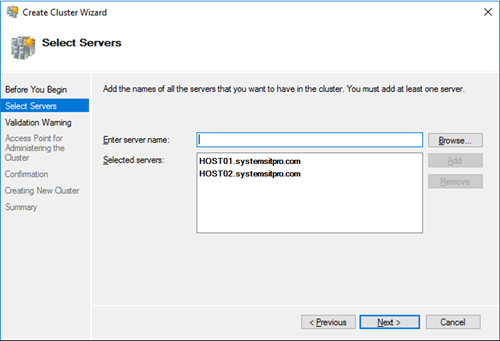

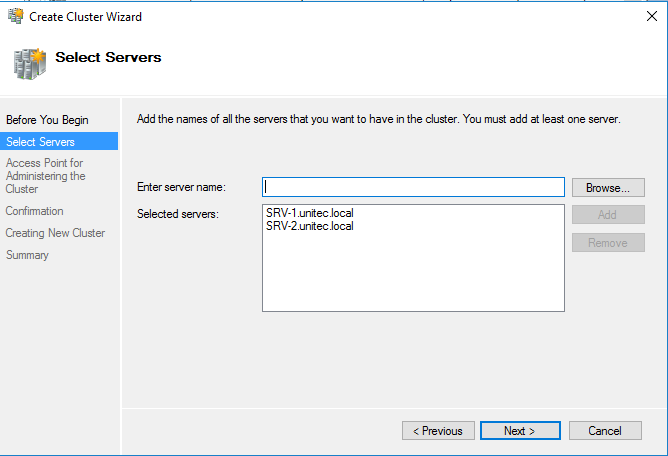

На странице выбора серверов кластера добавляем обе наших ноды.

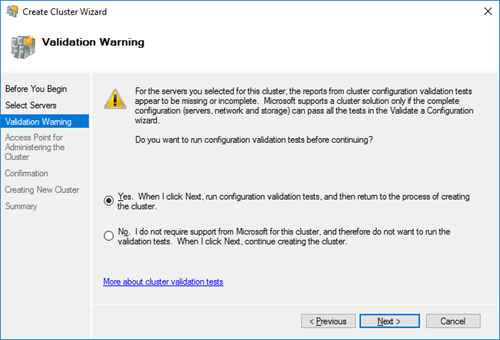

На странице Validation Warning соглашаемся с запуском встроенных тестов валидации кластерной конфигурации.

Выберите, что нужно прогнать все тесты.

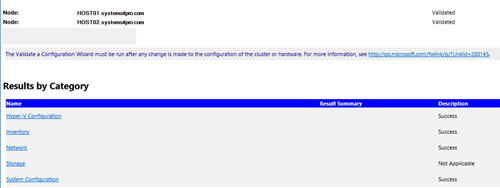

Нужно дождаться окончания валидации. Если будут найдены ошибки – их нужно исправить. После этого нажать на Finish.

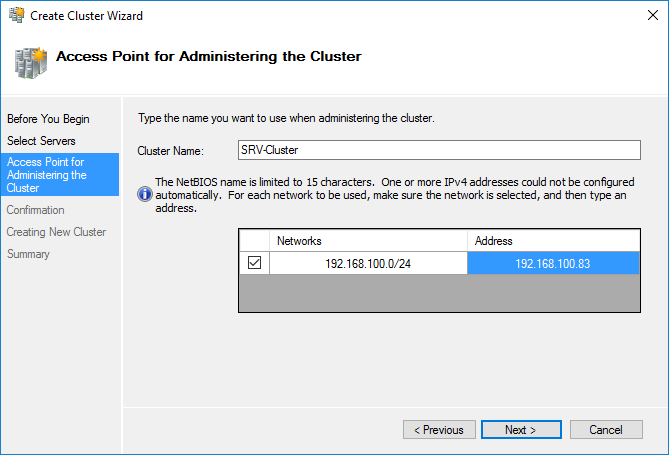

Далее на странице настройки Access Point for Administering the Cluster нужно указать имя кластера и его IP адрес и подсеть.

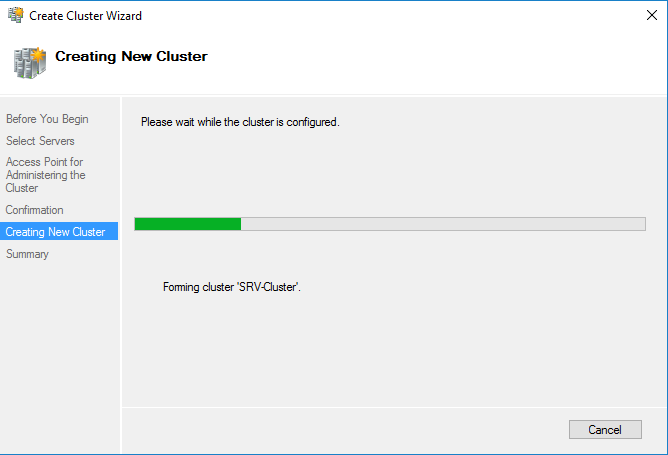

Осталось нажать 2 раза кнопку Next и мастер создаст новый кластер.

Настройка кластера Hyper-V

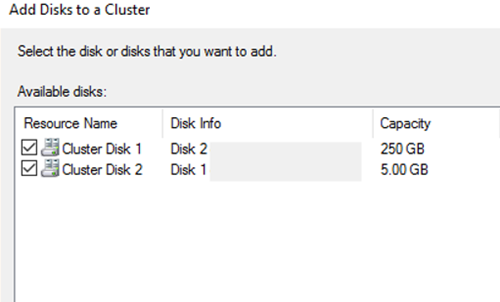

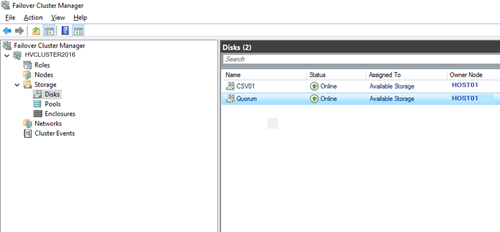

Теперь в кластер нужно добавить диски. Для этого откройте консоль Failover Cluster Management и в разделе Storage -> Disks добавьте общие в кластер общие диски (они должны быть инициализированы и отформатированы)

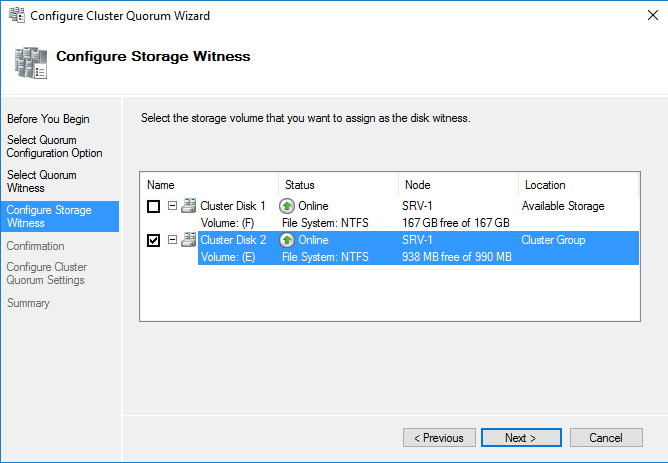

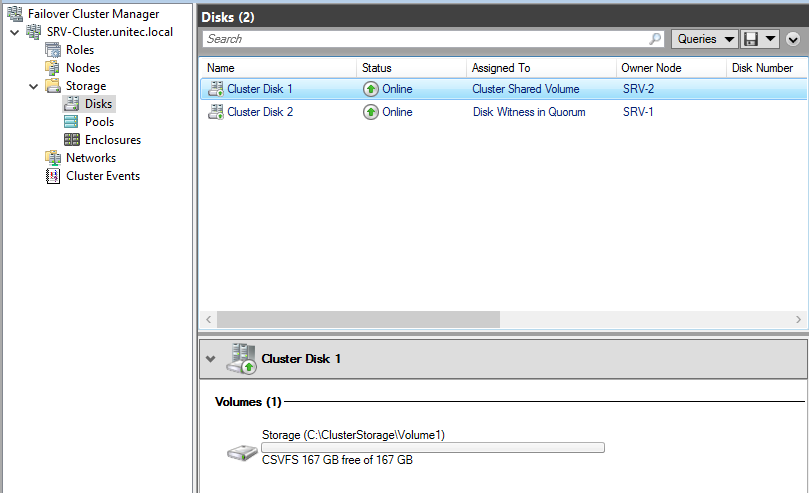

Задайте содержательные имена дискам. В нашем примере один кластерный диск будет использоваться как том Cluster Shared Volumes (CSV) для хранения файлов ВМ, а второй использоваться для кворума (диск небольшого размера).

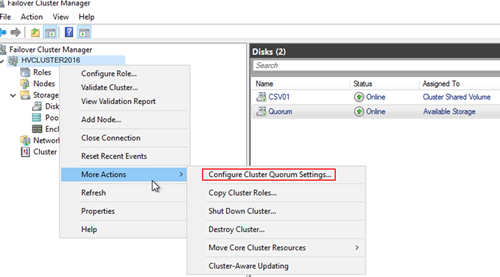

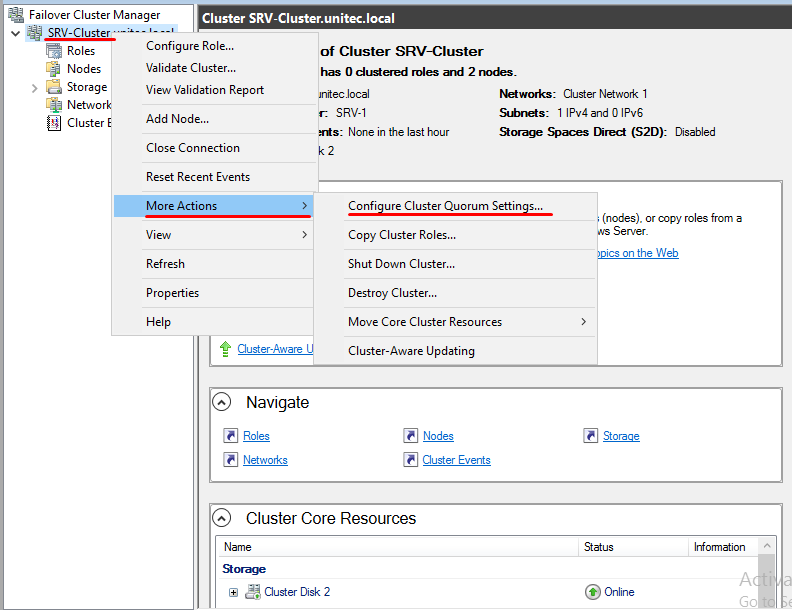

Далее нужно настроить кластерный кворум. Для этого щелкните ПКМ по имени кластера и выберите пункт меню More Actions-> Configure Cluster Quorum Settings.

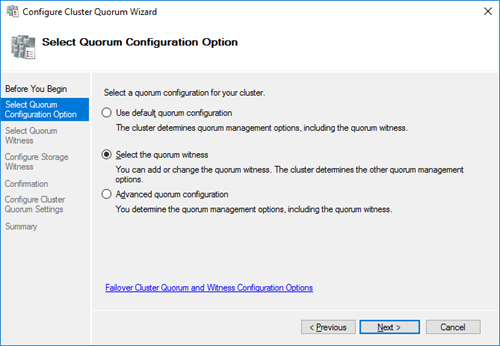

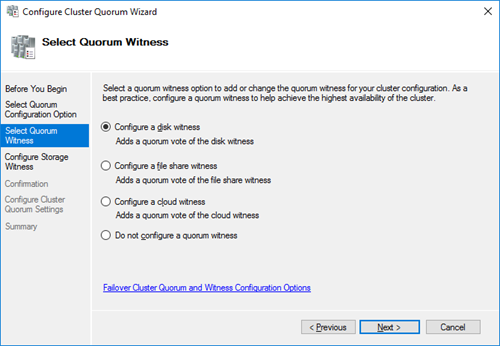

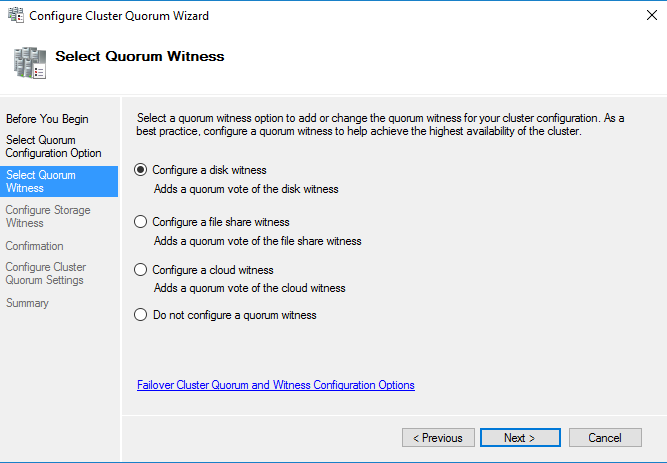

Выберите вариант настройки кворума для кластера Select the quorum witness.

В качестве типа кворума выберите Quorum Witness Select Disk Witness (кворум с использованием диска свидетеля).

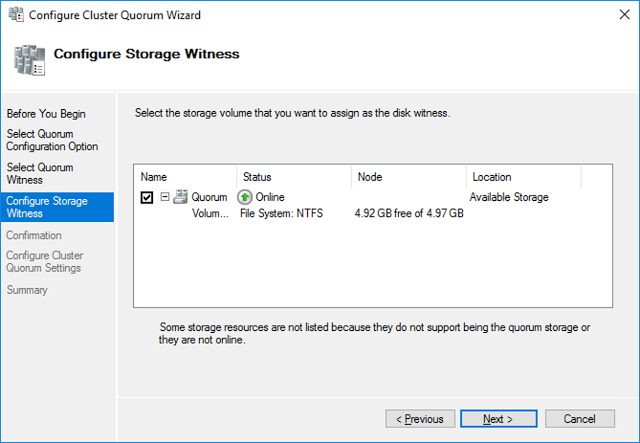

Выберите кластерный диск, который вы хотите использовать в качестве диска-свидетеля.

Теперь в настройках Hyper-V на каждой из нод нужно указать кластерный том CSV в качестве диска по-умолчанию для хранения виртуальных машин.

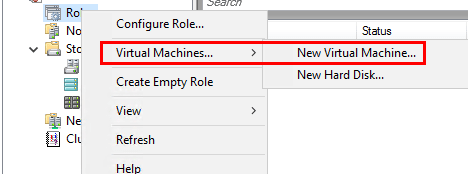

Теперь можно в консоли управления кластером создать новую виртуальную машину: Roles -> Virtual Machines -> New Virtual Machine.

Затем с помощью обычного мастера Hyper-V нужно создать новую виртуальную машину. С помощью Live Migration в дальнейшем можно убедится, что ВМ на легко перемещается между узлами кластера Hyper-V.

Еще немного технических видео на канале… Нет, это видео не про Petya – про защиту от Petya смотрите здесь и читайте статьи здесь на блоге, и не про мониторинг производительность дисков (но обещанное продолжение про производительность тоже следует). Подписывайтесь на мой Youtube канал iWalker2000 – для подписки просто кликните сюда

Хотя это видео про развертывание кластера Windows Server 2016 и получилось слегка длинным – но, на мой взгляд – удачным – тут и использование тиминга (NIC Teaming) сетевых интерфейсов для ускорения дисковых операций, и подключение к сетевым дискам iSCSI для общего хранилища кластера, и проблемы с правильным определением кластеров “нужных” сетевых интерфейсов с дальнейшим исправлением, и, конечно же – создание собственно отказоустойчивых ролей в кластере – таких, как высокопроизводительный отказоустойчивый файловый сервер Scale-out File Server и роль виртуальной машины Hyper-V, и вложенная/наследуемая виртуализация (nested virtualization) в Hyper-V, используемая для лабы.

Надеюсь, это видео про основные шаги при развертывании отказоустойчивого кластера Windows Server 2016 Failover Cluster будет полезным для тех, кому “вот прямо срочно” требуется развернуть кластер на Windows Server 2016 и запустить в нем те или иные роли.

СофТы: как развернуть и настроить кластер Windows Server 2016 Failover Clustering, ч.01

Но я пообещал более подробно (кроме собственно, развертывания кластера) раскрыть эту тему – поэтому в следующем “длинном” видео смотрите более подробно про настройки параметров ролей в кластере, а также – о создании гостевого кластера (кластера внутри кластера) для еще более бесперебойной работы и высокой доступности приложений.

И немного о вирусе Petya и украинской “эпидемии”

Продолжение темы про отказоустойчивые кластеры Windows Server 2016 – на этот раз про настройки собственно отказоустойчивости и высокой доступности. А предыдущее видео – про установку и начальную настройку самого кластера Windows Server 2016 Failover Clustering – смотрите тут.

В этом видео про настройку ролей в отказоустойчивом кластере Windows Server 2016 Failover Clustering вы найдете:

-

как работает отказоустойчивость и высокая доступность в кластере Windows для “обычного” приложение – настройка количества сбоев, перезапуск/”переползание” приложения между узлами кластера, остановка приложения.

-

работа приложений, поддерживающих распределенный режим работы и позволяющий им работать на всех (нескольких) узлах кластера одновременно – на примере Scale-Out File Server.

-

Работа отказоустойчивой виртуальной машины Hyper-V в кластере.

-

Настройка параметров восстановления роли кластера в случае сбоя одного из узлов кластера – возврат роли на оригинальны узел после восстановления работоспособности роли, настройка общих приоритетов работы роли и преференций по работе роли на разных узлах кластера Windows Server 2016.

-

Настройка мониторинга отдельного сервиса внутри роли виртуальной машины кластера Hyper-V для мониторинга состояния отдельных процессов ВМ и ее общего здоровья, запущенной в кластере.

-

И, конечно же, демонстрация “падения” одно из узлов кластера Windows Server 2016 и реакция на это событие разных типов ролей – подолжение процесса копирования файлов на Scale-out File Server, старт общей роли на втором узле кластера, и перезапуск виртуальной машины, которая “обрушилась” при падении узла кластера.

Смотрим, учимся, разбираемся и планируем отказоустойчивую работу и высокую доступность необходимых приложений под управлением Windows Server 2016 Failover Clustering.

СофТы: настройка отказоустойчивых ролей в кластере Windows Server 2016 Failover Clustering, ч.02

В продолжение темы про отказоустойчивые кластеры Windows Server 2016 – в следующем видео смотрите про создание гостевого кластера из виртуальных машин Hyper-V внутри основного (физического) кластера Windows Server 2016. Зачем? чтобы гарантировать еще более высокую доступность и надежность приложения, запущенного на виртуальной машине в кластере (которое будет тоже в кластере). Так что улучшается доступность чуть ли не на порядок 😉

Видео об ИТ-карьере – как стать ИТ-специалистом и заработать много денег:

Заключительное видео в серии по теме отказоустойчивого кластера Windows Server 2016 – создание гостевого кластера из виртуальных машин внутри основного кластера – такая себе фукурума 😉

Особенностью данного видео и основным отличием от первого видео – просто развертывания кластера Windows Server 2016 – в том, что гостевой кластер создается не просто так, а в режиме “Active Directory-Detached Cluster” – отключенного от Active Directory кластера Windows.

СофТы: установка гостевого Hyper-V кластера Windows Server 2016 без Active Directory, ч.03

Подробную инструкцию по развертыванию гостевого кластера Windows Server 2016 без Active Directory вы найдете в этом видео, а основные шаги по развертыванию такого отключенного от AD кластера Windows приводятся ниже:

-

все узлы кластера должны быть зарегистрированы в каком-то из доменов (зон) DNS – для этого необходимо, чтобы DNS сервер поддерживал динамические обновления, суффиксы требуемого домена были прописаны в настройках серверов, а в настройках сетевых интерфейсов – стояли опции обязательной регистрации имени. Или вам потребуется создавать все записи в DNS зоне для узлов кластера, самого кластера и его ролей ручками.

-

настройки firewall должны разрешать обращаться всем узлам друг к другу.

-

на каждом из узлов будущего кластера должна существовать учетная запись-локальный администратор с общими одинаковым именем и паролем. Также, должен быть отключен сетевой фильтеринг в UAC – тот самый ключ в реестре – New-ItemProperty -Path HKLM:\SOFTWARE\Microsoft\Windows\CurrentVersion\Policies\System -Name LocalAccountTokenFilterPolicy -Value 1

ВНИМАНИЕ! Помните, что такой кластер представляет собой потенциальную жертву для атак типа pth/ptt – которые использует тот же Petya и другие вирусы (и просто хакеры). Поэтому смотрите видео про защиту от подобных атак Pass-the-Hash/Pass-the-ticket и, конечно же, читайте статью, посвященную стратегии защиты ИТ-инфраструктуры Defense-in-Depth на примере защиты от Petya.

А поскольку мы развертываем гостевой кластер из виртуальных машин и ему требуется также общие диски для своей работы – смотрите в данном видео сценарии, каким образом вы можете создать и где разместить такие диски в виде специальны общих виртуальных дисков Hyper-V (Shared Disk – VHDX или VHD Set). И, пожалуйста, не монтируйте диски гостевого кластера на те же LUN SAN/iSCSI, которые уже используются “большим” основным кластером – это приведет к катастрофическим последствиям для обеих систем.

Думаю, что все 3 инструкции по кластерам Windows Server 2016 помогут вам освоиться с базовыми аспектами работы с отказоустойчивыми кластерами Windows Server 2016 и их вариациями – гостевым кластером из виртуальных машин Hyper-V и кластером Windows без использования Активного Каталога.

Поэтому данную тему будем пока считать закрытой… Хотя есть масса нюансов в обслуживании повседневном кластеров и, конечно же, есть команды PowerShell, которые позволят намного быстрее и гибче развертывать и управлять кластерами Windows… Но это тема уже другой серии видео про кластеры Windows Server 2016.

А в продолжении технических видео на канале – все та же производительность дисков – измерение скорости работы и ускорение дисковой системы.

Подписывайтесь на мой Youtube канал iWalker2000 – для подписки просто кликните сюда

Немного ссылок на другие материалы для тех, кто хочет стать просто ИТ-специалистом – смотрите первые шаги по созданию тестового рабочего места:

И смотрите другие видео для ИТ-специалистов у меня на канале:

Видео про новые возможности дисков и дисковых массивов:

Также, по просьбам посетителей – меня найти можно (добавляйтесь в друзья и подписчики):

В данной статье мы опишем развертывания кластера Hyper-V, на операционной системой ОС Windows 2016.

В примере рассмотрим вариант с двумя серверами, два сервера с ролью Hyper-V и один iSCSI.

Серверам кластера даем имена SRV-1 и SRV-2, хранилищу — iSCSI Storage.

На SRV-1 и SRV-2 устанавливаем роль Hyper-V и Failover Cluster.

Добавляем роль Hyper-V Добавляем компонент Failover Cluster

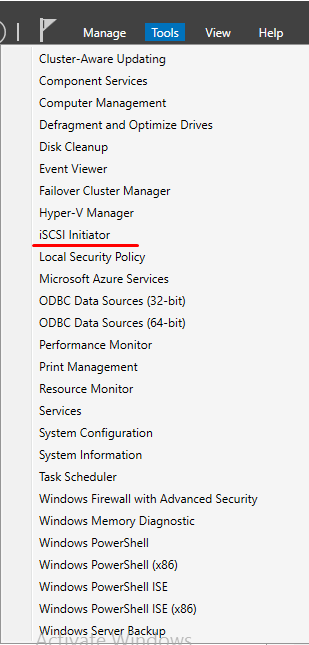

На серверах SRV-1 и SRV-2 запускаем службу iSCSI Initiator.

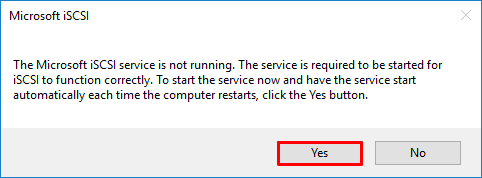

Переходим на сервер iSCSI Storage. Из раздела File and iSCSI Services устанавливаем роль iSCSI Target Server.

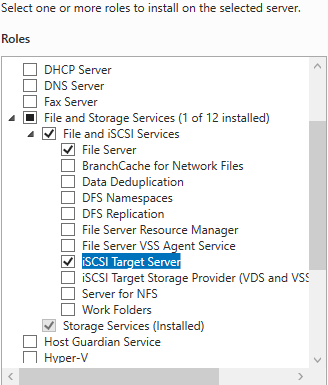

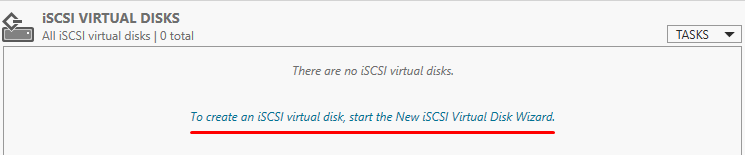

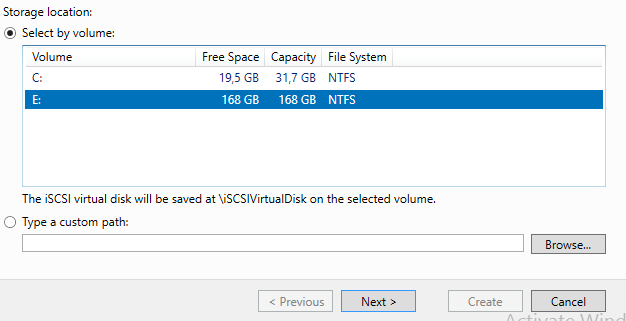

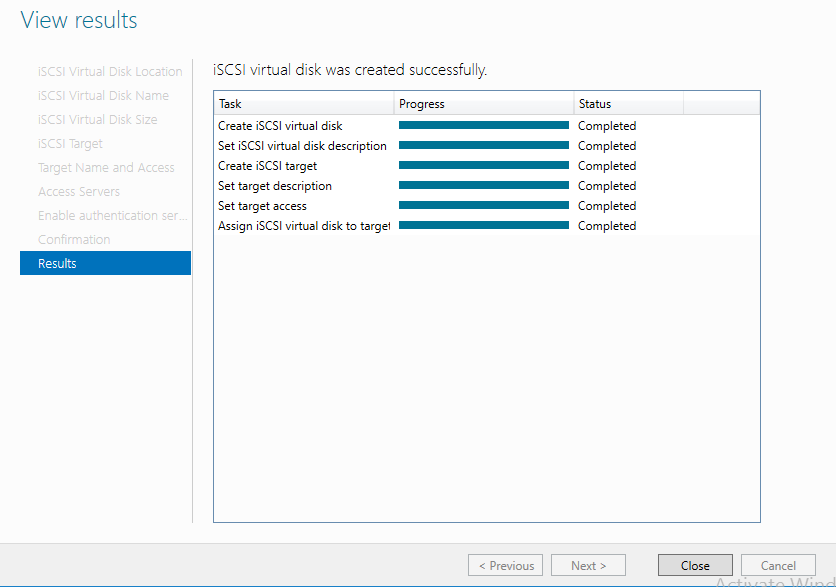

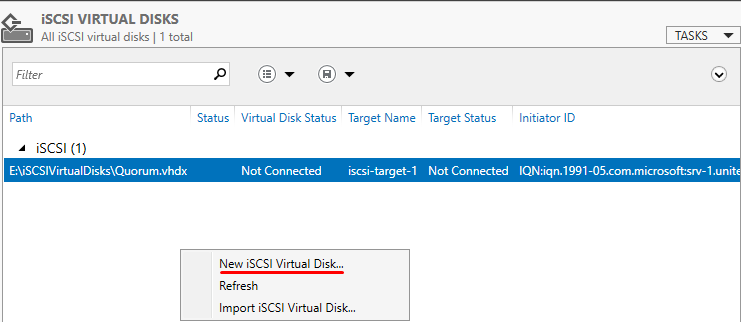

На сервере iSCSI Storage в Server Manager находим iSCSI и создаем 2 виртуальных диска.

Диск свидетеля кворума и диск для хранения виртуальных машин.

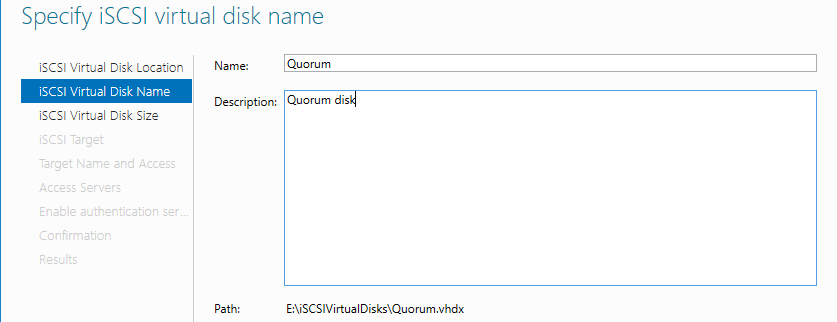

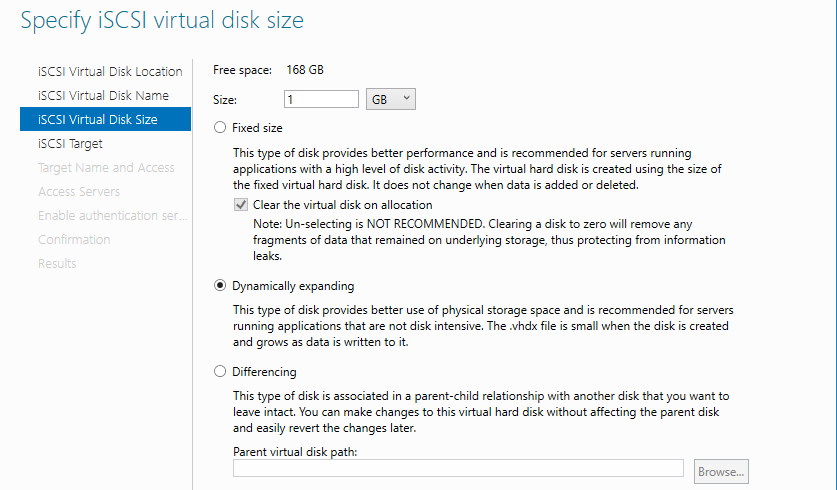

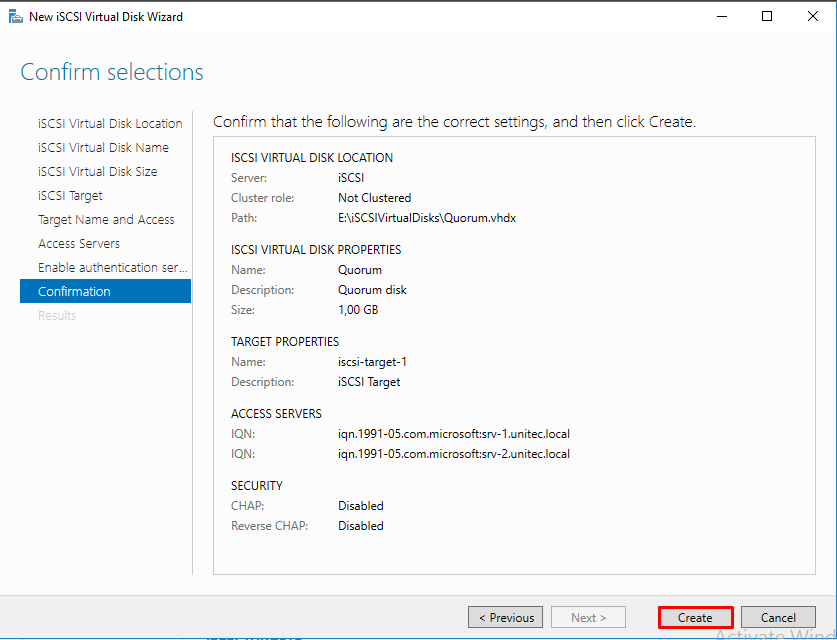

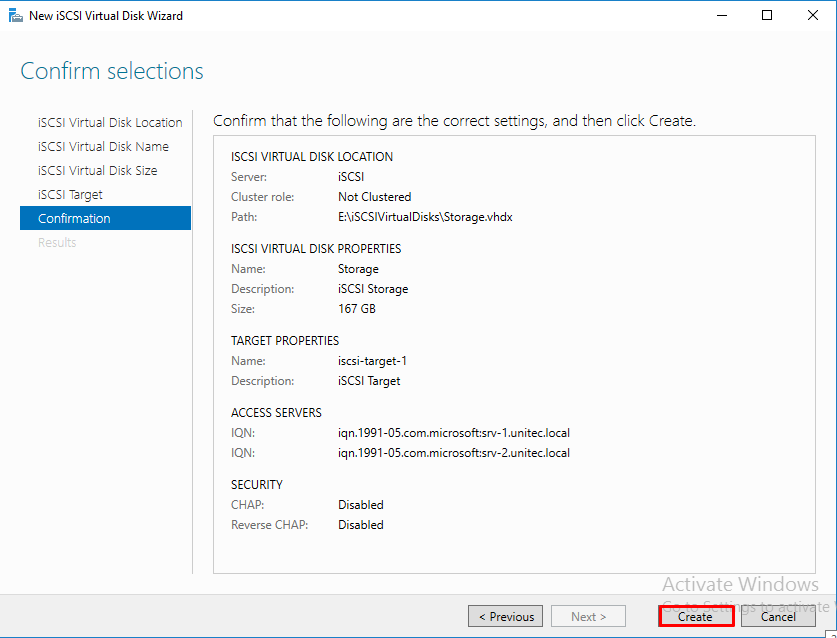

Диск-свидетель — это служебный ресурс кластера, для него достаточно выделить минимальный размер, в нашем случае 1ГБ. Даем ему название Quorum, диску для хранения виртуальных машин даем название — Storage и задаем соответствующий размер.

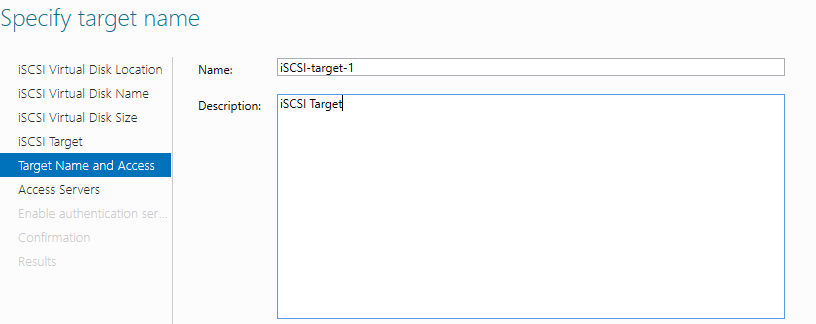

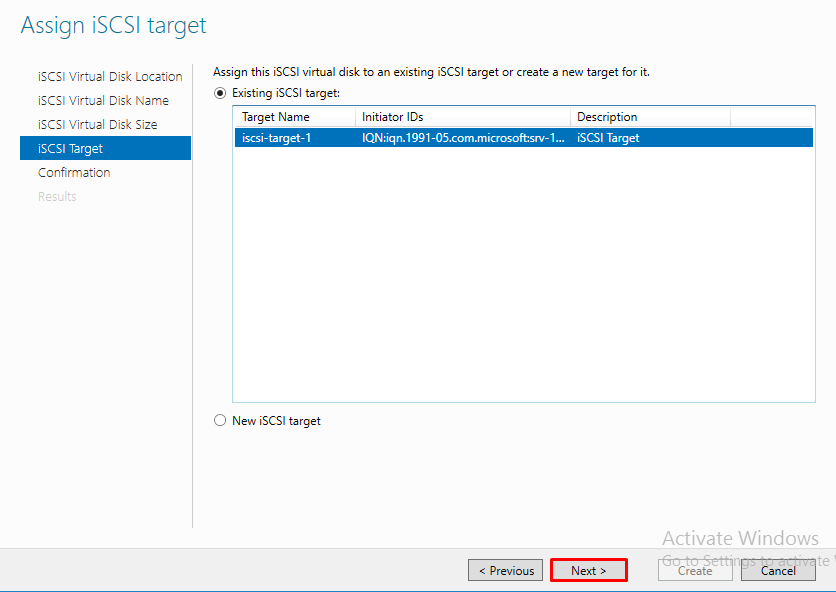

Создаем iSCSI таргет. Задаем имя iSCSI таргета.

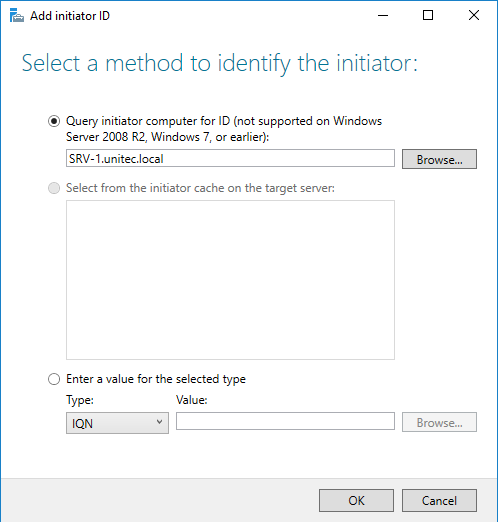

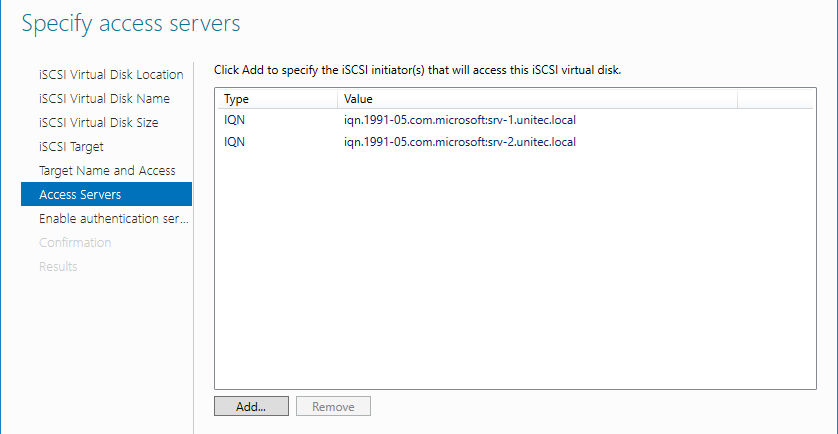

Добавляем сервера, которые могут подключаться к этим дискам (iSCSI инициаторы).

CHAP пропускаем.

Следующим шагом, создаем второй диск, называем его Storage и подключаем к уже созданному iSCSI таргет.

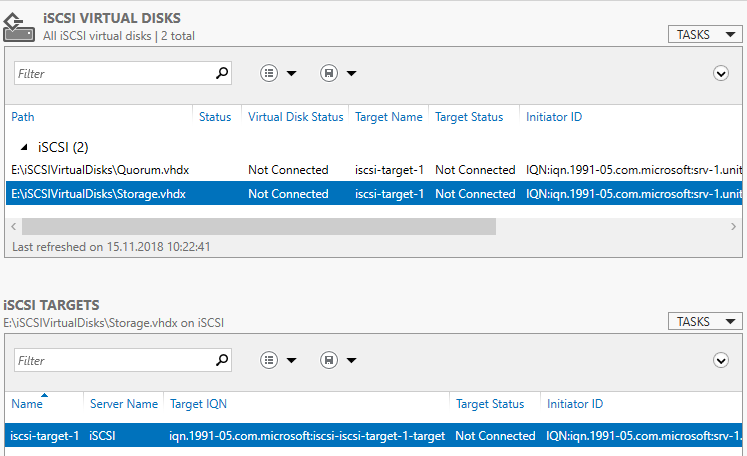

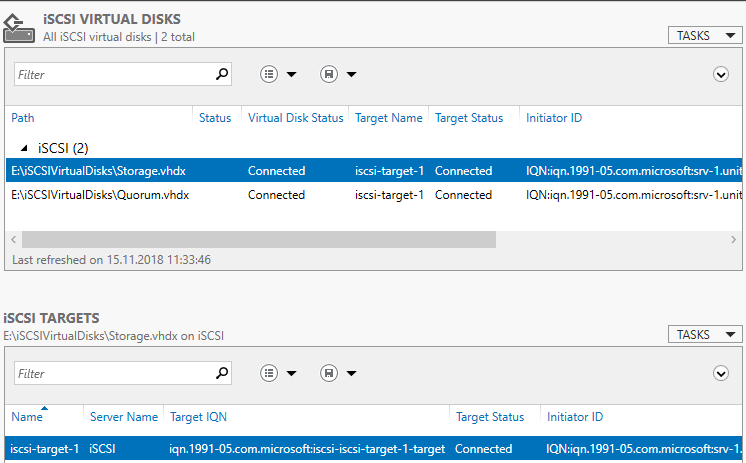

В Server Manager мы видим созданный таргет и инициаторы, но диски пока не подключены.

Возвращаемся на сервера SRV-1 и SRV-2.

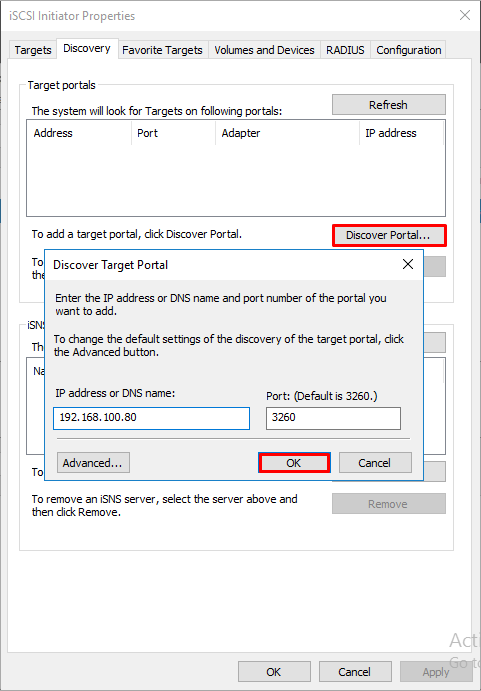

Запускаем оснастку iSCSI Initiator. Добавляем таргет и подключаемся к нему.

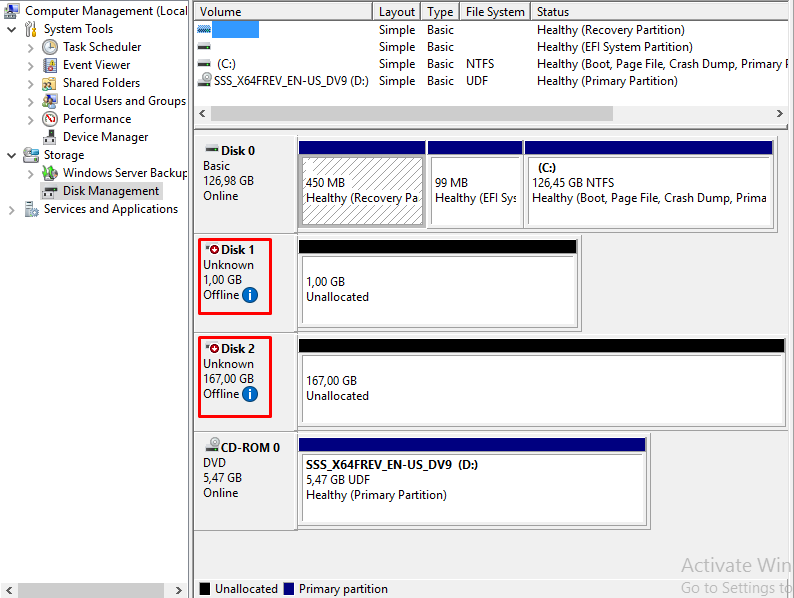

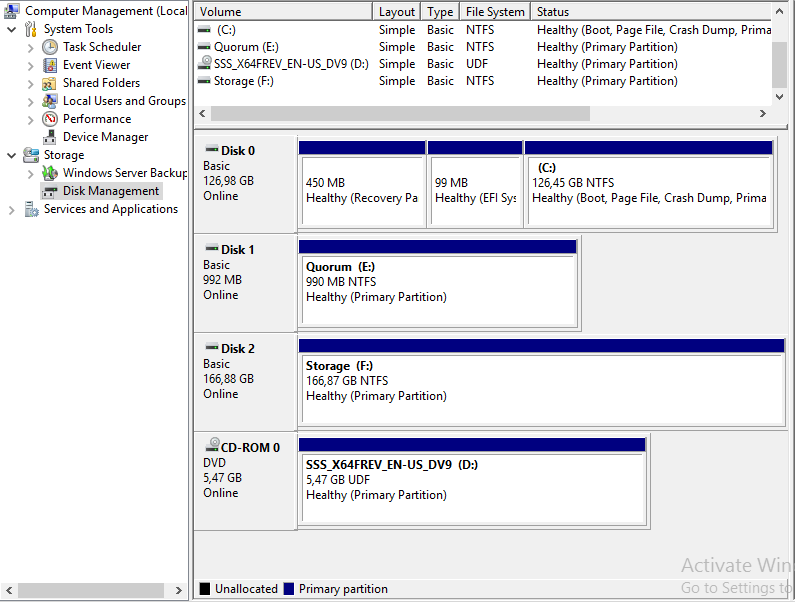

В Disk Management мы видим 2 новых диска. Инициализируем и форматируем новые диски. На втором сервере форматирование не нужно, только инициализация.

Здесь вернемся на сервер iSCSI Storage и убедимся, что все подключено.

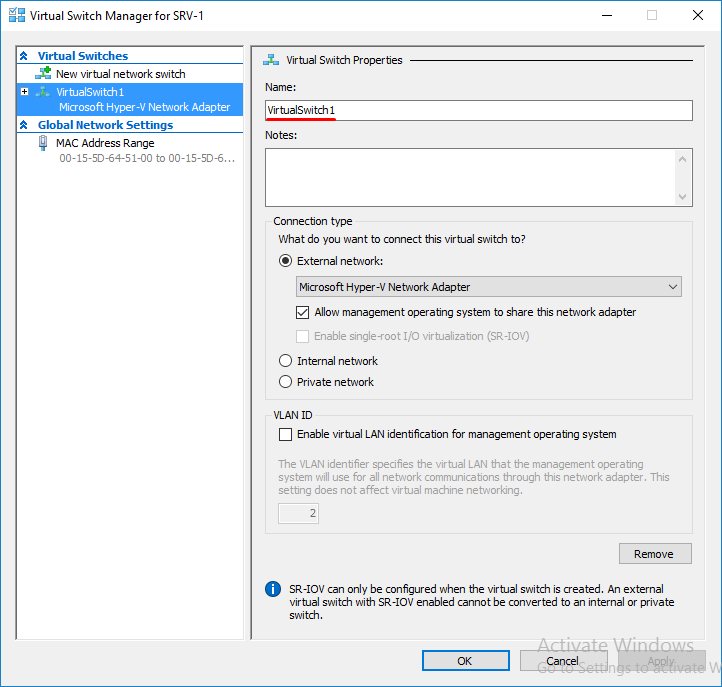

Переходим в диспетчер Hyper-V на серверах SRV-1 и SRV-2 и настраиваем виртуальный коммутатор. Обязательно даем одинаковое название коммутаторам на обоих серверах.

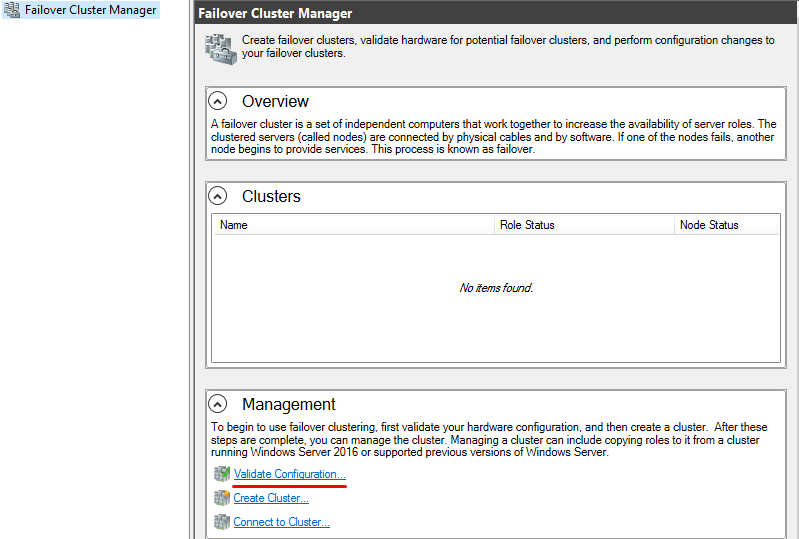

Открываем оснастку Failover Cluster Manager и приступаем к созданию кластера.

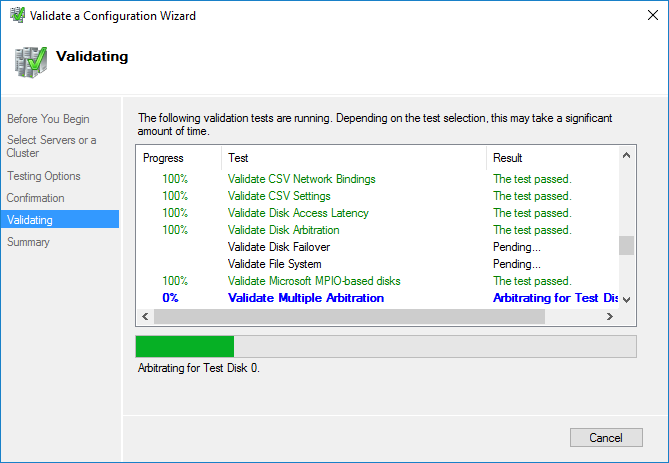

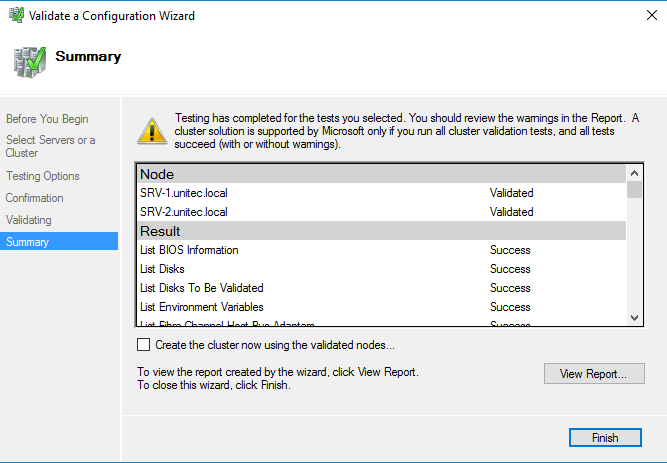

Вначале запускаем проверку. Если проверка не выдала ошибок, создаем кластер.

После проверки создаем кластер. При создании кластера для него создается виртуальный объект, которому даем имя и IP-адрес. В AD в том же OU, в котором находятся сервера появится новая машина.

Добавляем диски.

В Failover Cluster Manager переходим в Storage -> Disk -> справа выбираем add Disk и добавляем диски.

Далее указываем Disk Quorum (диск-свидетель)

И добавляем Disk Storage в общие тома кластера.

Для того, чтобы диск мог использоваться сразу несколькими участниками кластера на нем создается CSVFS — реализуемая поверх NTFS кластерная файловая система. Общие хранилища становятся доступны на всех узлах кластера на C:\ClusterStorage\VolumeN

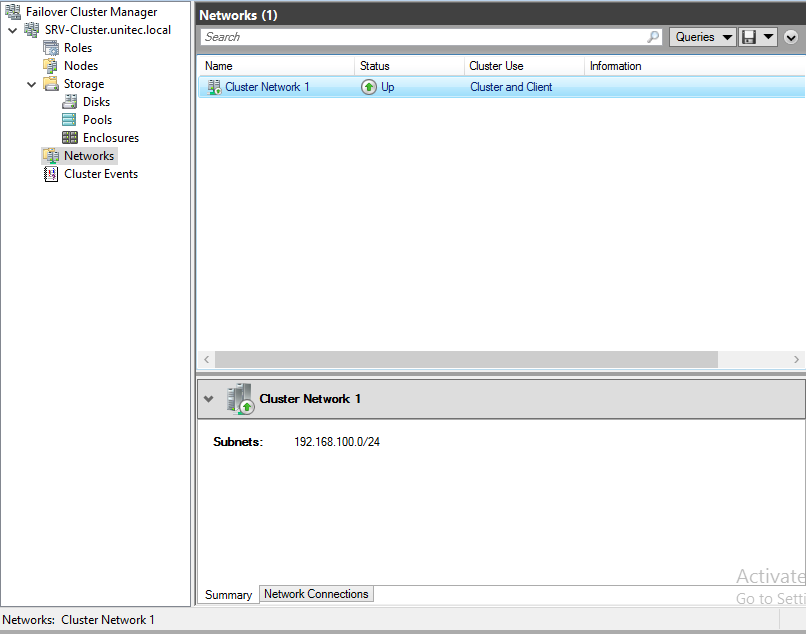

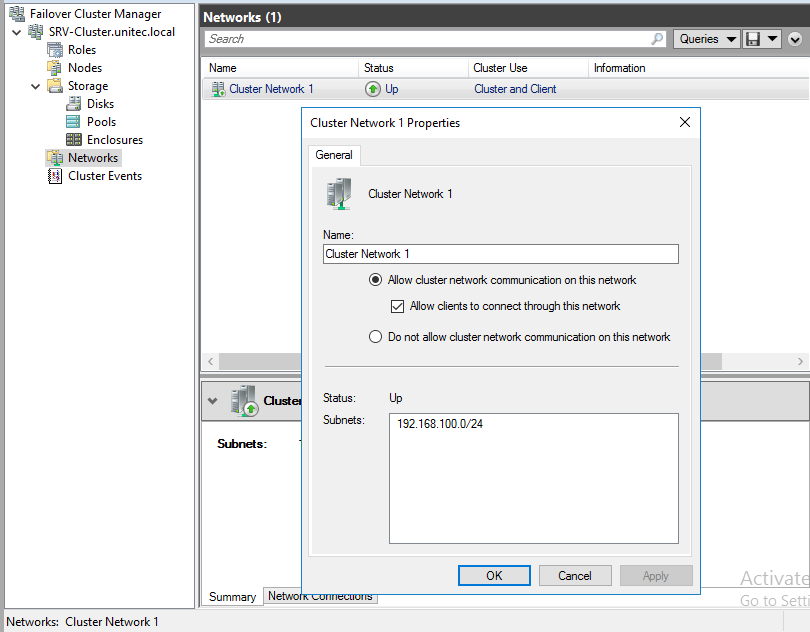

Настраиваем сеть

Перейдем к настройкам сети, для этого перейдем в раздел Networks. Для сети, которая подключена к сети предприятия указываем Разрешить кластеру использовать эту сеть и Разрешить клиентам подключаться через эту сеть. Для сети хранения данных просто оставим Разрешить кластеру использовать эту сеть, таким образом обеспечив необходимую избыточность сетевых соединений.

На этом настройка кластера окончена.

Теперь все виртуальные машины должны создаваться не в диспетчере Hyper-V, а в Failover Cluster Manager. Для создания новой машины заходим в Roles -> Virtual Machines -> New Virtual Machine. Выбираем узел, на котором будет находится машина.

В качестве расположения виртуальной машины обязательно укажите один из общих томов кластера C:\ClusterStorage\VolumeN.

В параметрах машины Automatic Start Action указываем Automatically Start и задержку старта, что бы избежать перегрузки системы.

В свойствах виртуальной машины (Properties) указываем предпочтительные узлы, в порядке убывания и настраиваем Failover (обработку отказов и восстановление размещения).

На этом настройка виртуальной машины закончена.

Проверяем миграцию виртуальной машины

Move -> Live Migration -> выбираем ноду.

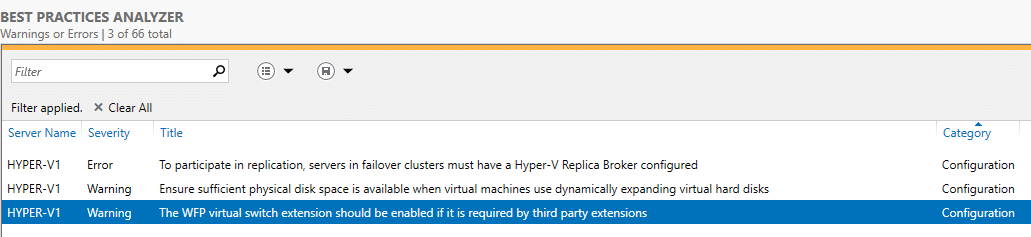

Проанализируем созданный кластер с

BPA (Best Practices Analyzer, Анализатором наилучших решений).

Переходим в Server Manager -> Hyper-V -> справа Tasks -> Start BPA Scan.

Вот что показал мне тест.

По первому пункту — у меня нет необходимости в создании реплики.

По второму пункту — считаю, что машины с динамическими дисками экономят место на диске и состояние диска с виртуальными машинами всегда можно посмотреть и предусмотреть расширение.

По третьему пункту — Расширение виртуального коммутатора WFP должно быть включено, если оно требуется сторонними расширениями.

Прочитано:

7 939

Итак, в наличии есть три физических сервера которые должны быть объединены в единый кластер для минимизации простоя сервисов.

Предварительные действия

Шаг №1: На все физические сервера в рамках этой заметке установлена операционная система Windows Server 2016 Standard (RUS) Version 10.0.14393 и все обновления на текущую дату (29.04.2018).

Шаг №2: Операционная система введена в текущий домен (в моем случае это polygon.local)

Шаг №3: Подключаюсь по RDP к первому серверу (srv-noda1) с правами учетной записи (Login: ekzorchik) в ходящей в группу «Администраторы домена» и устанавливаю роль Hyper-V и компонент, через который формируется кластера на Windows системе:

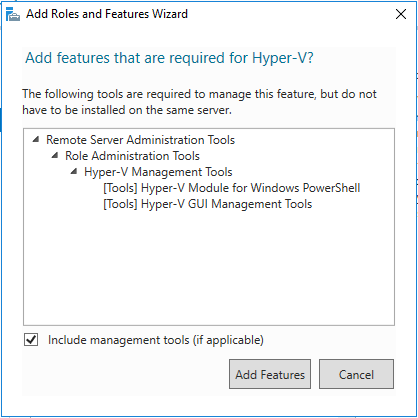

Win + R – control.exe – Администрирование – «Диспетчер серверов» — «Управление» — «Добавить роли и компоненты» и отмечаю галочкой, а на уведомление мастера установки, что к выбранному необходимы дополнительные компоненты соглашаюсь нажатием кнопку «Добавить компоненты»

- Роль: Hyper-V

- Компоненты: Отказоустойчивая кластеризация

- Не забываем выбрать виртуальный коммутатор на каждой ноде, в моем случае у меня Nic Teaming из двух карт, а потому отмечаю галочкой сетевой интерфейс с именем Team1G в роли виртуального коммутатора для Hyper-V.

Этап Hyper-V -> Миграция никак не отмечаю, данные настройки я выполню позже

Указываю размещение виртуальных жестких дисков и конфигураций виртуальной машины на еще одном общем диске, который через хранилище Dell EMC SCv3020 назначен физическим нодам:

На заметку: Важно чтобы общий диск к серверам имел одну и туже логическую букву.

- Расположение по умолчанию для файлов виртуальных жестких дисков: E:\disk

- Расположение по умолчанию для файлов конфигурации виртуальной машины: E:\conf

На заметку: Но при создании VM нужно указывать путь: C:\ClusterStorage\Volume1\conf, где Volume1 есть LUN логического диска E.

И нажимаю кнопку «Далее», «Установить», галочку об автоматическом перезапуске конечного сервера не ставлю, я считаю, что лучше убедиться, что это действительно нужно, об этом должен сообщить мастер установки устанавливаемого. И вот когда установка завершена я вижу надпись: «Ожидается перезапуск на srv-noda1.polygon.local. Для завершения установки необходимо перезапустить сервер», перезапускаю:

Win + X – Командная строка (Администратор) -> shutdown /r /t 3

Но теперь я знаю, что галочку об автоматическом перезапуске можно ставить и она необходима.

Шаг №4: Проделываю действия Шага №3 и на других серверах которые будут входить в собираемый кластер. Можно либо подключиться к ним по RDP и повторить шаги или же дождаться, когда сервер с именем srv-noda1.polygon.local перезагрузиться и подключиться к нему по RDP и запустить установку роли и компоненты, но уже задействую настройку «Выбор сервера» выбрать сервер, входящий в группу, а у меня это следующая нода.

Для перезапуска/перезагрузки следует воспользоваться созданной группой сервер в которую входит данный сервер:

Win + R – control.exe – Администрирование – «Диспетчер серверов» — перехожу в группу серверов srv-noda и через правый клик мышью по сервер srv-noda2 выбираю меню «Перезапустить сервер» и подтверждаю свое намерение нажатием кнопки «ОК». Пока сервер в перезагрузку проделываю все шаги с третьим сервером.

Шаг №5:

Теперь, когда необходимые роли и компоненты установлены соберем кластер.

Mstsc – srv-noda1.polygon.local – Win + R – control – Администрирование – «Диспетчер отказоустойчивости кластеров» — потом через правый клик мышью по «Диспетчер отказоустойчивости кластеров» выбираю действие «Проверить конфигурацию» на предмет создания кластера.

Выбор серверов или кластера:

- Введите имя: — Обзор – нахожу всех srv-noda[1-3], выделяю их и указываю имя объединяющее их это: srv-cluster, получается следующее:

- Выбранные серверы:

srv-noda1.polygon.local,srv-noda2.polygon.local,srv-noda3.polygon.local

И нажимаю «Далее», оставляю дефолтным выбор мастера «Выполнить все тесты» и нажимаю «Далее», «Далее»

На заметку: к серверам уже должен быть подключен общий диск, который будет кворумным для обмена информацией между нодами кластера

По окончании проверки на создании кластера нужно в обязательном порядке нажать на «Просмотреть отчет…»

На заметку: я отключаю поддержку ipv6 и устанавливаю все обновления на момент написания данной заметки, плюс настройка что уведомлять об обновлениях, а скачивание и установку их я принимаю вручную или же отключаю их:

Управляем обновлениями на Windows Server 2016

Win + X – Командная строка (Администратор)

C:\Windows\system32>sconfig

Введите номер параметра: 5 (Параметры центра обновления Windows)

Выберите режим обновления: указываю M (Ручной)

Введите номер параметра: 15

На заметку: Если на серверах используется Nic Teaming, то интерфейсы на всех серверах должны называться одинаково (Team10G,Team1G)

На заметку: Обязательно следует устранить все проблемы, которые обозначены в отчете при проверке нод из которых вы хотите создать Windows кластер.

После через Мастер «Создать кластер» создаю, отвечая и заполняя настройки мастера:

- Имя кластера: srv-cluster

- Сети: 10.99.99.0/27

- Адрес: указываю свободный IP адрес и подсети, к примеру 10.99.99.99

На заметку: имя кластера не должно быть длиннее 15 символов

И нажимаю «Далее», галочка у «Добавление всех допустимых хранилищ в кластер» должна стоять и нажимаю снова «Далее», «Готово»

Итак, кластер развернут, управление им идет через оснастку «Диспетчер отказоустойчивости кластеров», а именно добавление ролей, управление дисками (а не через «Управление дисками», если перейти в этой оснастке Вас может смутить что диск, который от хранилища не под монтирован, но это нормально, т.к. управление идет через диспетчера кластеров).

Самой важной настройкой обычно ни где не упомянутой остается, что нужно запустить оснастку управления кластером:

Win + R – control.exe – Администрирование – «Диспетчер отказоустойчивости кластеров» — перейти в «Хранилище» — «Диски» и увидеть все диски кластера (либо это LUN, либо это логические тома), выделяю в моем случаем «Диск кластера 2»

| Имя | Состояние | Назначено | Узел владельца |

| Диск кластера 2 | Оперативный | Доступное хранилище | Srv-noda1 |

И через правый клик мышью по нему выбираю «Добавить в общие тома кластера», этой настройкой логический диск размеченного LUN с отформатированной файловой системой NTFS переназначится в том видимый лишь кластеру с файловой системой CSVFS. Когда это проделано то в колонке «Назначено» будет значится уже «Общий том кластера».

Данная настройка предоставляет возможность мигрировать хосты между нодами. Ну как-то так.

Свою задачу по разворачиваю кластера я выполнил и прощаюсь, с уважением автор блога Олло Александр aka ekzorchik.