Данная статья подойдёт для новичков, которые хотят потренироваться в настройке кластера Hyper-V 2019. Итак, имеется:

— Тестовый комп1 «железный»

— Тестовый комп2 «железный»

— Тестовый комп3 «виртуальный» с Windows srv 2019 и настроенной ролью контроллера домена.

— Тестовый комп4 «железный» с расшаренным диском по протоколу iSCSI.

— Всё это соединено через обычный пассивный коммутатор.

На тестовый комп1 установлена Windows Srv 2019 Standard Evaluation с графической оболочкой. На тестовый комп2 установлена Microsoft Hyper-V Server 2019 — данная ОС бесплатна и устанавливается как обычная Windows 10/2019. Скачать эту ОС можно с оф.сайта Microsoft:

https://www.microsoft.com/ru-ru/evalcenter/evaluate-hyper-v-server-2019

Собственно, на этой же странице можно скачать и Windows Srv 2019 Standard Evaluation. И если, после установки Windows Srv 2019 с графической оболочкой, вопросов о том, как ей пользоваться дальше, нету, то после установки Hyper-V Server 2019 могут возникнуть вопросы, что с этой ОС делать дальше. Ведь у Hyper-V Server 2019 графической оболочки нет. После установки есть лишь вот такое окно:

Здесь можно сделать самые основные настройки: задать имя компьютера, прописать статический IP, включить доступ по RDP.

Для дальнейшего удобства администрирования данной ОС, я установлю пару инструментов. Первый из них — это банальный Total Commander portable, который я просто скопирую на диск C: с флэшки. Сделать это можно командой:

xcopy f:\totalcmd c:\totalcmd\ /y /e

Где f:\totalcmd — это каталог с total командером на флэшке, а c:\totalcmd\ — каталог, в который копирую.

Потом перехожу в этот каталог и запускаю тотал командер:

c:

cd c:\totalcmd

totalcmd.exe

Дальше уже будет проще. Пользуясь тотал командером, нахожу каталог с драйверами и устанавливаю их.

Следующий инструмент, который облегчит администрирование Hyper-V Server 2019 — это WINDOWS ADMIN CENTER. Это вэб-админка от Microsoft, с помощью которой можно администрировать сервер через вэб-интерфейс. Некий аналог Webmin, но для Windows-систем. Скачать его можно на той же странице, где скачивались установочные образы операционных систем:

https://www.microsoft.com/ru-ru/evalcenter/evaluate-windows-admin-center

Дистрибутив Windows админ центра можно тоже перенести через флэшку на сервер.

Установка данного программного обеспечения самая обычная, где все параметры можно оставить по умолчанию.

После установки Windows админ центра нужно зайти на сервер через обычный браузер по https протоколу:

https://192.168.0.206/

Сообщение безопасности нужно игнорировать, т.к. используется самоподписанный сертификат. Логин и пароль при подключении — это виндовый «администратор» с его паролем в самой ОС. Вот так выглядит Windows Admin Центр:

В списке серверов выбираю свой, который также стал шлюзом Windows AdminЦентра. Ну и подробно на всех возможностях останавливаться не буду, т.к. их много. Вэб-интерфейс хоть и тормозной, но довольно функциональный — через него можно будет управлять и виртуальными машинами в том числе. Или, например, если какие-то драйвера не установлены, то их можно доустановить уже через Windows AdminЦентр:

Я же пробую ввести данный сервер в домен. Жму на меню «Обзор» и затем на «Изменить идентификатор компьютера».

Ну а дальше, всё как обычно:

Сервер перезагрузится. После чего, в Windows Admin Центр рекомендуется войти уже под доменным администратором! Имя пользователя надо вводить в таком формате:

Ну и кстати, желательно бы установить обновления для Windows Admin Центра, если они есть. Для этого надо нажать на шестерёнку и выбрать пункт «расширения». Ну и там дальше всё понятно будет:

Разобравшись с сервером на ОС Hyper-V Server 2019, сделаю всё то же самое и на сервере под управлением Windows Srv 2019 Standard Evaluation. Там уже всё делается в привычном виде — через графическую оболочку Windows. Установил драйверы, ввел сервер в домен AD — подробности этого всего описывать не буду.

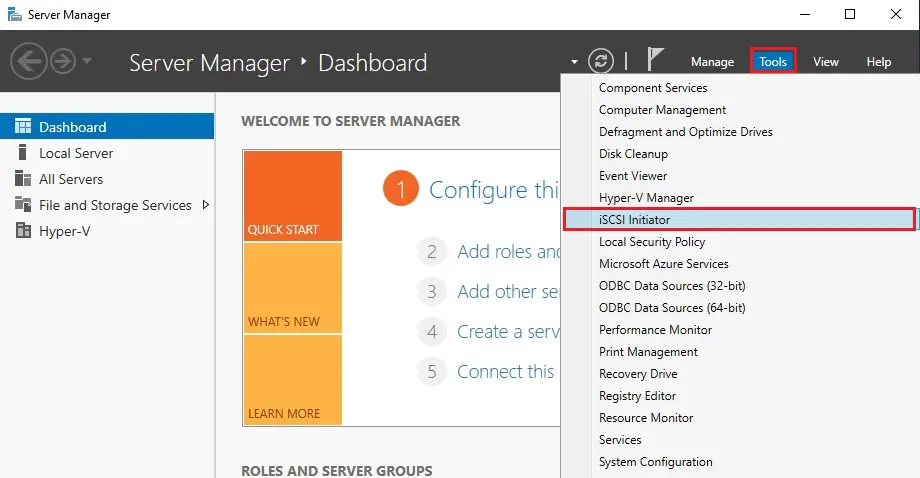

Следующим шагом будет подключение сетевого диска iSCSI. Захожу в «Средства администрирования»:

И там выбираю Инициатор iSCSI:

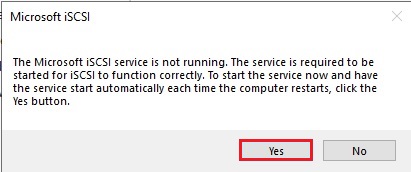

При первом запуске выйдет сообщение о том, что служба iSCSI не запущена, и будет предложено запустить эту службу и включить её автозапуск при старте сервера. Ну а потом появится окно, в котором надо будет перейти на вкладку «Обнаружение» и нажать на кнопку «Обнаружить портал»:

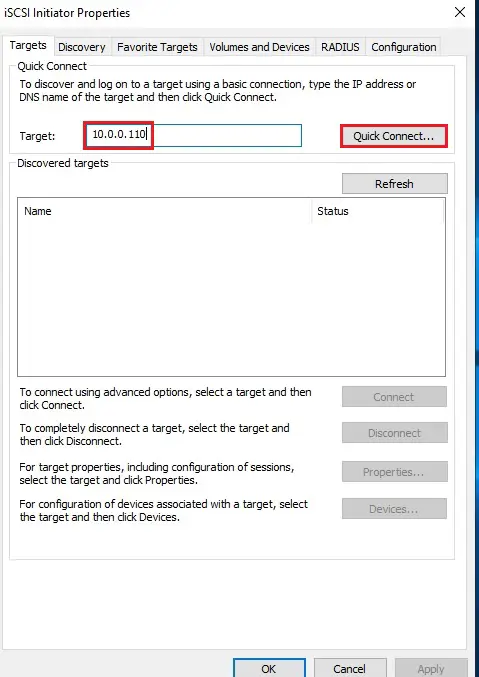

Затем надо ввести IP-адрес сервера iSCSI:

В моём случае, этого будет достаточно. Но если iSCSI сервер требует пароль для подключения к себе, то надо нажать кнопку «Дополнительно» и там ввести этот пароль.

Далее, надо перейти на вкладку «Конечные объекты» и нажать кнопку «Подключить»:

В появившемся окне надо нажать на «ОК», после чего диск перейдёт в состояние «Подключено»:

Всё, это окно можно закрывать. Дальше надо зайти в диспетчер управления дисками, в котором отобразится подключенный iSCSI диск. Его надо проинициализировать и отформатировать в NTFS:

Сильно подробно это не буду расписывать. Уверен, что форматировать диск под NTFS умеют все ИТ-специалисты. После форматирования можно попробовать что-нибудь записать на него, чтобы убедиться в работоспособности диска.

Далее, этот же диск надо подключить на втором сервере под управлением Hyper-V Server 2019. На самом деле, там это всё делается точно также. Надо лишь в командной строке ввести:

iscsicpl

Появится точно такое же окно, как и на сервере с графической оболочкой:

Нужно проделать те же действия, что и на первом сервере. Но в диспетчер дисков заходить уже не нужно. Достаточно просто подключить диск по iSCSI.

Теперь снова перехожу к серверу под управлением Windows Srv 2019 Standard Evaluation, на котором нужно установить роль Hyper-V, а также роль Кластера. В диспетчере сервером жму «Добавить роли и компоненты»:

В первом шаге жму «далее», потом снова «далее», оставив на месте крыжик «Установка ролей или компонентов». Выбираю в списке свой сервер, который там пока один, жму «далее»:

Ставлю галку на Hyper-V и соглашаюсь с добавлением остальных компонентов по зависимостям:

Жму «далее». На следующем шаге, где уже предлагается выбрать компоненты, ставлю галку на «Отказоустойчивой кластеризации» и соглашаюсь с добавлением остальных компонентов по зависимостям:

Жму кнопку «Далее». На следующем шаге предлагается сразу создать виртуальный коммутатор, но я пока не буду. Создам его потом вручную. Просто жму «Далее».

На следующем шаге предлагается включить и выбрать протокол для динамической миграции. Однако внизу есть предупреждение, что если данный сервер будет членом кластера, то этого делать на надо. Поэтому ничего не трогаю и жму «далее».

Расположение по умолчанию дисков и конфигурации виртуальных машин тоже пока не трогаю. Эти значения надо менять уже после настройки кластера. Жму «далее», а затем «установить». Дожидаюсь окончания установки.

Теперь кое-какие компоненты надо установить на машине с Hyper-V Server 2019. Для этого открываю диспетчер серверов на машине с Windows Srv 2019 Standard Evaluation и жму «Добавить другие серверы для управления»:

В поле «Имя» ввожу имя компьютера машины Hyper-V Server 2019, жму «найти» и потом добавляю его в правый список. Жму «ОК»:

Потом жму «Добавить роли и компоненты» и на шаге, где предлагается выбрать сервер, выбираю машину с Hyper-V Server 2019:

На шаге с выбором ролей сервера ничего не трогаю и жму «далее». А вот на шаге выбора компонентов добавляю «Отказоустойчивую кластеризацию» и соглашаюсь с добавлением остальных компонентов по зависимостям:

Жму «далее» и «установить», дожидаюсь окончания установки.

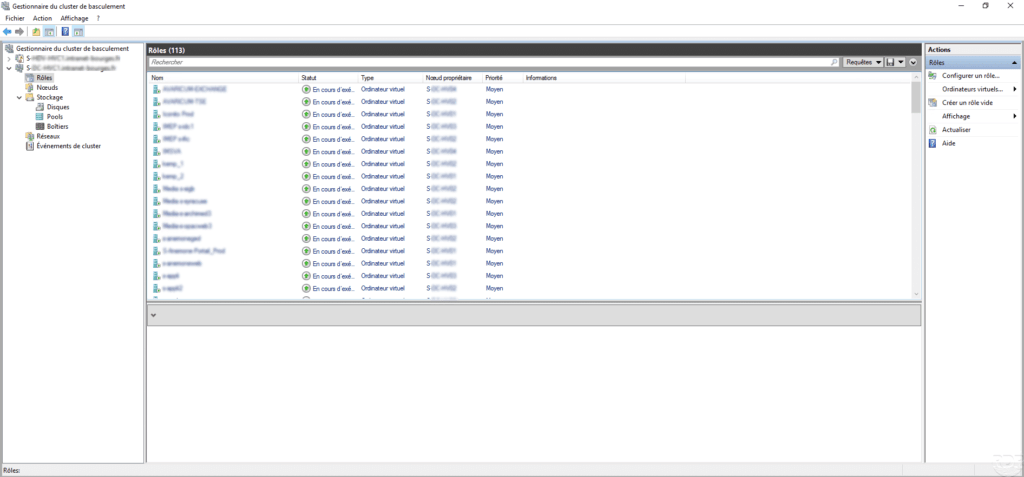

Теперь надо создать кластер. На машине Windows Srv 2019 Standard Evaluation захожу в «средства администрирования» и выбираю «Диспетчер отказоустойчивости кластеров»:

В открывшемся окне жму «Создать кластер».

На первом шаге «Перед началом работы» жму «далее». А на следующем шаге выбираю, какие серверы будут членами кластера:

На следующем шаге предлагается выполнить проверочные тесты для выбранных серверов. Пусть выполнит. Оставляю «да» и жму «далее».

Откроется дополнительный мастер с вопросом, какие тесты выполнить. Оставляю «Выполнить все тесты» и жму «далее».

Запускается тестирование, жду его окончания:

У меня тестирование нашло ошибки, которые я и предполагал, что будут:

Да, действительно, у меня тестовые компы на разных процессорах. Один на Intel Xeon 2620 v3, а второй на AMD FX 8350. Но других компов у меня нет, да и это лишь тестовая установка. Сеть у меня тоже одна, хотя рекомендуется иметь выделенную сеть для соединения с дисками iSCSI. Ну и разные версии операционных систем я выбрал нарочно — хочу посмотреть, как оно будет работать именно в таком варианте. Повторюсь, что установка тестовая, в домашних условиях и лишь для ознакомления. Для продакшена надо делать следуя рекомендациям Microsoft.

После тестов появляется следующий шаг, на котором надо задать имя кластера и указать его IP-адрес:

Жму «далее». Здесь тоже жму «далее»:

После создание кластера появится такое окно:

Иии… Сразу обращаю внимание, что есть какие-то ошибки.

Смотрю их подробнее:

Ресурсу сетевого имени «Имя кластера» кластера не удалось зарегистрировать одно или несколько связанных DNS-имен по следующей причине:

Неверный раздел DNS.

Убедитесь, что сетевые адаптеры, связанные с зависимыми ресурсами IP-адресов, настроены для доступа хотя бы к одному DNS-серверу.

И действительно на DNS-сервере запись о кластере не добавилась. Причину тому не знаю:

Но не страшно, добавляю эту запись вручную.

После создания кластера надо настроить для него параметры кворума. Что это за кворум, почитать можно тут:

https://docs.microsoft.com/ru-ru/windows-server/storage/storage-spaces/understand-quorum

Вообще, мастер установки сделал правильно. Он под кворум забрал диск iSCSI. Но дело в том, что это мой единственный диск iSCSI, который я хочу использовать под виртуальные машины, а не под кворум. Кворум можно разместить в обычной сетевой папке. Поэтому захожу вот сюда:

Там выбираю «Выбрать свидетель кворума»:

И дальше выбираю «Настроить файловый ресурс-свидетель»:

И указываю сетевую папку:

Потом жму везде «далее».

Важно! В правах доступа к этому каталогу должны быть указаны не только администраторы, но и сам кластер:

Добавить его можно, включив галку «Компьютеры» вот тут:

После того, как диск высвободился из-под кворума, добавляю его в общие тома кластера:

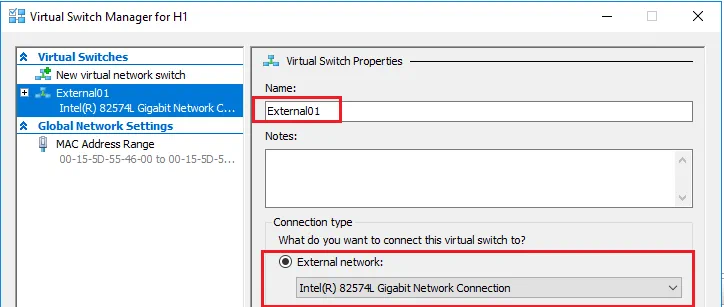

Теперь надо добавить виртуальный коммутатор на обе машины. Важно, чтобы виртуальные коммутаторы имели одинаковое название. Создать их можно как через оснастку на Windows Srv 2019 Standard Evaluation, так и через Windows Admin Center. Я, ради интереса, создам виртуальный коммутатор на машине с Windows Srv 2019 Standard Evaluation через Windows Admin Center. А виртуальный коммутатор на машине с Hyper-V Server 2019 создам через оснастку на Windows Srv 2019 Standard Evaluation.

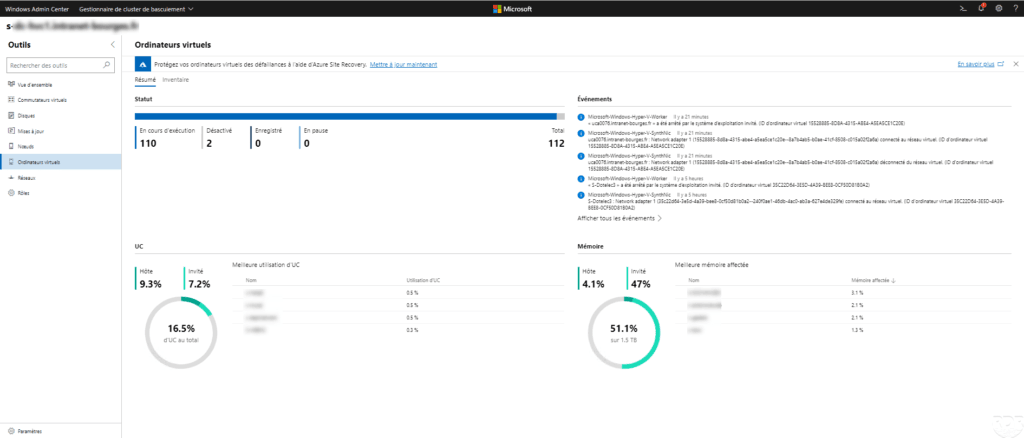

Итак, захожу в Windows Admin Center и выбираю «Диспетчер кластеров»:

Потом жму «Добавить»:

И справа будет предложено ввести имя кластера, а также учётные данные для подключения к нему. Заполняю и жму «Подключитесь с помощью учётной записи»:

Потом жму «Добавить»:

Теперь вижу кластер в списке хостов для управления через Windows Admin Center. Выбираю его:

Ну а там перехожу в меню «Виртуальные коммутаторы» и жму «Создать».

Ну а там дальше выбираю узел, задаю название коммутатора и тип выбираю ему внешний. Жму создать.

Во время создания виртуального коммутатора отвалится ненадолго связь с машиной, на которой он создаётся. Потом он отобразится в списке виртуальных коммутаторов:

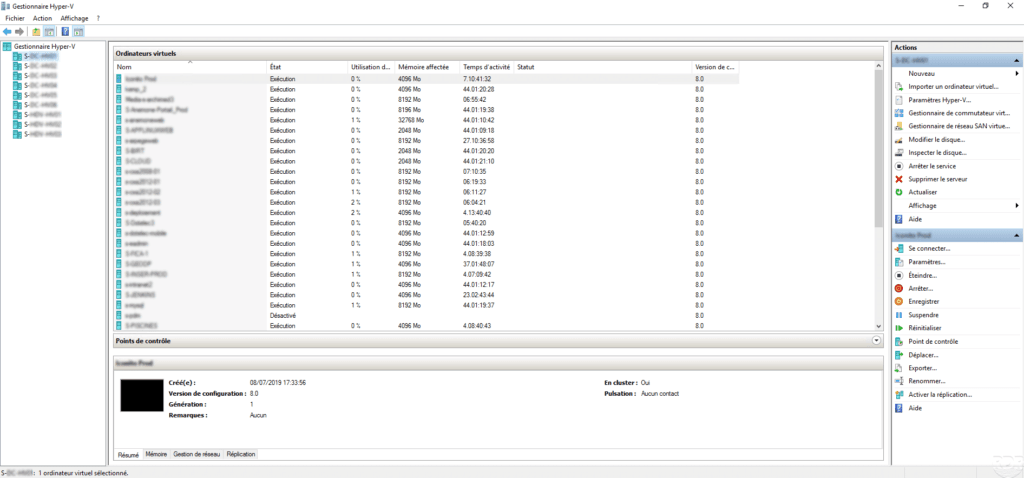

Теперь создам виртуальный коммутатор для машины с Hyper-V Server 2019, но через оснастку на машине Windows Srv 2019 Standard Evaluation. Открываю «Средства администрирования» и выбираю оснастку «Диспетчер Hyper-V»:

Там выбираю «Подключиться к серверу», пишу его имя и жму «ОК»:

Дальше захожу в «Диспетчер виртуальных коммутаторов»:

Выбираю внешний и жму «Создать виртуальный коммутатор»:

Задаю такое же имя, как и на первой машине, жму «ОК»:

Выйдет предупреждение, что связь с машиной потеряется на некоторое время. Соглашаюсь и жду завершения. После чего снова захожу в «Диспетчер виртуальных коммутаторов» и вижу, что коммутатор там появился:

Также его можно видеть и через Windows Admin Center:

Что ж, пришло время создать виртуальную машину. Я попробую что-нибудь лёгкое, например, виртуальную машину с Windows XP. Создаю:

Выбираю хост:

Задаю название машины и расположение её конфигурации. Каталог C:\ClusterStorage\volume1 — это и есть тот самый iSCSI диск.

Далее предлагается выбрать поколение виртуальной машины. Для Windows XP надо выбирать первое поколение.

Оперативной памяти выделяю 1Гб, хватит сполна.

Далее настройка сети. Там выбираю виртуальный коммутатор komm1.

Дальше мастер предлагает сразу создать виртуальный диск для этой виртуальной машины. Для XP большой диск не нужен. Также указываю месторасположение диска — тоже на ресурсе iSCSI:

Жму «Далее». На следующем шаге предлагается выбрать установочный носитель с операционной системой. В моём случае, он лежит на флэшке, подключенной к серверу. Выбираю его:

Жму «далее», жму «готово» и получаю вот такую непонятную ошибку:

Не удалось создать виртуальную машину. Проблема оказалась в правах доступа файловой системы. Мастер не мог создать виртуальную машину, т.к. у него просто не было доступа в указанный каталог. Дал вот такие права, и виртуальная машина создалась:

Пробую запустить и установить Windows XP. Жму сначала «Запустить», а потом «Подключить»:

Началась установка Windows XP. Кстати, эту виртуальную машину видно и в Windows Админ Центре:

И от туда к ней тоже можно подключиться:

После установки в Windows XP даже мышь работать не будет. Чтобы всё заработало, надо установить службы интеграции. Установочный образ можно взять тут:

https://disk.yandex.ru/d/b8dcTwIQerC-EQ/vmguest.iso

А затем подставить его в свойствах виртуальной машины вместо установочного образа Windows XP:

Это можно сделать даже при включённой виртуальной машине. Сработает автозапуск с виртуального CD, и интеграционные службы начнут сразу устанавливаться:

Потом установщик попросит перезагрузку. После перезагрузки Windows XP будет работать абсолютно нормально.

Теперь хочется проверить, как виртуальная машина будет переходить с одного узла на другой в кластере. Пробую запустить динамическую миграцию на узел Hyper1:

И получаю ошибку. В подробных сведениях написано вот что:

Собственно, это то, о чём и предупреждал мастер создания кластера на этапе тестирования. Невозможно произвести динамическую миграцию от узла с процессором Intel на узел с процессором AMD. И наоборот — тоже нельзя. Но зато можно это сделать, завершив работу виртуальной машины. Пробую. Работу Windows XP завершил и теперь пробую сделать быструю миграцию (меню динамической миграции уже неактивно):

На этот раз всё успешно, виртуальная машина переместилась на узел Hyper1. Пробую запустить:

Работает. Пробую теперь погасить сервер Hyper2. Виртуальная машина с Windows XP осталась работать при этом:

На этом можно и заканчивать статью. Конечно, для продакшена такая настройка кластера не подойдёт. Но для ознакомления — вполне себе вариант. Так что, может кому и пригодится.

Донаты принимаются на кошельки:

Yoomoney:

4100118091867315

BTC:

bc1qzw9vam8mv6derwscxl0vrnd6m9t2rpjg273mna

ETH / BNB BSC / Polygon MATIC:

0x5cc07FF76490350ac6112fbFdA1B545Bc794602F

Tron:

TJUz8sJr9XYMjVqzmFNnCzzRWfPa57X2RV

USDT/USDC в сетях ETH/BSC/Polygon:

0x5cc07FF76490350ac6112fbFdA1B545Bc794602F

USDT в сети TRX (Tron):

TJUz8sJr9XYMjVqzmFNnCzzRWfPa57X2RV

LTC:

LRMZaFCSyCT6FUF62WEX1BokWV7v2dh2zo

Doge:

DTEnGLZRps9XaWNtAhchJWSeD4uTNDRxg7

XMR:

4A6uP1WxEc7HktToZFyiJuK6YmjdL8bSn2aY653qPwABhT4Y56iFuedgHcmpvLwWE55u8qkjGc715ZJs761FqedA8gkgznr

TON:

UQAdSPiWIDx2Q1VIeezkUV3s4sNlZM90w2ohSO6bD2-okwgY

Create Hyper-V Cluster; in this first article of creating a Hyper-V cluster in Window Server 2019, we will keep a look at installing the Hyper-V role, networks, and also attaching both hosts to iSCSI targets.

Although, I would like to configure Hyper-V in a cluster configuration if we are serious about operating highly available & scalable Hyper-V production workloads in the enterprise datacenter.

In the second article, we will look at installing Failover Clustering, creating our Failover cluster, creating clustered shared volumes (CSVs), and Hyper-V virtual machine highly availability role.

Clustering Requirements click here

Systems Requirements:

HVS2K19-01 (Host 1) Windows Servers 2019

10.0.0.60

192.168.1.2

HVS2K19-02 (Host 2) Windows Servers 2019

10.0.0.62

192.168.1.3

Install Windows Server 2019

Install Hyper-V

Windows Server 2019 ( iSCSI SAN Storage) with 2 drives configured

10.0.0.110

Install and Configure target iSCSI Server

Drive 1: 10 GB (Quorum)

Drive 2: VM Server Storage

Microsoft Server 2019 with Hyper-V capabilities

Create Hyper-V Cluster

After installing and configuring iSCSI Server log in to your first hyper-v node (HVS2K19-01).

1- In the Server Manager, click tools and then select iSCSI Initiator.

2- The Microsoft iSCSI service to automatically start. Select Yes.

3- In the iSCSI initiator properties we need to enter the address of our iSCSI target and then click Quick Connect to automatically connect to the discovered targets.

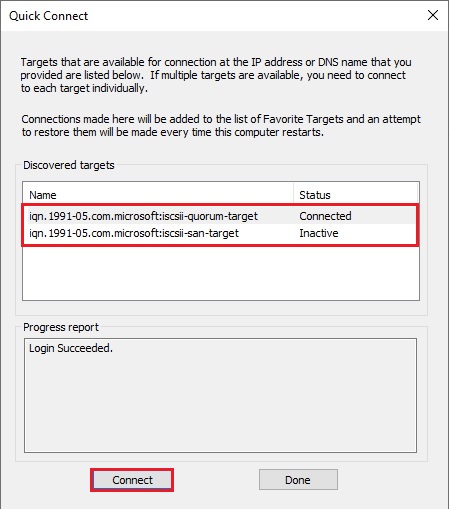

4- Two iSCSI targets are found. Notice they show to be Inactive. Select each one and then click Connect.

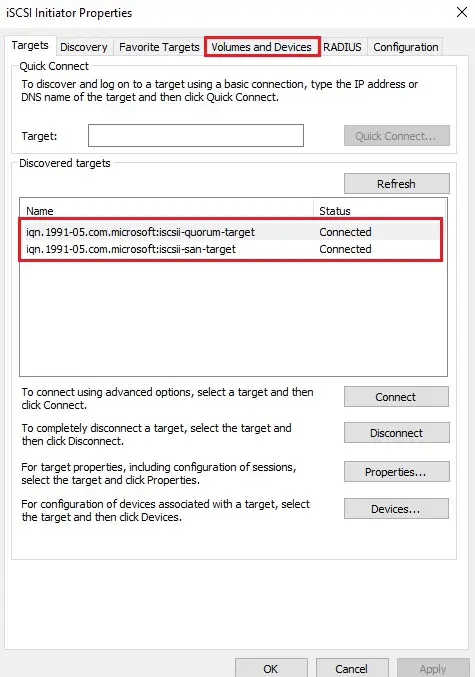

5- The status of the discovered iSCSI targets change to Connected.

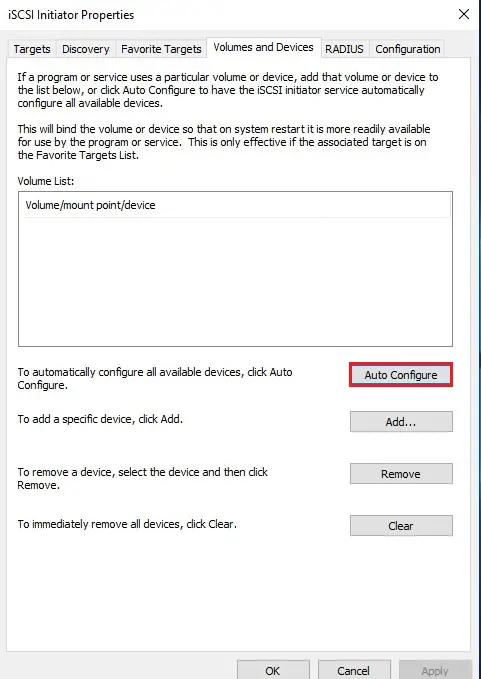

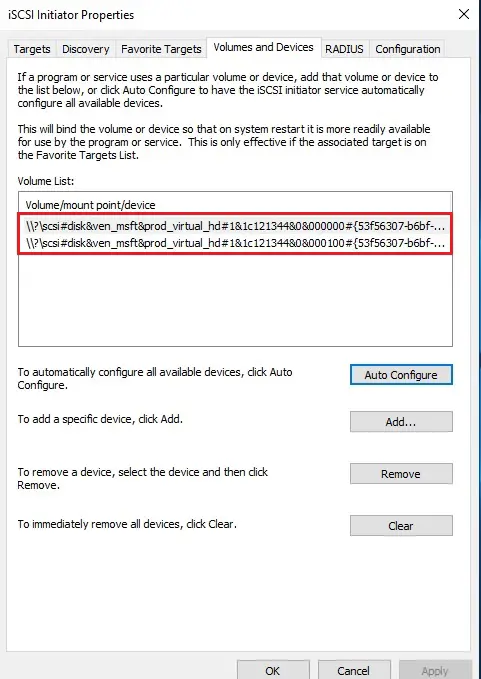

Now select the Volumes and Devices tab.

6- Select to Auto Configure the volumes.

7- Now you can see our Volume List populated with the iSCSI volume targets.

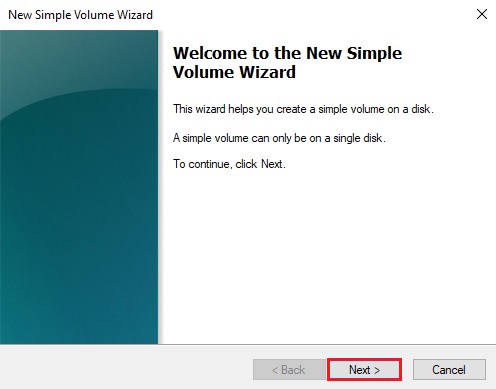

Cluster Storage and Quorum volume

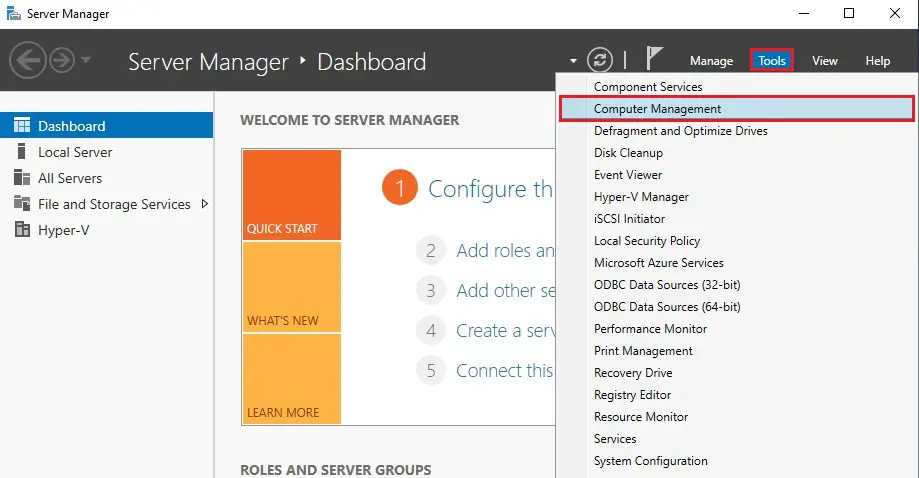

8- Open disk management

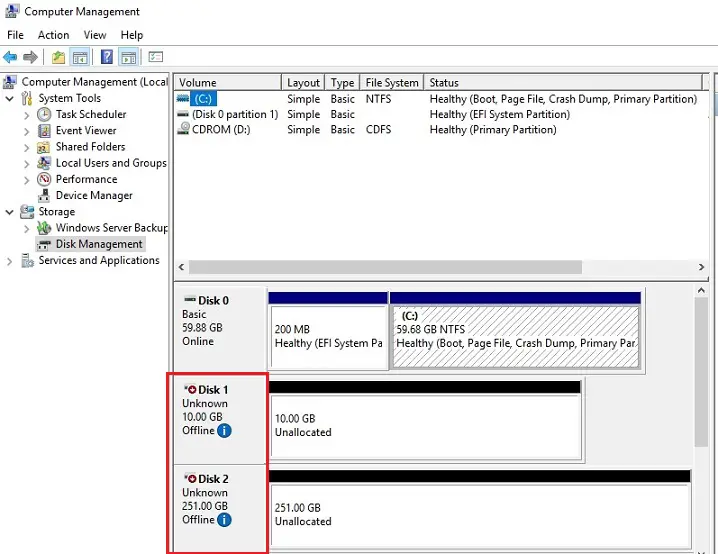

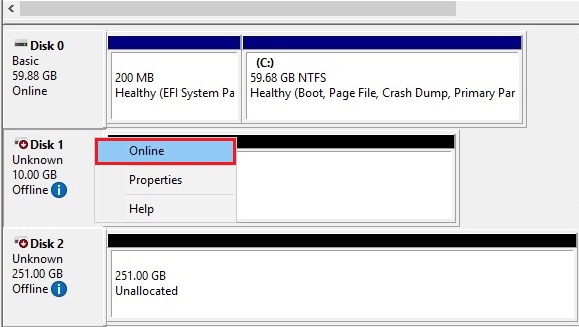

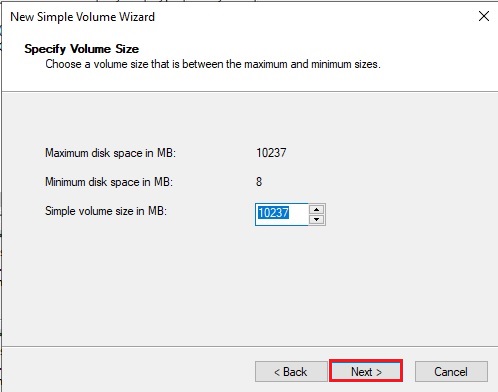

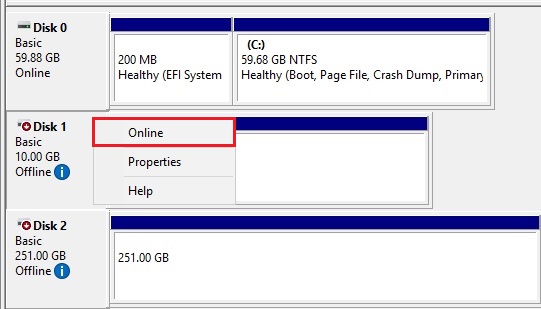

9- We can see the two disks show up as Offline. We need to bring then online.

10- Right click on disk and then select online.

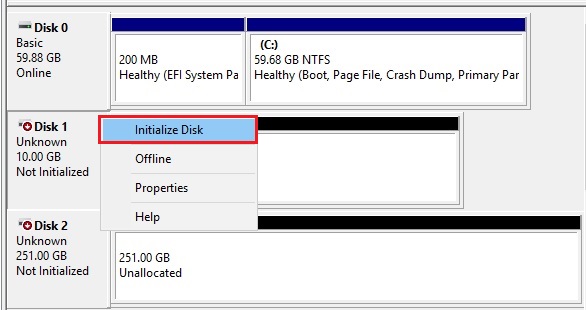

11- Right click on disk and then select initialize disk.

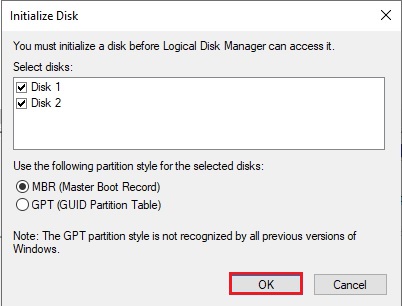

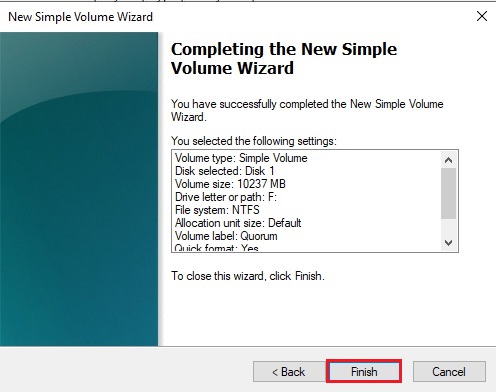

12- Initialize disk wizard (Master boot record) so click ok.

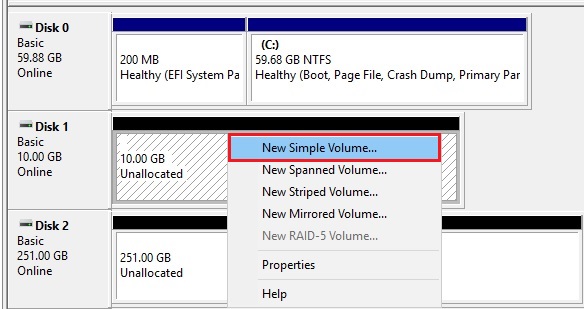

13- Right click on unallocated disk and then select new simple volume.

14- New simple volume wizard click next.

14- Click next.

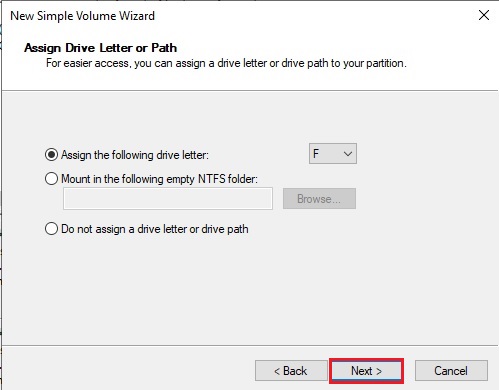

15- Assign a drive letter and then click next.

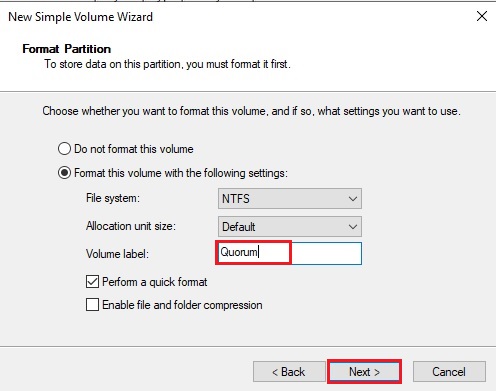

16- Type a volume label and then click next.

17- Click finish.

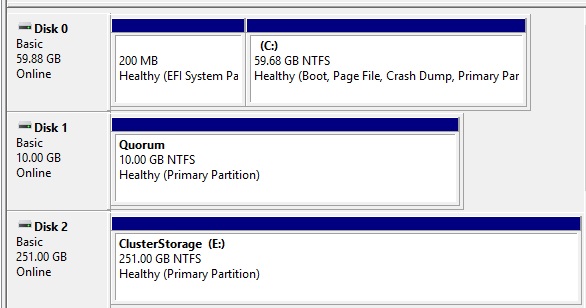

Follow the above steps from 13 to 17 for storage disk (ClusterStorage).

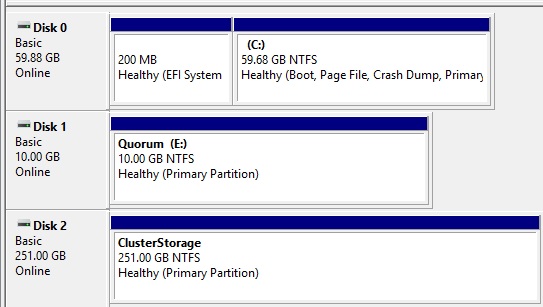

18- After bringing both disks online and initializing both disks, we can format, etc.

19- Now log in to your Hyper-v 2nd node (HVS2K19-02). Open computer management, select disk management, right click on both disks and then select online.

20- Here you can see both disks (Cluster Storage and Quorum) are online.

In this first article, we have installed the Hyper-V role, network configuration, and add the shared storage to both nodes. In the next post, we will configure out how to install Failover Clustering, create our Failover cluster using our two Windows Server 2019 Hyper-V nodes, create clustered shared volumes (CSVs) & making the Hyper-V virtual machine workloads role highly available.

[recent_post_carousel design=”design-1″]

Jamil Parvezhttps://www.xpertstec.com

Jamil Pervez works as a Network Administrator, based in Kuwait with a Primary focus on Microsoft technologies. Microsoft Certified MCSE, MCTP, MCITP, CCNP, CCIP, CCVP with 20 years of experience in administering Windows Servers, Exchange, VMWare, Veeam B&R, Veritas BackupExec.

Данная статья подойдёт для новичков, которые хотят потренироваться в настройке кластера Hyper-V 2019. Итак, имеется:

— Тестовый комп1 «железный»

— Тестовый комп2 «железный»

— Тестовый комп3 «виртуальный» с Windows srv 2019 и настроенной ролью контроллера домена.

— Тестовый комп4 «железный» с расшаренным диском по протоколу iSCSI.

— Всё это соединено через обычный пассивный коммутатор.

На тестовый комп1 установлена Windows Srv 2019 Standard Evaluation с графической оболочкой. На тестовый комп2 установлена Microsoft Hyper-V Server 2019 — данная ОС бесплатна и устанавливается как обычная Windows 10/2019. Скачать эту ОС можно с оф.сайта Microsoft:

https://www.microsoft.com/ru-ru/evalcenter/evaluate-hyper-v-server-2019

Собственно, на этой же странице можно скачать и Windows Srv 2019 Standard Evaluation. И если, после установки Windows Srv 2019 с графической оболочкой, вопросов о том, как ей пользоваться дальше, нету, то после установки Hyper-V Server 2019 могут возникнуть вопросы, что с этой ОС делать дальше. Ведь у Hyper-V Server 2019 графической оболочки нет. После установки есть лишь вот такое окно:

Здесь можно сделать самые основные настройки: задать имя компьютера, прописать статический IP, включить доступ по RDP.

Для дальнейшего удобства администрирования данной ОС, я установлю пару инструментов. Первый из них — это банальный Total Commander portable, который я просто скопирую на диск C: с флэшки. Сделать это можно командой:

xcopy f:totalcmd c:totalcmd /y /e

Где f:totalcmd — это каталог с total командером на флэшке, а c:totalcmd — каталог, в который копирую.

Потом перехожу в этот каталог и запускаю тотал командер:

c:

cd c:totalcmd

totalcmd.exe

Дальше уже будет проще. Пользуясь тотал командером, нахожу каталог с драйверами и устанавливаю их.

Следующий инструмент, который облегчит администрирование Hyper-V Server 2019 — это WINDOWS ADMIN CENTER. Это вэб-админка от Microsoft, с помощью которой можно администрировать сервер через вэб-интерфейс. Некий аналог Webmin, но для Windows-систем. Скачать его можно на той же странице, где скачивались установочные образы операционных систем:

https://www.microsoft.com/ru-ru/evalcenter/evaluate-windows-admin-center

Дистрибутив Windows админ центра можно тоже перенести через флэшку на сервер.

Установка данного программного обеспечения самая обычная, где все параметры можно оставить по умолчанию.

После установки Windows админ центра нужно зайти на сервер через обычный браузер по https протоколу:

https://192.168.0.206/

Сообщение безопасности нужно игнорировать, т.к. используется самоподписанный сертификат. Логин и пароль при подключении — это виндовый «администратор» с его паролем в самой ОС. Вот так выглядит Windows Admin Центр:

В списке серверов выбираю свой, который также стал шлюзом Windows AdminЦентра. Ну и подробно на всех возможностях останавливаться не буду, т.к. их много. Вэб-интерфейс хоть и тормозной, но довольно функциональный — через него можно будет управлять и виртуальными машинами в том числе. Или, например, если какие-то драйвера не установлены, то их можно доустановить уже через Windows AdminЦентр:

Я же пробую ввести данный сервер в домен. Жму на меню «Обзор» и затем на «Изменить идентификатор компьютера».

Ну а дальше, всё как обычно:

Сервер перезагрузится. После чего, в Windows Admin Центр рекомендуется войти уже под доменным администратором! Имя пользователя надо вводить в таком формате:

Ну и кстати, желательно бы установить обновления для Windows Admin Центра, если они есть. Для этого надо нажать на шестерёнку и выбрать пункт «расширения». Ну и там дальше всё понятно будет:

Разобравшись с сервером на ОС Hyper-V Server 2019, сделаю всё то же самое и на сервере под управлением Windows Srv 2019 Standard Evaluation. Там уже всё делается в привычном виде — через графическую оболочку Windows. Установил драйверы, ввел сервер в домен AD — подробности этого всего описывать не буду.

Следующим шагом будет подключение сетевого диска iSCSI. Захожу в «Средства администрирования»:

И там выбираю Инициатор iSCSI:

При первом запуске выйдет сообщение о том, что служба iSCSI не запущена, и будет предложено запустить эту службу и включить её автозапуск при старте сервера. Ну а потом появится окно, в котором надо будет перейти на вкладку «Обнаружение» и нажать на кнопку «Обнаружить портал»:

Затем надо ввести IP-адрес сервера iSCSI:

В моём случае, этого будет достаточно. Но если iSCSI сервер требует пароль для подключения к себе, то надо нажать кнопку «Дополнительно» и там ввести этот пароль.

Далее, надо перейти на вкладку «Конечные объекты» и нажать кнопку «Подключить»:

В появившемся окне надо нажать на «ОК», после чего диск перейдёт в состояние «Подключено»:

Всё, это окно можно закрывать. Дальше надо зайти в диспетчер управления дисками, в котором отобразится подключенный iSCSI диск. Его надо проинициализировать и отформатировать в NTFS:

Сильно подробно это не буду расписывать. Уверен, что форматировать диск под NTFS умеют все ИТ-специалисты. После форматирования можно попробовать что-нибудь записать на него, чтобы убедиться в работоспособности диска.

Далее, этот же диск надо подключить на втором сервере под управлением Hyper-V Server 2019. На самом деле, там это всё делается точно также. Надо лишь в командной строке ввести:

iscsicpl

Появится точно такое же окно, как и на сервере с графической оболочкой:

Нужно проделать те же действия, что и на первом сервере. Но в диспетчер дисков заходить уже не нужно. Достаточно просто подключить диск по iSCSI.

Теперь снова перехожу к серверу под управлением Windows Srv 2019 Standard Evaluation, на котором нужно установить роль Hyper-V, а также роль Кластера. В диспетчере сервером жму «Добавить роли и компоненты»:

В первом шаге жму «далее», потом снова «далее», оставив на месте крыжик «Установка ролей или компонентов». Выбираю в списке свой сервер, который там пока один, жму «далее»:

Ставлю галку на Hyper-V и соглашаюсь с добавлением остальных компонентов по зависимостям:

Жму «далее». На следующем шаге, где уже предлагается выбрать компоненты, ставлю галку на «Отказоустойчивой кластеризации» и соглашаюсь с добавлением остальных компонентов по зависимостям:

Жму кнопку «Далее». На следующем шаге предлагается сразу создать виртуальный коммутатор, но я пока не буду. Создам его потом вручную. Просто жму «Далее».

На следующем шаге предлагается включить и выбрать протокол для динамической миграции. Однако внизу есть предупреждение, что если данный сервер будет членом кластера, то этого делать на надо. Поэтому ничего не трогаю и жму «далее».

Расположение по умолчанию дисков и конфигурации виртуальных машин тоже пока не трогаю. Эти значения надо менять уже после настройки кластера. Жму «далее», а затем «установить». Дожидаюсь окончания установки.

Теперь кое-какие компоненты надо установить на машине с Hyper-V Server 2019. Для этого открываю диспетчер серверов на машине с Windows Srv 2019 Standard Evaluation и жму «Добавить другие серверы для управления»:

В поле «Имя» ввожу имя компьютера машины Hyper-V Server 2019, жму «найти» и потом добавляю его в правый список. Жму «ОК»:

Потом жму «Добавить роли и компоненты» и на шаге, где предлагается выбрать сервер, выбираю машину с Hyper-V Server 2019:

На шаге с выбором ролей сервера ничего не трогаю и жму «далее». А вот на шаге выбора компонентов добавляю «Отказоустойчивую кластеризацию» и соглашаюсь с добавлением остальных компонентов по зависимостям:

Жму «далее» и «установить», дожидаюсь окончания установки.

Теперь надо создать кластер. На машине Windows Srv 2019 Standard Evaluation захожу в «средства администрирования» и выбираю «Диспетчер отказоустойчивости кластеров»:

В открывшемся окне жму «Создать кластер».

На первом шаге «Перед началом работы» жму «далее». А на следующем шаге выбираю, какие серверы будут членами кластера:

На следующем шаге предлагается выполнить проверочные тесты для выбранных серверов. Пусть выполнит. Оставляю «да» и жму «далее».

Откроется дополнительный мастер с вопросом, какие тесты выполнить. Оставляю «Выполнить все тесты» и жму «далее».

Запускается тестирование, жду его окончания:

У меня тестирование нашло ошибки, которые я и предполагал, что будут:

Да, действительно, у меня тестовые компы на разных процессорах. Один на Intel Xeon 2620 v3, а второй на AMD FX 8350. Но других компов у меня нет, да и это лишь тестовая установка. Сеть у меня тоже одна, хотя рекомендуется иметь выделенную сеть для соединения с дисками iSCSI. Ну и разные версии операционных систем я выбрал нарочно — хочу посмотреть, как оно будет работать именно в таком варианте. Повторюсь, что установка тестовая, в домашних условиях и лишь для ознакомления. Для продакшена надо делать следуя рекомендациям Microsoft.

После тестов появляется следующий шаг, на котором надо задать имя кластера и указать его IP-адрес:

Жму «далее». Здесь тоже жму «далее»:

После создание кластера появится такое окно:

Иии… Сразу обращаю внимание, что есть какие-то ошибки.

Смотрю их подробнее:

Ресурсу сетевого имени «Имя кластера» кластера не удалось зарегистрировать одно или несколько связанных DNS-имен по следующей причине:

Неверный раздел DNS.

Убедитесь, что сетевые адаптеры, связанные с зависимыми ресурсами IP-адресов, настроены для доступа хотя бы к одному DNS-серверу.

И действительно на DNS-сервере запись о кластере не добавилась. Причину тому не знаю:

Но не страшно, добавляю эту запись вручную.

После создания кластера надо настроить для него параметры кворума. Что это за кворум, почитать можно тут:

https://docs.microsoft.com/ru-ru/windows-server/storage/storage-spaces/understand-quorum

Вообще, мастер установки сделал правильно. Он под кворум забрал диск iSCSI. Но дело в том, что это мой единственный диск iSCSI, который я хочу использовать под виртуальные машины, а не под кворум. Кворум можно разместить в обычной сетевой папке. Поэтому захожу вот сюда:

Там выбираю «Выбрать свидетель кворума»:

И дальше выбираю «Настроить файловый ресурс-свидетель»:

И указываю сетевую папку:

Потом жму везде «далее».

Важно! В правах доступа к этому каталогу должны быть указаны не только администраторы, но и сам кластер:

Добавить его можно, включив галку «Компьютеры» вот тут:

После того, как диск высвободился из-под кворума, добавляю его в общие тома кластера:

Теперь надо добавить виртуальный коммутатор на обе машины. Важно, чтобы виртуальные коммутаторы имели одинаковое название. Создать их можно как через оснастку на Windows Srv 2019 Standard Evaluation, так и через Windows Admin Center. Я, ради интереса, создам виртуальный коммутатор на машине с Windows Srv 2019 Standard Evaluation через Windows Admin Center. А виртуальный коммутатор на машине с Hyper-V Server 2019 создам через оснастку на Windows Srv 2019 Standard Evaluation.

Итак, захожу в Windows Admin Center и выбираю «Диспетчер кластеров»:

Потом жму «Добавить»:

И справа будет предложено ввести имя кластера, а также учётные данные для подключения к нему. Заполняю и жму «Подключитесь с помощью учётной записи»:

Потом жму «Добавить»:

Теперь вижу кластер в списке хостов для управления через Windows Admin Center. Выбираю его:

Ну а там перехожу в меню «Виртуальные коммутаторы» и жму «Создать».

Ну а там дальше выбираю узел, задаю название коммутатора и тип выбираю ему внешний. Жму создать.

Во время создания виртуального коммутатора отвалится ненадолго связь с машиной, на которой он создаётся. Потом он отобразится в списке виртуальных коммутаторов:

Теперь создам виртуальный коммутатор для машины с Hyper-V Server 2019, но через оснастку на машине Windows Srv 2019 Standard Evaluation. Открываю «Средства администрирования» и выбираю оснастку «Диспетчер Hyper-V»:

Там выбираю «Подключиться к серверу», пишу его имя и жму «ОК»:

Дальше захожу в «Диспетчер виртуальных коммутаторов»:

Выбираю внешний и жму «Создать виртуальный коммутатор»:

Задаю такое же имя, как и на первой машине, жму «ОК»:

Выйдет предупреждение, что связь с машиной потеряется на некоторое время. Соглашаюсь и жду завершения. После чего снова захожу в «Диспетчер виртуальных коммутаторов» и вижу, что коммутатор там появился:

Также его можно видеть и через Windows Admin Center:

Что ж, пришло время создать виртуальную машину. Я попробую что-нибудь лёгкое, например, виртуальную машину с Windows XP. Создаю:

Выбираю хост:

Задаю название машины и расположение её конфигурации. Каталог C:ClusterStoragevolume1 — это и есть тот самый iSCSI диск.

Далее предлагается выбрать поколение виртуальной машины. Для Windows XP надо выбирать первое поколение.

Оперативной памяти выделяю 1Гб, хватит сполна.

Далее настройка сети. Там выбираю виртуальный коммутатор komm1.

Дальше мастер предлагает сразу создать виртуальный диск для этой виртуальной машины. Для XP большой диск не нужен. Также указываю месторасположение диска — тоже на ресурсе iSCSI:

Жму «Далее». На следующем шаге предлагается выбрать установочный носитель с операционной системой. В моём случае, он лежит на флэшке, подключенной к серверу. Выбираю его:

Жму «далее», жму «готово» и получаю вот такую непонятную ошибку:

Не удалось создать виртуальную машину. Проблема оказалась в правах доступа файловой системы. Мастер не мог создать виртуальную машину, т.к. у него просто не было доступа в указанный каталог. Дал вот такие права, и виртуальная машина создалась:

Пробую запустить и установить Windows XP. Жму сначала «Запустить», а потом «Подключить»:

Началась установка Windows XP. Кстати, эту виртуальную машину видно и в Windows Админ Центре:

И от туда к ней тоже можно подключиться:

После установки в Windows XP даже мышь работать не будет. Чтобы всё заработало, надо установить службы интеграции. Установочный образ можно взять тут:

https://disk.yandex.ru/d/b8dcTwIQerC-EQ/vmguest.iso

А затем подставить его в свойствах виртуальной машины вместо установочного образа Windows XP:

Это можно сделать даже при включённой виртуальной машине. Сработает автозапуск с виртуального CD, и интеграционные службы начнут сразу устанавливаться:

Потом установщик попросит перезагрузку. После перезагрузки Windows XP будет работать абсолютно нормально.

Теперь хочется проверить, как виртуальная машина будет переходить с одного узла на другой в кластере. Пробую запустить динамическую миграцию на узел Hyper1:

И получаю ошибку. В подробных сведениях написано вот что:

Собственно, это то, о чём и предупреждал мастер создания кластера на этапе тестирования. Невозможно произвести динамическую миграцию от узла с процессором Intel на узел с процессором AMD. И наоборот — тоже нельзя. Но зато можно это сделать, завершив работу виртуальной машины. Пробую. Работу Windows XP завершил и теперь пробую сделать быструю миграцию (меню динамической миграции уже неактивно):

На этот раз всё успешно, виртуальная машина переместилась на узел Hyper1. Пробую запустить:

Работает. Пробую теперь погасить сервер Hyper2. Виртуальная машина с Windows XP осталась работать при этом:

На этом можно и заканчивать статью. Конечно, для продакшена такая настройка кластера не подойдёт. Но для ознакомления — вполне себе вариант. Так что, может кому и пригодится.

Донаты принимаются на кошельки:

Yoomoney:

4100118091867315

BTC:

bc1qzw9vam8mv6derwscxl0vrnd6m9t2rpjg273mna

ETH / BNB BSC / Polygon MATIC:

0x5cc07FF76490350ac6112fbFdA1B545Bc794602F

Tron:

TJUz8sJr9XYMjVqzmFNnCzzRWfPa57X2RV

USDT/USDC в сетях ETH/BSC/Polygon:

0x5cc07FF76490350ac6112fbFdA1B545Bc794602F

USDT в сети TRX (Tron):

TJUz8sJr9XYMjVqzmFNnCzzRWfPa57X2RV

LTC:

LRMZaFCSyCT6FUF62WEX1BokWV7v2dh2zo

Doge:

DTEnGLZRps9XaWNtAhchJWSeD4uTNDRxg7

XMR:

4A6uP1WxEc7HktToZFyiJuK6YmjdL8bSn2aY653qPwABhT4Y56iFuedgHcmpvLwWE55u8qkjGc715ZJs761FqedA8gkgznr

TON:

UQAdSPiWIDx2Q1VIeezkUV3s4sNlZM90w2ohSO6bD2-okwgY

Create Hyper-V Cluster; in this first article of creating a Hyper-V cluster in Window Server 2019, we will keep a look at installing the Hyper-V role, networks, and also attaching both hosts to iSCSI targets.

Although, I would like to configure Hyper-V in a cluster configuration if we are serious about operating highly available & scalable Hyper-V production workloads in the enterprise datacenter.

In the second article, we will look at installing Failover Clustering, creating our Failover cluster, creating clustered shared volumes (CSVs), and Hyper-V virtual machine highly availability role.

Clustering Requirements click here

Systems Requirements:

HVS2K19-01 (Host 1) Windows Servers 2019

10.0.0.60

192.168.1.2

HVS2K19-02 (Host 2) Windows Servers 2019

10.0.0.62

192.168.1.3

Install Windows Server 2019

Install Hyper-V

Windows Server 2019 ( iSCSI SAN Storage) with 2 drives configured

10.0.0.110

Install and Configure target iSCSI Server

Drive 1: 10 GB (Quorum)

Drive 2: VM Server Storage

Microsoft Server 2019 with Hyper-V capabilities

Create Hyper-V Cluster

After installing and configuring iSCSI Server log in to your first hyper-v node (HVS2K19-01).

1- In the Server Manager, click tools and then select iSCSI Initiator.

2- The Microsoft iSCSI service to automatically start. Select Yes.

3- In the iSCSI initiator properties we need to enter the address of our iSCSI target and then click Quick Connect to automatically connect to the discovered targets.

4- Two iSCSI targets are found. Notice they show to be Inactive. Select each one and then click Connect.

5- The status of the discovered iSCSI targets change to Connected.

Now select the Volumes and Devices tab.

6- Select to Auto Configure the volumes.

7- Now you can see our Volume List populated with the iSCSI volume targets.

Cluster Storage and Quorum volume

8- Open disk management

9- We can see the two disks show up as Offline. We need to bring then online.

10- Right click on disk and then select online.

11- Right click on disk and then select initialize disk.

12- Initialize disk wizard (Master boot record) so click ok.

13- Right click on unallocated disk and then select new simple volume.

14- New simple volume wizard click next.

14- Click next.

15- Assign a drive letter and then click next.

16- Type a volume label and then click next.

17- Click finish.

Follow the above steps from 13 to 17 for storage disk (ClusterStorage).

18- After bringing both disks online and initializing both disks, we can format, etc.

19- Now log in to your Hyper-v 2nd node (HVS2K19-02). Open computer management, select disk management, right click on both disks and then select online.

20- Here you can see both disks (Cluster Storage and Quorum) are online.

In this first article, we have installed the Hyper-V role, network configuration, and add the shared storage to both nodes. In the next post, we will configure out how to install Failover Clustering, create our Failover cluster using our two Windows Server 2019 Hyper-V nodes, create clustered shared volumes (CSVs) & making the Hyper-V virtual machine workloads role highly available.

[recent_post_carousel design=”design-1″]

Jamil Parvezhttps://www.xpertstec.com

Jamil Pervez works as a Network Administrator, based in Kuwait with a Primary focus on Microsoft technologies. Microsoft Certified MCSE, MCTP, MCITP, CCNP, CCIP, CCVP with 20 years of experience in administering Windows Servers, Exchange, VMWare, Veeam B&R, Veritas BackupExec.

Table Of Contents

- Introduction

- Prerequisites

- Preparation of the environment

- Installing roles

- Configuring roles and features

- MPIO

- Hyper-V: network configuration

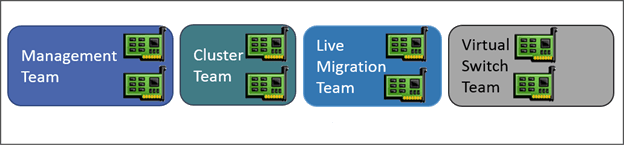

- Classic configuration

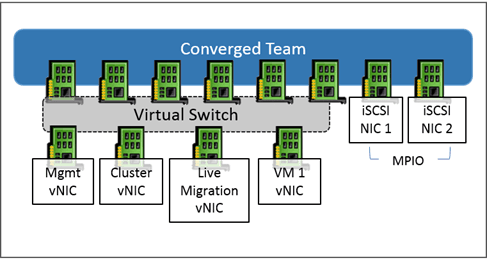

- Virtual configuration (converged team)

- Creating the failover cluster

- Configuring the update adapted to the cluster

- Management and Administration of the Hyper-V Cluster

- Consoles of administration

- Virtual machine management

- Cluster update

- Compléments

Introduction

Through this tutorial, we will see how to set up a Hyper-v cluster under Windows Server (2012R2 / 2016/2019) step by step.

Each step requires it, will take you on a tutorial to guide you in setting up a Hyper-V cluster.

Prerequisites

- Be in an Active Directory environment, ideally having a server-side domain controller that is not a member of the Hyper-V cluster.

- Have at least 2 identical servers (identical hardware configuration: cpu, ram, network card, bios …) under Windows 2012R2 / 2016/2019 members of the same domain.

- Have a storage type SAN (iSCSI / FC / SAS) and control its operation.

Since Windows Server 2016, it is possible to create a WorkGroup cluster without an Active Directory domain. This configuration is not recommended with the Hyper-V role because dynamic migration is not supported.

Preparation of the environment

On each server that will be in the cluster:

- Have the same version of bios and firmware of the different hardware components (RAID controller, network card, FC card …).

- Install the same version of Windows Server with the same level of update.

- Install the drivers of the different hardware components.

- Prepare at least two LUNs for the cluster

- Disk 1 to 10 GB for Quorum.

- Disk for storing computers to virtual.

- Prepare network configurations

- Management network

- Network live migration dedicated to the cluster

- Network of virtual machines

- Configure VLANs on assets if necessary.

Lien :

- Prepare the Quorum for the cluster. (page 1)

Installing roles

A Hyper-V cluster relies on several elements:

- The Hyper-V role that is the hypervisor for running virtual machines.

- The Failover Cluster feature that will enable high availability of the Hyper-V role.

- The MPIO feature that allows you to manage multi-way to storage.

The 3 elements can be installed simultaneously.

Links to the different tutorials:

- Hyper-V: installation on Windows Server 2012R2/2016/2019

- Installing the Failover Clustering feature (page 2)

- Installation of the MPIO if necessary according to the SAN (page 2).

Configuring roles and features

MPIO

On each server, it is necessary to configure the MPIO functionality to take into account multiple paths.

Before the configuration, present to each server the LUNs.

Link:

- MPIO configuration (page 3 et 4).

Hyper-V: network configuration

The network configuration is an important step in setting up the Hyper-V cluster.

There are two main types of configurations that are detailed after, so choose the one that suits you best.

Personally, I prefer the converged solution that offers more flexibility and less configuration on assets.

For failover to occur from one node to another in the cluster, the virtual switches must have the same name on each host in the cluster.

Since Windows Server 2016, it is possible to create a virtual switch with aggregate (SET) without the need to create a network adapter association in Windows.

Classic configuration

The classic mode is to dedicate one or more network cards to a dedicated function: management, live migration, cluster, virtual machines …

- Creating network card teamings (facultative)

- Creating Virtual Switches

- Set IP addresses for management cards and live migration.

Virtual configuration (converged team)

This mode consists of creating an aggregate with all network adapters provided for management, live migration, cluster, virtual machines and then creating virtual network adapters on the Hyper-V host for the functions.

For performance reasons, it is advisable if an iSCSI storage is configured for dedicated network cards.

It is possible to use this solution with a single physical network adapter.

- Create a teaming with all network cards except iSCSI storage cards if necessary, if you want to create a virtual switch with SET aggregate, create the SET virtual switch with the option -AllowManagementOS $ true and go to the point 3.

- Create an external virtual switch by leaving the Allow operating system to share check box checked.

- Create virtual cards on Hyper-V hosts.

- Set IP addresses for management cards and Live Migration

Creating the failover cluster

Now that the environment is ready, it is possible to create the failover cluster to make high-availability virtual machines. After the creation of the cluster, you must configure the disk or disks dedicated to the storage of clustered virtual machines (CSVFS).

Link :

- Failover Clustering Windows 2016/2019 – Installation and Configuration (page 3 and 4)

Configuring the update adapted to the cluster

This feature, introduced with Windows 2012 R2, makes it easy to install Windows updates on a cluster by taking care of role switching and node maintenance.

Link :

- Configuring the Update for Windows Server Clusters (page 1 and 2).

Management and Administration of the Hyper-V Cluster

Now that the cluster is ready, let’s see how to administer it.

Consoles of administration

There are several tools for administering and managing a Hyper-V cluster.

- The Virtual Machine Manager console that allows the administration of virtual machines directly to the Hyper-V node.

- The Failover Cluster Manager console that enables management of virtual machines and the cluster.

- The Admin Center which is a web console that allows the administration of Windows servers.

Overview of different consoles :

Virtual machine management

The administrator of the virtual machines and Hyper-V settings is using the different consoles seen above.

Snapshots are manageable using the Hyper-V Manager Console and the Admin Center. The Failover Cluster Manager console does not support snapshots.

Liens :

- Managing virtual machines in a Windows Server Hyper-V cluster

- Admin Center: Create a Virtual Machine on a Hyper-V Host

Cluster update

Link :

- Update a failover cluster (page 3 and 4)

Compléments

Voici une liste de liens vers des tutoriels traitant d’Hyper-V :

- Hyper-V: Enable Extended Sessions

- Hyper-V: Change the MAC Address of a Virtual Machine

Here is a list of links to tutorials about backup with Hyper-V:

- Altaro backup: installation and use with Hyper-V

- Veeam : Automatically backup virtual machines on Hyper-V

Hyper-V Cluster Setup on Windows Server Machines: A Step-by-Step Guide

One of the critical requirements for virtual infrastructures, especially in large data centers, is the elimination of a single point of failure and ensuring the high availability of services and apps. In a Hyper-V environment, the Microsoft Failover Clustering technology is available to configure multiple Hyper-V hosts (or nodes) that can take over the load if one host fails.

In this step-by-step guide, learn the practical aspects of Hyper-V failover clustering configuration, including initial host and network configuration, Hyper-V role installation, and cluster creation.

Table of Contents

- Hyper-V Host Configuration

- Network Planning

- iSCSI Storage Target Setup

- Installing the Hyper-V role

- Setting up Storage: Adding the iSCSI Portal Address

- Setting up our Virtual Switches

- Creating a Hyper-V Cluster

- Hyper-V Clustered Shared Volumes

- Changing Hyper-V Storage Settings

- Creating a Highly Available VM

Before we start

For a more about this technology, download this complete guide on Hyper-V clustering and learn more about the working principle, requirements, as well as improving data protection with a dedicated backup and DR solution.

Hyper-V Host Configuration

To prepare hosts for failover clustering, we should select an operating system to install on all the hosts that will be used in a particular cluster. Then we need to perform a basic configuration of the environment, including all hosts, to prepare them for Hyper-V cluster setup.

Selecting an operating system to install

In this setup, we are using two Windows Server 2016 Server Core installations to minimize moving parts and to improve security. Using the Windows Server 2016 Server Core installation eliminates a lot of unnecessary components and reduces the footprint. The increased difficulty of administration with Server Core is offset by the benefits of efficiency and security. You can also use the newer Windows Server versions, such as Windows Server 2019 for Hyper-V cluster setup.

Note: For the administration and configuration of Windows Server 2016 Server Core, we use PowerShell. It is technically possible to use Windows Server with Desktop Experience to configure Hyper-V failover clustering.

Initial configuration of the environment

Before thinking about the Hyper-V hosts as a cluster, we must perform our initial configuration of the hosts. This involves much of the same steps of preparing any Windows server – naming, network configuration, patching, etc. Network planning, in particular, is crucial in a Windows cluster as it allows for proper cluster communication as well as communication with shared storage.

- Naming. Both servers have been named and joined to the lab domain. Note that starting with Windows Server 2016, joining a domain is no longer a prerequisite. Server configurations are displayed in the screenshots below for the first server H1. The configurations for the second server H2 are similar.

- Updates. We need to update any prospective Hyper-V cluster nodes to the latest patch level available according to the Hyper-V clustering best practices. Installing updates on Hyper-V hosts improves the security of our system. You may need to restart Windows to complete the installation of updates.

- Consistency. As a best practice, we want all our potential cluster nodes to be configured identically except for computer names and IP addresses. This ensures that everything is standardized between the hosts, including patch levels, networks, etc.

Network Planning

Proper environment planning mitigates many risks in the future. For the lab network in this scenario, four network adapters have been configured for each host. Both lab hosts are not doing any NIC teaming for simplicity sake. However, you would want to team your adapters in production to avoid having a single point of failure in any one network.

For our lab setup, we have:

- Management and VM traffic

- iSCSI

- Private Cluster Traffic

- Live Migration

With the above networks in mind, we assign IP Addresses to each server in our desired subnet ranges. VLANs are also a consideration here, as you will most likely want to align your subnets with VLANs provisioned. This would need to be thought through in advance.

iSCSI Storage Target Setup

Hyper-V cluster storage is a crucial point for building a cluster. For iSCSI storage in a lab environment, in this example, we are using FreeNAS to create iSCSI targets and present these to our Hyper-V cluster. Of course, setting up iSCSI on vendor hardware of your choice or software iSCSI can be different depending on the vendor, so always follow the methods defined for each.

Note: FreeNAS is a universal and flexible FreeBSD-based operating system that you can install on a computer to use it as NAS. You can create a Hyper-V cluster shared storage or build a backup appliance with FreeNAS and the NAKIVO solution.

Below is a quick overview of how the storage for Hyper-V failover clustering is set up using FreeNAS. We won’t delve into all the details of how to set up FreeNAS for iSCSI. However, here are the basic settings for presenting a couple of iSCSI targets to our Hyper-V hosts.

- Start the iSCSI service in FreeNAS and set up your network configuration for the storage network to match what you intend to use for the Hyper-V hosts.

- Check the base IQN setup for the targets that we will create.

- Set up a portal in FreeNAS to listen for iSCSI traffic.

- Set up iSCSI target names. In our FreeNAS appliance, we are setting up:

- a quorum volume to be used as a disk witness

- a volume to be used for the Hyper-V cluster shared volume to house our VMs

Note: Quorum is the mechanism in a Windows cluster that is used to make sure that in the event of something going down between parts of a cluster, you always have a majority of cluster resources available for the cluster to function.

- Starting with Windows Server 2012, every node in the cluster has a single quorum vote by default. By adding an extra vote with a file share, disk, or a new cloud storage account in Windows Server 2016, one part of the cluster should always get more than 50% of the quorum vote by claiming the share, disk, or cloud storage account vote.

- With Windows Server 2012 R2, the recommendation changed to always configure the disk or file share witness. The vote is extended to the additional witness (file share, disk, or cloud storage account) only if there is an even number of nodes. With an odd node number, the witness does not get a vote and isn’t used.

In the screenshot below, we have created the two target names: a quorum volume to be used as a disk witness and a volume to be used for our cluster shared volume.

- Add Extents, which in the below example are mapped to the individual disks that we have physically assigned in our FreeNAS appliance.

- Associate the Target with the Extent. The targets are mapped to the storage in FreeNAS.

Installing the Hyper-V Role

To install the Hyper-V role service, run the following command in a PowerShell command prompt:

Install-WindowsFeature -Name Hyper-V -IncludeAllSubFeature -IncludeManagementTools -Restart

Setting Up Storage: Adding the iSCSI Portal Address

Before adding our iSCSI portal address, we need to configure and start the Microsoft iSCSI service as below:

- Set the service to automatic.

Set-Service -Name msiscsi -StartupType Automatic

- Start the service.

Start-Service msiscsi

- Use PowerShell to add the iSCSI portal address provisioned:

New-iscsitargetportal -targetportaladdress <IP address>

- Connect the specific iSCSI targets that, in our case, were created on our FreeNAS appliance. Below are examples of what we used in adding the FreeNAS targets to the Hyper-V hosts provisioned for the cluster.

- Connect-IscsiTarget -nodeaddress iqn.2005-10.org.freenas.ctl:quorum -IsPersistent $true -IsMultipathEnabled $true -InitiatorPortalAddress 10.0.0.70 -TargetPortalAddress 10.0.0.1

- Connect-IscsiTarget -nodeaddress iqn.2005-10.org.freenas.ctl:hvvol1 -IsPersistent $true -IsMultipathEnabled $true -InitiatorPortalAddress 10.0.0.70 -TargetPortalAddress 10.0.0.1

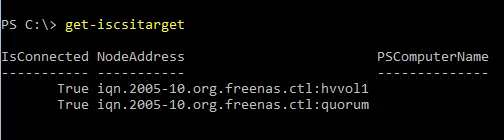

You can verify and see the targets that are added by running the Get-iSCSItarget command.

Note: You can use the get-disk command to show disk information and make sure the Hyper-V cluster shared storage is online and healthy.

Setting Up Virtual Switches

Configuring virtual switches is needed for proper Hyper-V failover cluster network configuration. We can use either PowerShell or Hyper-V Manager to set up our virtual switches for Hyper-V.

An example of the command to create a virtual switch in PowerShell:

New-VMSwitch «ExternalSwitch01» -NetAdapterName «Public» -AllowManagementOS 1

Note: Set up your virtual switch names identically between both hosts as we need to ensure that the virtual switches match, especially when performing a live migration.

Creating a Hyper-V Cluster

Using PowerShell, creating the cluster is a simple one-line commandlet.

- Before creating the cluster, run this command to validate the cluster configuration meets Hyper V clustering best practices:

Test-Cluster H1,H2

- Use the new-cluster commandlet to create a cluster and assign the name, the nodes, and a static IP address to the cluster.

New-Cluster -Name HVCluster -node H1,H2 -staticAddress 192.168.85.75

- When the cluster creation process is finished, you see the output displaying the cluster name in the command line.

Hyper-V Clustered Shared Volumes

Even though we have shared storage from an iSCSI target perspective, we need to make sure the storage that houses our VMs is set up on a Hyper-V clustered shared volume. The clustered shared volume (CSV) was introduced in Windows Server 2008 R2 to be used with the Hyper-V role so that a VM can have VHD files accessed by any node in the cluster. There is also resiliency built into CSV, including I/O fault detection allowed for alternate communication paths to be used in the event of communication failures.

Let’s take a look at creating the clustered shared volume step by step for our VMs.

- Rename the cluster disk resource that will be used for VM storage (optional). In our lab setup, this is Cluster Disk 1:

(Get-ClusterResource | ?{$_.Name -eq «Cluster Disk 1»}).name = «VMs»

- Now we can add this volume to a cluster shared volume:

Get-ClusterResource -Name «VMs»| Add-ClusterSharedVolume

Note: We can also use Failover Cluster Manager to add a disk to the CSV:

- Check the state of the cluster shared volume with the get-clustersharedvolume commandlet.

Note: If you have a management workstation to connect using the Failover Cluster Manager, you can look at storage with the graphical user interface (GUI) by connecting to Windows Failover Cluster. Here we can easily see the Disks available and the roles assigned to them. Below we see both the Quorum and VMs disk that is designated as a cluster shared volume.

Changing Hyper-V Storage Settings

Now that we have our clustered shared volume setup, we can change our Hyper-V settings to use our Hyper-V cluster shared volume as the default location for storing our VMs.

In the Hyper-V Settings for each host, change the Virtual Hard Disks location and the Virtual Machines location to your cluster shared volume, which is C:ClusterStoragevolume(x) on your Hyper-V hosts.

Creating a Highly Available VM

We can now launch Failover Cluster Manager and begin to create a highly available VM.

- Right-click the Roles and choose to create a New Virtual Machine.

- Choose the Hyper-V host (one of the cluster nodes) for the virtual machine.

- Work through the New Virtual Machine Wizard prompts to provision a new virtual machine.

- In the Connect Virtual Hard Disk step of the wizard, ensure that the virtual machine is created on our Hyper-V clustered shared volume.

- The Summary step displays the options we selected.

- When you click finish, the High Availability Wizard displays the summary of enabling high availability on the role and the virtual machine. As you can see, it has been successfully enabled.

- If you want to take a look at the high availability report, you can click the View Report button, which displays a more detailed rendering of the high availability tests.

Hyper-V Failover cluster configuration is finished and we now have a highly available VM running in the cluster. You can create more VMs in your cluster to use Hyper-V High Availability.

Final Thoughts

Hyper-V failover clustering allows you to reduce the downtime of VMs in case of failure. However, this won’t protect your VM data if you don’t have frequent Hyper-V cluster backups. As VMs can migrate between hosts in the Hyper-V failover cluster, VM backup can be a daunting task. Use NAKIVO’s solution and easily back up even those VMs that are running in the cluster. Download the Free Edition to try the functionality in your Microsoft Server and Hyper-V environment.

Руководство по подключению ноды к кластеру Hyper-V с центразизованым хранением VM на СХД lenovo DE2000

В общем случае, получается отказоустойчивое соединение iscsi через два коммутатора к двух контроллерам СХД.

Только по факту используется не 2, как на изображении, а 8 путей подключения

Данная инструкция предусмотрена для подключения к Lenovo DE2000. Для других СХД возможны изменения, но общий принцип остается тем же.

-Hyper-V хост

— установка сервера и драйверов

— включение необходимых ролей и опций (Roles and Features). Установка роли Hyper-V, а также опций Failover Clustering и Multipath IO.

— В свойствах сетевых адаптеров, выделенных для сети СХД должны быть включены Jumbo фреймы:

— найстройка LACP если нужно (через Server manager -> Local Server -> NIC Teaming). IP адреса не присваивать, потом VirtualSwitch не соберется

— Создать VirtualSwitch в Hyper-V manager. Если настроен LACP, выбрать Microsoft Network Adapter Multiplexor driver. Надо обратить внимание на то, чтобы имя виртуального коммутатора было на всех хостах одинаково, например vSwitch0.

- Далее настраивается подключение к СХД. В оснастке iSCSI Initiator на вкладке Discovery необходимо прописать адрес цели и доступные пути до неё.(Discover portal -> ip_shd_1->OK,DicoverPortal -> ip_shd_2->OK и тд)

- На вкладке Targets необходимо выделить цель и перейти в настройку, нажав Connect. Аналогичным образом прописываются все доступные пути к СХД. Список добавленных путей можно посмотреть на вкладке Favorite Targets.(Connect->отметить всё, advanced-> Microsoft_iscsi+HostIp1+ShdIp1, Connect->отметить всё, advanced-> Microsoft_iscsi+HostIp1+ShdIp2 …… Connect->отметить всё, advanced-> Microsoft_iscsi+HostIp2+ShdIp4)

- Установить ПО СХД (storagemanager) в режиме host.

— Запустить failoverCluster Manager и создать кластер. Потребуется указать IP адрес кластера.

— Создать VM для SQL кластера. Есть используется LACP virtual switch, нужно поставить галку в nic teaming в advanced features сетевого адаптера.

-SQL cluster-

— установить WIN сервер

— установка SQL сервера 2017 standart.

Компоненты:

— Службы ядра СУБД

Идентификатор экземпляра

— MSSQLSERVER

Учетные записи служб

— Агент SQL сервер — авто

— ядро СУБД SQL сервер — авто

— обохреватель SQL сервер — Отключено

Конфигурация сервера

— смешанный режим.

— указать sa пароль

— добавить администраторов сервера

Каталоги данных

— указать пути баз на SSD диск

— указать пути для бэкапов

TempDB

— на SSD

— Установить роль FailoverCluaster

— Включение режима поддержки AlwaysOn SQL servera

(рекомендуется запускать от доменной учетки)

— Запустить диспетчер конфигурации SQL Server 2017

— Выбрать свойства службы SQL Server

— На вкладке «Высокий уровень доступности AlwaysOn» установить флажок

— проверить, что в имени кластера указан тот кластер, который требуется

— Перезапустить службу SQL Server (действия по правой кнопке мыши на записи службы)

— Убедиться, что на сервере БД доступен режим Высокий уровень доступностиˆ

— настройки работы с памятью и тд

— в SSMS выбрать свойства сервера

— память: нижний — 2048, верхний — (полный объем на сервере минус 4-8Гб)

— процессоры: максимальное число раб. потоков 2048, галка «поддерживать приоритет…»

— дополнительно:

максимальная степень параллелизма — 4

стоимостный порог — 45

— Добавление перекрестно пользователей SQL

Для кластеров добавить перекрестно учетные записи экземпляров SQL Server с правами создания БД (ниже описание для инстансов SQL Server под локальной учетной записью)

Шаблон скрипта добавления

USE [master]

GO

CREATE LOGIN [VZLJOTotherservername$] FROM WINDOWS WITH DEFAULT_DATABASE=[master]

CREATE LOGIN [VZLJOTsql-serv] FROM WINDOWS WITH DEFAULT_DATABASE=[master]

GO

ALTER SERVER ROLE [dbcreator] ADD MEMBER [DOMAINotherservername$]

ALTER SERVER ROLE [dbcreator] ADD MEMBER [DOMAINsql-serv]

GO

— Создаем endpoint на каждом сервере и перекрестно предоставляем права

CREATE ENDPOINT Hadr_endpoint

AS TCP

(

LISTENER_PORT = 5022

)

FOR DATA_MIRRORING

(

ROLE = ALL,

ENCRYPTION = REQUIRED ALGORITHM AES

)

GO

GRANT CONNECT ON ENDPOINT::Hadr_endpoint TO [DOMAINalmaaz$]

Проверка наличия:

SELECT * FROM sys.endpoints WHERE type = 4

— Создать группы доступности для каждой базы

— открыть SMSS

— Высокий уровень доступности — мастер:

— автоматический переход на другой ресурс (галка)

— синхронная фиксация

— посмотреть результат «показать панель мониторинга»

Полезные команды:

Включение роли Hyper-V

Install-WindowsFeature hyper-v

Список машин на хосте

Get-VM

Получение ID машины

get-vm -Name «Test Win10» | Select-Object id

Старт машины

Start-VM -Name

Создание снэпшота

Get-VM -Name | Checkpoint-VM -SnapshotName for snapshot>

Создание машины

$VMName = «VMNAME»

$VM = @{

Name = $VMName

MemoryStartupBytes = 2147483648

Generation = 2

NewVHDPath = «C:Virtual Machines$VMName$VMName.vhdx»

NewVHDSizeBytes = 53687091200

BootDevice = «VHD»

Path = «C:Virtual Machines$VMName»

SwitchName = (Get-VMSwitch).Name

}

New-VM @VM

Скрипт для вложенном виртуализации, докера и тд

#replace with the virtual machine name

$vm = «»

#configure virtual processor

Set-VMProcessor -VMName $vm -ExposeVirtualizationExtensions $true -Count 2

#disable dynamic memory

Set-VMMemory -VMName $vm -DynamicMemoryEnabled $false

#enable mac spoofing

Get-VMNetworkAdapter -VMName $vm | Set-VMNetworkAdapter -MacAddressSpoofing On

Veeam Backup and replication

Решение проблемы фэйла бэкапа VM:

Processing VM Error: Incorrect function.

Agent failed to process method {ReFs.SetFileIntegrity}.

Сjздать в реестре сервера veeam ключ:

HKLMSOFTWAREVeeamVeeam Backup and Replication

REG_DWORD (32-bit)

Name UseCifsVirtualSynthetic

Value 0

Перенос в Hyper-V. Гостевая система bsod.

Загрузиться в виртуалке с какого-нибудь liveCD.

Regedit’ом встать на HKEY_LOCAL_MACHINE

Подгрузить куст WindowsSystem32configSYSTEM из склонированной системы под имененм 123.

Найти в нем ключи

- Atapi

- Intelide

- LSI_SAS

Исправить параметры Start и изменить на 0.

Выгрузить куст.

Возникновение в linux системах спама вида:

systemd[1]: Time has been changed

— отключить службу синхронизации времени в параметрах VM

Сервера программных лицензий

Если на виртуалке имеется сервер лицензий, привязанный к MAC адресу, надо сделать MAC адрес в параметрах статическим.

Машина в статусе «Сохранена» (Saved)

Get-VMSnapshot «Porrima win19» | Remove-VMSavedState

Remove-VMSavedState «Porrima win19»

Машина зависла. Нужно принудительно ее выключить.

Найти ID машины:

get-vm -Name «Test Win10» | Select-Object id

Запустить Диспетчер задач (Task Manager).

Найти процесс vmwp с ID машины и убить его

Руководство по подключению ноды к кластеру Hyper-V с центразизованым хранением VM на СХД lenovo DE2000

В общем случае, получается отказоустойчивое соединение iscsi через два коммутатора к двух контроллерам СХД.

Только по факту используется не 2, как на изображении, а 8 путей подключения

Данная инструкция предусмотрена для подключения к Lenovo DE2000. Для других СХД возможны изменения, но общий принцип остается тем же.

-Hyper-V хост

— установка сервера и драйверов

— включение необходимых ролей и опций (Roles and Features). Установка роли Hyper-V, а также опций Failover Clustering и Multipath IO.

— В свойствах сетевых адаптеров, выделенных для сети СХД должны быть включены Jumbo фреймы:

— найстройка LACP если нужно (через Server manager -> Local Server -> NIC Teaming). IP адреса не присваивать, потом VirtualSwitch не соберется

— Создать VirtualSwitch в Hyper-V manager. Если настроен LACP, выбрать Microsoft Network Adapter Multiplexor driver. Надо обратить внимание на то, чтобы имя виртуального коммутатора было на всех хостах одинаково, например vSwitch0.

- Далее настраивается подключение к СХД. В оснастке iSCSI Initiator на вкладке Discovery необходимо прописать адрес цели и доступные пути до неё.(Discover portal -> ip_shd_1->OK,DicoverPortal -> ip_shd_2->OK и тд)

- На вкладке Targets необходимо выделить цель и перейти в настройку, нажав Connect. Аналогичным образом прописываются все доступные пути к СХД. Список добавленных путей можно посмотреть на вкладке Favorite Targets.(Connect->отметить всё, advanced-> Microsoft_iscsi+HostIp1+ShdIp1, Connect->отметить всё, advanced-> Microsoft_iscsi+HostIp1+ShdIp2 …… Connect->отметить всё, advanced-> Microsoft_iscsi+HostIp2+ShdIp4)

- Установить ПО СХД (storagemanager) в режиме host.

— Запустить failoverCluster Manager и создать кластер. Потребуется указать IP адрес кластера.

— Создать VM для SQL кластера. Есть используется LACP virtual switch, нужно поставить галку в nic teaming в advanced features сетевого адаптера.

-SQL cluster-

— установить WIN сервер

— установка SQL сервера 2017 standart.

Компоненты:

— Службы ядра СУБД

Идентификатор экземпляра

— MSSQLSERVER

Учетные записи служб

— Агент SQL сервер — авто

— ядро СУБД SQL сервер — авто

— обохреватель SQL сервер — Отключено

Конфигурация сервера

— смешанный режим.

— указать sa пароль

— добавить администраторов сервера

Каталоги данных

— указать пути баз на SSD диск

— указать пути для бэкапов

TempDB

— на SSD

— Установить роль FailoverCluaster

— Включение режима поддержки AlwaysOn SQL servera

(рекомендуется запускать от доменной учетки)

— Запустить диспетчер конфигурации SQL Server 2017

— Выбрать свойства службы SQL Server

— На вкладке «Высокий уровень доступности AlwaysOn» установить флажок

— проверить, что в имени кластера указан тот кластер, который требуется

— Перезапустить службу SQL Server (действия по правой кнопке мыши на записи службы)

— Убедиться, что на сервере БД доступен режим Высокий уровень доступностиˆ

— настройки работы с памятью и тд

— в SSMS выбрать свойства сервера

— память: нижний — 2048, верхний — (полный объем на сервере минус 4-8Гб)

— процессоры: максимальное число раб. потоков 2048, галка «поддерживать приоритет…»

— дополнительно:

максимальная степень параллелизма — 4

стоимостный порог — 45

— Добавление перекрестно пользователей SQL

Для кластеров добавить перекрестно учетные записи экземпляров SQL Server с правами создания БД (ниже описание для инстансов SQL Server под локальной учетной записью)

Шаблон скрипта добавления

USE [master]

GO

CREATE LOGIN [VZLJOT\otherservername$] FROM WINDOWS WITH DEFAULT_DATABASE=[master]

CREATE LOGIN [VZLJOT\sql-serv] FROM WINDOWS WITH DEFAULT_DATABASE=[master]

GO

ALTER SERVER ROLE [dbcreator] ADD MEMBER [DOMAIN\otherservername$]

ALTER SERVER ROLE [dbcreator] ADD MEMBER [DOMAIN\sql-serv]

GO

— Создаем endpoint на каждом сервере и перекрестно предоставляем права

CREATE ENDPOINT Hadr_endpoint

AS TCP

(

LISTENER_PORT = 5022

)

FOR DATA_MIRRORING

(

ROLE = ALL,

ENCRYPTION = REQUIRED ALGORITHM AES

)

GO

GRANT CONNECT ON ENDPOINT::Hadr_endpoint TO [DOMAIN\almaaz$]

Проверка наличия:

SELECT * FROM sys.endpoints WHERE type = 4

— Создать группы доступности для каждой базы

— открыть SMSS

— Высокий уровень доступности — мастер:

— автоматический переход на другой ресурс (галка)

— синхронная фиксация

— посмотреть результат «показать панель мониторинга»

Полезные команды:

Включение роли Hyper-V

Install-WindowsFeature hyper-v

Список машин на хосте

Get-VM

Получение ID машины

get-vm -Name «Test Win10» | Select-Object id

Старт машины

Start-VM -Name

Создание снэпшота

Get-VM -Name | Checkpoint-VM -SnapshotName for snapshot>

Создание машины

$VMName = «VMNAME»

$VM = @{

Name = $VMName

MemoryStartupBytes = 2147483648

Generation = 2

NewVHDPath = «C:\Virtual Machines\$VMName\$VMName.vhdx»

NewVHDSizeBytes = 53687091200

BootDevice = «VHD»

Path = «C:\Virtual Machines\$VMName»

SwitchName = (Get-VMSwitch).Name

}

New-VM @VM

Скрипт для вложенном виртуализации, докера и тд

#replace with the virtual machine name

$vm = «»

#configure virtual processor

Set-VMProcessor -VMName $vm -ExposeVirtualizationExtensions $true -Count 2

#disable dynamic memory

Set-VMMemory -VMName $vm -DynamicMemoryEnabled $false

#enable mac spoofing

Get-VMNetworkAdapter -VMName $vm | Set-VMNetworkAdapter -MacAddressSpoofing On

Veeam Backup and replication

Решение проблемы фэйла бэкапа VM:

Processing VM Error: Incorrect function.

Agent failed to process method {ReFs.SetFileIntegrity}.

Сjздать в реестре сервера veeam ключ:

HKLM\SOFTWARE\Veeam\Veeam Backup and Replication\

REG_DWORD (32-bit)

Name UseCifsVirtualSynthetic

Value 0

Перенос в Hyper-V. Гостевая система bsod.

Загрузиться в виртуалке с какого-нибудь liveCD.

Regedit’ом встать на HKEY_LOCAL_MACHINE

Подгрузить куст \Windows\System32\config\SYSTEM из склонированной системы под имененм 123.

Найти в нем ключи

- Atapi

- Intelide

- LSI_SAS

Исправить параметры Start и изменить на 0.

Выгрузить куст.

Возникновение в linux системах спама вида:

systemd[1]: Time has been changed

— отключить службу синхронизации времени в параметрах VM

Сервера программных лицензий

Если на виртуалке имеется сервер лицензий, привязанный к MAC адресу, надо сделать MAC адрес в параметрах статическим.

Машина в статусе «Сохранена» (Saved)

Get-VMSnapshot «Porrima win19» | Remove-VMSavedState

Remove-VMSavedState «Porrima win19»

Машина зависла. Нужно принудительно ее выключить.

Найти ID машины:

get-vm -Name «Test Win10» | Select-Object id

Запустить Диспетчер задач (Task Manager).

Найти процесс vmwp с ID машины и убить его

Table Of Contents

- Introduction

- Prerequisites

- Preparation of the environment

- Installing roles

- Configuring roles and features

- MPIO

- Hyper-V: network configuration

- Classic configuration

- Virtual configuration (converged team)

- Creating the failover cluster

- Configuring the update adapted to the cluster

- Management and Administration of the Hyper-V Cluster

- Consoles of administration

- Virtual machine management

- Cluster update

- Compléments

Introduction

Through this tutorial, we will see how to set up a Hyper-v cluster under Windows Server (2012R2 / 2016/2019) step by step.

Each step requires it, will take you on a tutorial to guide you in setting up a Hyper-V cluster.

Prerequisites

- Be in an Active Directory environment, ideally having a server-side domain controller that is not a member of the Hyper-V cluster.

- Have at least 2 identical servers (identical hardware configuration: cpu, ram, network card, bios …) under Windows 2012R2 / 2016/2019 members of the same domain.

- Have a storage type SAN (iSCSI / FC / SAS) and control its operation.

Since Windows Server 2016, it is possible to create a WorkGroup cluster without an Active Directory domain. This configuration is not recommended with the Hyper-V role because dynamic migration is not supported.

Preparation of the environment

On each server that will be in the cluster:

- Have the same version of bios and firmware of the different hardware components (RAID controller, network card, FC card …).

- Install the same version of Windows Server with the same level of update.

- Install the drivers of the different hardware components.

- Prepare at least two LUNs for the cluster

- Disk 1 to 10 GB for Quorum.

- Disk for storing computers to virtual.

- Prepare network configurations

- Management network

- Network live migration dedicated to the cluster

- Network of virtual machines

- Configure VLANs on assets if necessary.

Lien :

- Prepare the Quorum for the cluster. (page 1)

Installing roles

A Hyper-V cluster relies on several elements:

- The Hyper-V role that is the hypervisor for running virtual machines.

- The Failover Cluster feature that will enable high availability of the Hyper-V role.

- The MPIO feature that allows you to manage multi-way to storage.

The 3 elements can be installed simultaneously.

Links to the different tutorials:

- Hyper-V: installation on Windows Server 2012R2/2016/2019

- Installing the Failover Clustering feature (page 2)

- Installation of the MPIO if necessary according to the SAN (page 2).

Configuring roles and features

MPIO

On each server, it is necessary to configure the MPIO functionality to take into account multiple paths.

Before the configuration, present to each server the LUNs.

Link:

- MPIO configuration (page 3 et 4).

Hyper-V: network configuration

The network configuration is an important step in setting up the Hyper-V cluster.

There are two main types of configurations that are detailed after, so choose the one that suits you best.

Personally, I prefer the converged solution that offers more flexibility and less configuration on assets.

For failover to occur from one node to another in the cluster, the virtual switches must have the same name on each host in the cluster.

Since Windows Server 2016, it is possible to create a virtual switch with aggregate (SET) without the need to create a network adapter association in Windows.

Classic configuration

The classic mode is to dedicate one or more network cards to a dedicated function: management, live migration, cluster, virtual machines …

- Creating network card teamings (facultative)

- Creating Virtual Switches

- Set IP addresses for management cards and live migration.